【现象】:业务每天都是先删除数据 后入数

tidb_tikvclient_backoff_seconds_count参数调大到1000 后,还是频繁告警。再继续调整阀值,那这个监控的意义有什么?除了调整阀值,还可以进行哪些优化?

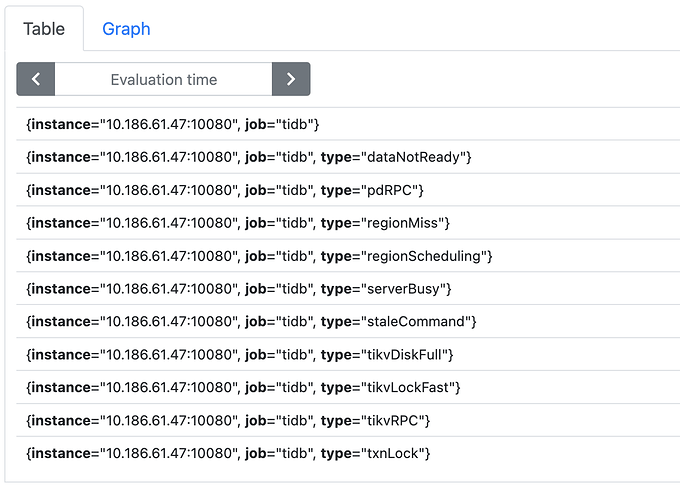

看下监控 TiDB -> kv errrors和tikv detail -> errors哪些比较高

tidb_tikvclient_backoff_seconds_count是tidb中比较常见的告警了,可以参考以下帖子

1 个赞

看了的。既然这个这么容易出现 初始化的阀值这么低是基于什么考虑的?我也不可能无限调高阀值 。加这个监控的意义在哪里?如果只是修改值的话。

主要还是region调度问题 发生这个告警的时间段 伴随大量写入。

- 请问,监控 kv error 中看到的主要的 backoff 是什么?

- 对应到报错时发生的问题,是由于大量写入,region 分裂,或者 balance 导致的吗?

- 参考帖子 [FAQ] Grafana Metrics 页面的导出和导入 导出下发生告警时间段的 PD 和 TiKV 监控

主要是not leader。

只有regionmiss有数值 其他都是0

查看tidb_slow_query.log 中有很多regionmiss信息。

查看tikv.log中有很多 Region error (will back off and retry) message警告。

backoff次数增加,会导致sql性能变慢,同时体现有pd访问tso的次数增加。

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。