【 TiDB 使用环境】生产环境

【 TiDB 版本】v4.0.9

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

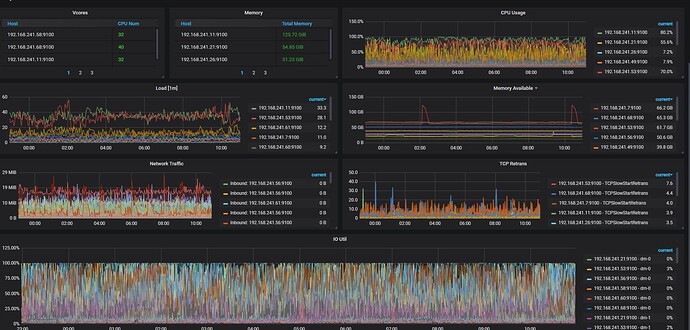

集群tikv节点IO 负载很高,这个状态正常吗?是版本的问题还是啥? 我现在使用的版本有点低,升级版本IO会不会好呢?

ps:我们TIKV节点都是普通 sata ssd,不是nvme ssd.

【资源配置】

【附件:截图/日志/监控】

参考下~

感觉是硬件没达到要求,先检查一下磁盘性能是否满足要求。

通过

sudo fio -ioengine=psync -bs=32k -fdatasync=1 -thread -rw=randread -size=10G -filename=fio_randread_test -name='fio randread test' -iodepth=4 -runtime=60 -numjobs=4 -group_reporting --output-format=json --output=fio_randread_result.json

测试的 rand read iops 不低于 40000

通过

sudo fio -ioengine=psync -bs=32k -fdatasync=1 -thread -rw=randrw -percentage_random=100,0 -size=10G -filename=fio_randread_write_test -name='fio mixed randread and sequential write test' -iodepth=4 -runtime=60 -numjobs=4 -group_reporting --output-format=json --output=fio_randread_write_test.json

测试的 rand read iops 不低于 10000

seq write iops 不低于 10000

通过

sudo fio -ioengine=psync -bs=32k -fdatasync=1 -thread -rw=randrw -percentage_random=100,0 -size=10G -filename=fio_randread_write_latency_test -name='fio mixed randread and sequential write test' -iodepth=1 -runtime=60 -numjobs=1 -group_reporting --output-format=json --output=fio_randread_write_latency_test.json

测试的 rand read lat 不高于 250000ns

seq write lat 不高于 30000ns

2 个赞

是 nvme 的盘 io util 100% 么?这玩意好像在 nvme 盘上不是很准

肯定不正常

表妹回答的好专业呀 是表妹自己吗

不是 搜索出来的~hhhhhh

平时 IO util 大概多少?只是某段时间到100%了吗?

IO util到100%你的系统的读写应该都会很慢了,业务基本反应就是卡的要死。

应该是硬盘的IO性能不高导致的,

我想问下: 后面的新版本对IO这块有没有优化的?

一直都是如图的IO水平 ![]()

只是有些节点低点有些节点高

这CPU看起来也不低啊,有没有慢SQL什么的

看监控的同时看看,sql的热点分布。从你截图中看,集群应该是部署在k8s上面的吧。存储怎么做得。通过监控可以看的到其中两个kv节点负载有点高。

慢SQL也有,但不多

不是k8s部署,就是机房物理机

看像是一台机器上有多个节点,每个tikv节点是否在存储上物理隔离。

是的,每个tikv都是单独的物理机,单独的sata ssd

IO util这个值是指每秒有多少时间存在IO,代表的是IO持续时间,并不能真正的代表IO负载达到瓶颈了。最主要还是看SQL响应有没有变慢