版本:5.0.3

前面同步正常,在研发人员写入400W条数后同步停止,checkpoint一直停留在12:11分,

看了下表大小 也才170M,咋会这样。。。

下游为mysql

"summary": {

"state": "normal",

"tso": 426466525331849259,

"checkpoint": "2021-07-21 12:11:28.064",

"error": null

}

cdc节点日志如下

1.txt (166.8 KB)

急~在线等!。。

2 个赞

spc_monkey

(carry@pingcap.com)

2

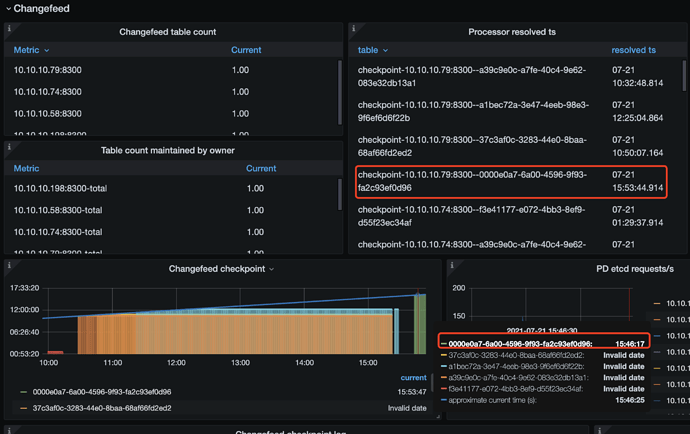

1、查看 cdc 的监控,resloved tso 看看又没有变化

2、查看 cdc 的数据目录下,空间使用 有没有变化

3、查看 cdc 的 日志,有无异常

2 个赞

spc_monkey

(carry@pingcap.com)

3

看日志无异常,大概率是由于上游写入量太大,导致 cdc 内部工作较重(比如排序中),可以看看 cdc 的内存使用情况(监控)

2 个赞

1、resloved tso 没有变化

2、cdc数据目录使用 没有变化

3、cdc的日志 在上面已经有提供过了, 感觉没啥异常

4. cdc的内存使用 总数据才170M, cdc内存使用6G左右,后面就时没啥变动了。

2 个赞

spc_monkey

(carry@pingcap.com)

5

1 个赞

目前task 只有一个 cdc节点有4个, 只同步3张表, 我有怀疑是不是我单事务太大 导致的他卡住。cdc有这方面的参考数值吗?

1 个赞

spc_monkey

(carry@pingcap.com)

12

你的监控显示,其他几个 changefeed 状态有问题,要不你先检查一下(如果是不用的,可以删除掉)

1 个赞

spc_monkey

(carry@pingcap.com)

14

能不能 cdc 的日志(所有实例的 日志都给一下吗)现在还是不同状态是吧(你的 checkpoint 看起来时间不是12点的)

上面的截图 是我后面重新做的。 为了验证是不是那个导入400万数据卡住的原因,现在确实是因为他才卡住的

这个是这个时间段的日志

cdc_log.rar (39.0 KB)

spc_monkey

(carry@pingcap.com)

16

问一下,你在 12:11 之后,是又做什么操作了吗?(另外,我看 cdc 的日志,大部分是 到 16:00 之前的,以后是没有日志了吗?现在的 cdc日志内容是什么?)

问一下,你在 12:11 之后,是又做什么操作了吗?(另外,我看 cdc 的日志,大部分是 到 16:00 之前的,以后是没有日志了吗?现在的 cdc日志内容是什么?)

12:11 之后 在14点左右 增加过

worker-count=16&max-txn-row=2000

这个配置

16点之后就做了次新的同步,其他没有了, 目前新的同步 也处于没同步的状态

16点之后的日志我重新提交下,grafana的也一起

tidb-pro-TiCDC_2021-07-21T09_45_52.028Z.rar (215.0 KB)

cdc-log.rar (19.8 KB)

spc_monkey

(carry@pingcap.com)

18

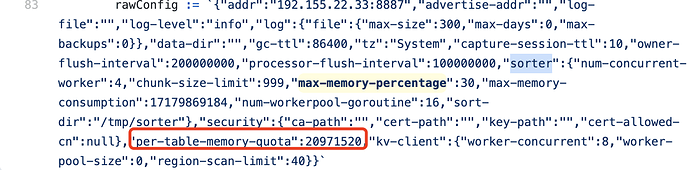

添加个参数: per-table-memory-quota 设置为 6M 吧(和其他修改其他参数一样)

max-txn-row=5000&worker-count=32&per-table-memory-quota=6M 这样加的 没错把?

spc_monkey

(carry@pingcap.com)

20

不是,这个是 cdc-server 的参数,需要重启 server ,tiup edit-config 就行,per-table-memory-quota: