为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】V5.0.1

【问题描述】

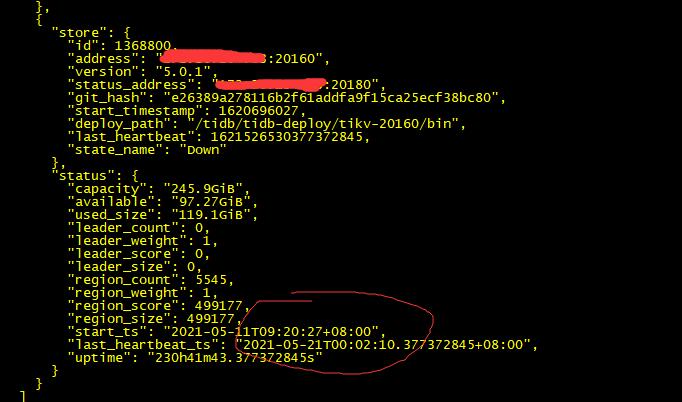

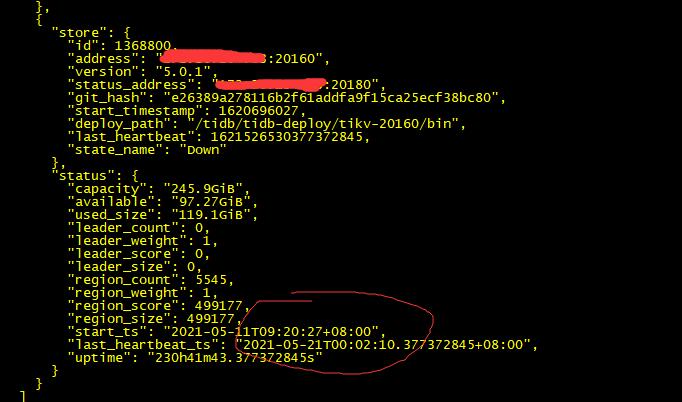

1、Tikv 五节点 三副本。

2、其中一个节点down,超过两天,状态仍然为down,没有变为Tombstone。

3、大量region down,但是不调度。

![]()

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】V5.0.1

【问题描述】

1、Tikv 五节点 三副本。

2、其中一个节点down,超过两天,状态仍然为down,没有变为Tombstone。

3、大量region down,但是不调度。

![]()

这个问题,辛苦提供下下面的信息:

1、PD Grafana 监控,时间段为 5 月 21 号 00:00 到 5 月 22 号 00:00

2、pd-ctl config show all 信息

3、pd-ctl store 拿下所有 store 的信息

状态为 down 的 tikv 节点,tikv 进程还存活着么?

offline 状态的节点可以变为 tombstone , down 状态的节点不能自动变为 tombstone

主机直接关机导致的tikv节点下线,当前状态是down。

但是这样会有问题吧,所有异常下线的tikv节点不会转为tombstone?

另外大量down-peer是否意味着副本缺失?没有在剩余4个节点上补副本?

通过正常的下线流程下线 tikv 节点的话,节点状态会从 offine 状态变成 tombstone 完成下线。

对于异常下线的 tikv 节点,当 down 时间超过 max-store-down-time 设置的值(默认是 30 分钟) 之后,TiDB 会在其他剩余的健康 tikv 节点上补全对应的副本。

如果要清理这些 down-peer 的话,需要对应的 tikv 实例重新拉起来,让 PD 调度清理。如果实例无法启动的话,这些 down-peer 正常也是不会影响的。