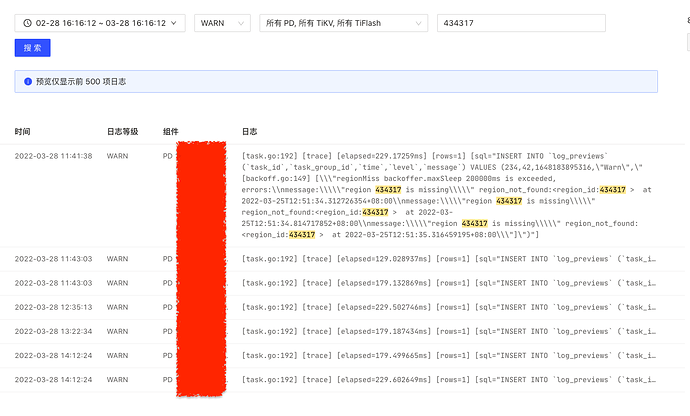

重新把静默region 关闭了,然后 reload了一下 tikv 节点还是 pending offline状态

» region --jq=".regions[] | {id: .id, peer_stores: [.peers[].store_id] | select(length == 5)}"

{“id”:434317,“peer_stores”:[1,4,5,390553,390554]}

» region --jq=".regions[] | {id: .id, peer_stores: [.peers[].store_id] | select(length == 2)}"

region数量为2的没有,region数量是5的是有的,而且就是问题 region号

» region 434317

{

"id": 434317,

"start_key": "748000000000002DFFB95F720000000000FA",

"end_key": "748000000000002DFFB95F728000000003FF3F16990000000000FA",

"epoch": {

"conf_ver": 7,

"version": 4204

},

"peers": [

{

"id": 434318,

"store_id": 1,

"role_name": "Voter"

},

{

"id": 434319,

"store_id": 4,

"role_name": "Voter"

},

{

"id": 434320,

"store_id": 5,

"role_name": "Voter"

},

{

"id": 434321,

"store_id": 390553, <--- 这个store_id 是从4.0.x升上来的store_id

"role": 1,

"role_name": "Learner",

"is_learner": true

},

{

"id": 434322,

"store_id": 390554, <--- 这个store_id 是从4.0.x升上来的store_id

"role": 1,

"role_name": "Learner",

"is_learner": true

}

],

"leader": {

"role_name": "Voter"

},

"written_bytes": 0,

"read_bytes": 0,

"written_keys": 0,

"read_keys": 0,

"approximate_size": 0,

"approximate_keys": 0

}

比较奇怪是5副本,咋把region的副本搞掉呀?(没有 leader 的状态)