1 个赞

检查下这台server 的cpu 网络 磁盘情况

1 个赞

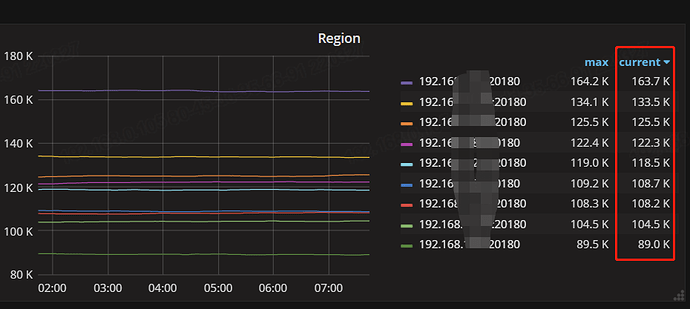

看一下各个store的region和评分情况

1 个赞

3 个赞

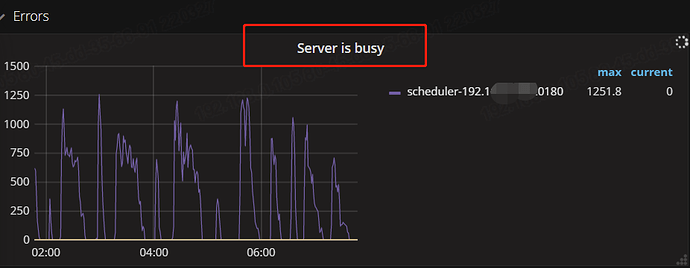

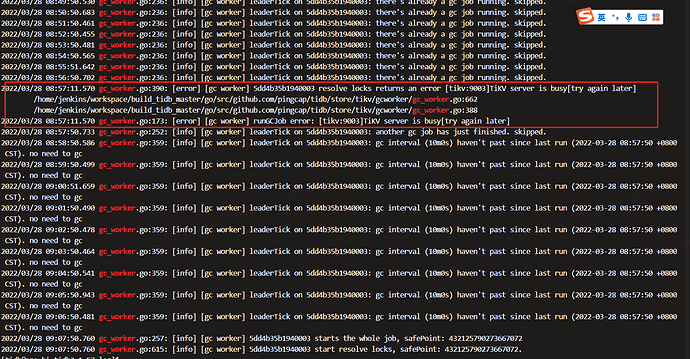

我今天看了这个,对照这个做了参数调整,但发现目前还是没有效果

1 个赞

我通过DROP大表,希望每个TIKV节点的region可以降下来,但等了4-5个小时,目前还是没有降低

1 个赞

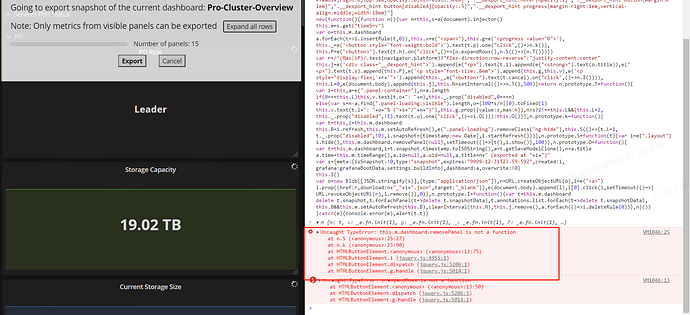

https://metricstool.pingcap.com/#backup-with-dev-tools 按此方式将问题前20分钟和问题时间段监控快照导致,包括overview/pd/detail/tidb

1 个赞

个人建议暂时先别DROP大表等操作,DROP大表后,空region变多,调度变多了,故障会更难排查

现在没有做这个动作,昨天做了大表的DROP

嗯,稳住![]()

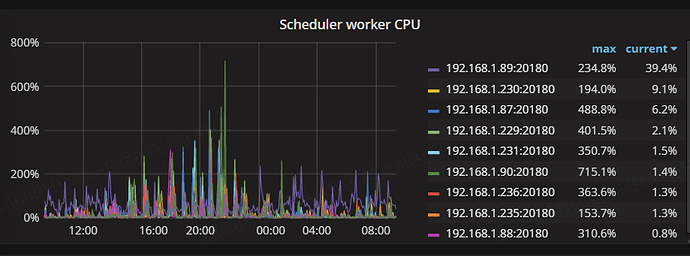

看看tikv-details–>thread CPU–>scheduler work cpu 这个监控图

1 个赞

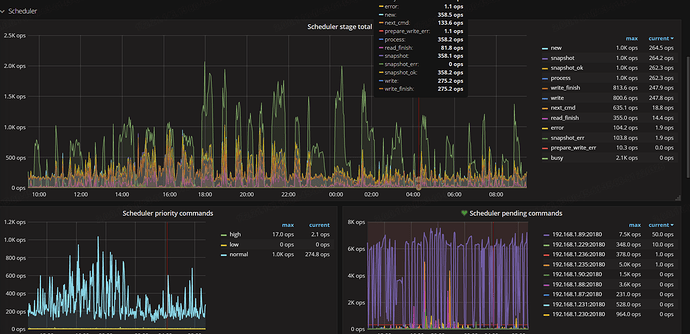

再看看

TiKV-Details --> Scheduler --> Scheduler writing bytes

1 个赞

TIKV的监控里面没有找到这个指标

![]() 忘问你tidb集群版本多少?5.0?

忘问你tidb集群版本多少?5.0?

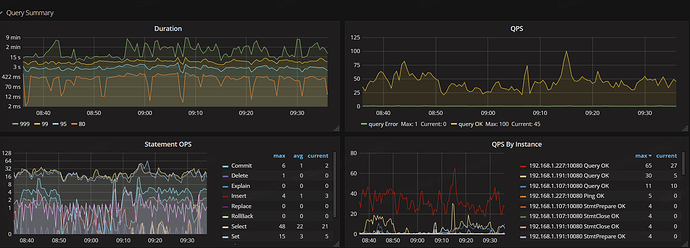

TiDB → Query Summary → Statement QPS看看业务流量变化

1 个赞

![]() tidb v3.0好多监控参数比v5.0少呀

tidb v3.0好多监控参数比v5.0少呀

TiKV-Details–>Scheduler pending commands如果这个没有 来个TiKV-Details