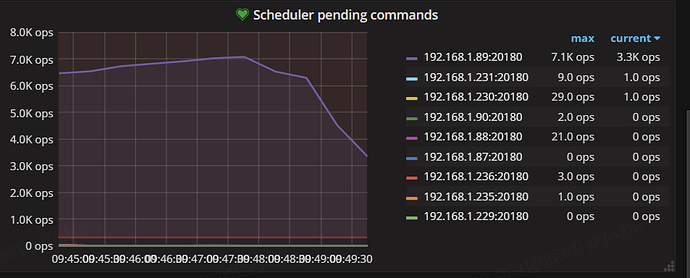

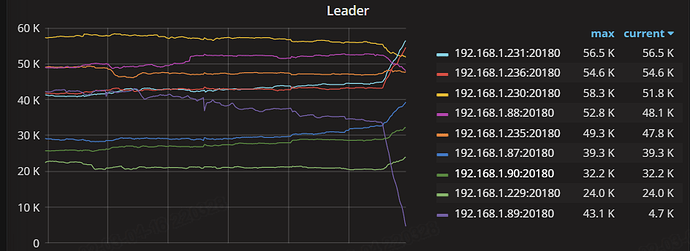

现在就是这个89的节点,tikv 一直在报

引用

2022/03/28 09:47:17.354 region_request.go:220: [warning] tikv reportsServerIsBusy, reason: scheduler is busy, ctx: &{{47338827 91658 11221} id:47338827 start_key:"

t\200\000\000\000\000\000\000\025_r\200\000\000\000\002\017\232\024" end_key:“t\200\000\000\000\000\000\000\025_r\200\000\000\000\002\017\266@” region_epoch:<conf_ver:91658 version:11221 > peers:<id:47338828 store_id:32769177 > peers:<id:47338829 store_id:31906230 > peers:<id:47338830 store_id:32769175 > id:47338829 store_id:31906230 192.168.1.89:20160}, retry later

tikv繁忙,试试pd-ctl add scheduler evict-leader-scheduler xx 把这个store加个victor leader调度,暂时不让这上面有leader运行,看下这机器的Node_exporter 监控 看看有什么异常没

好的,我加上这个参数试试, 已经添加了 evict参数 add scheduler evict-leader-scheduler

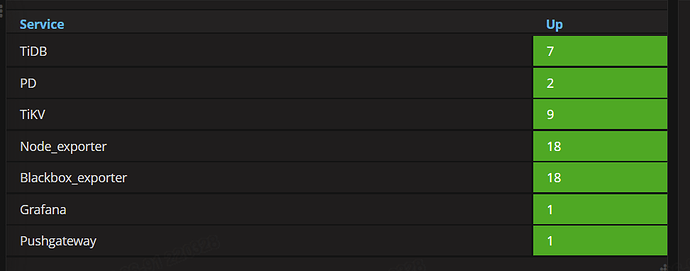

Node_exporter 这个监控是在哪个路径?

xx是对应的store id

Node_exporter监控在根目录

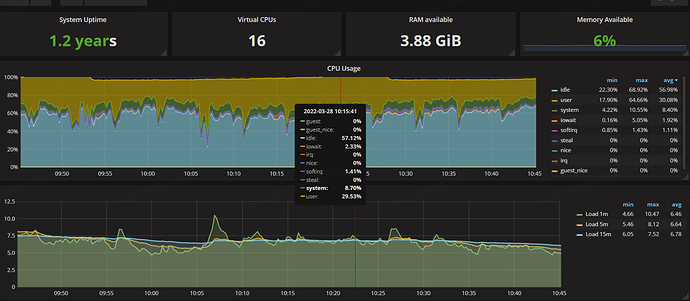

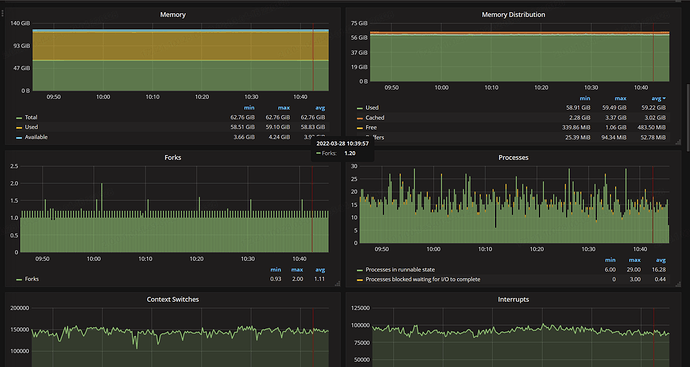

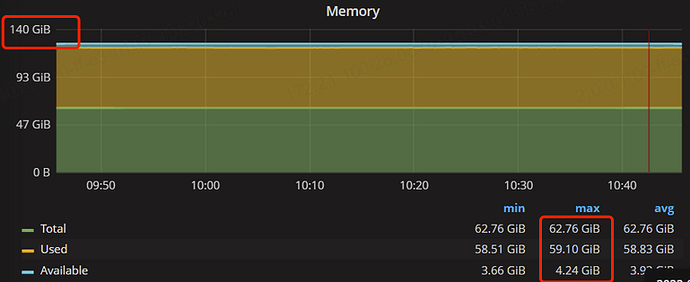

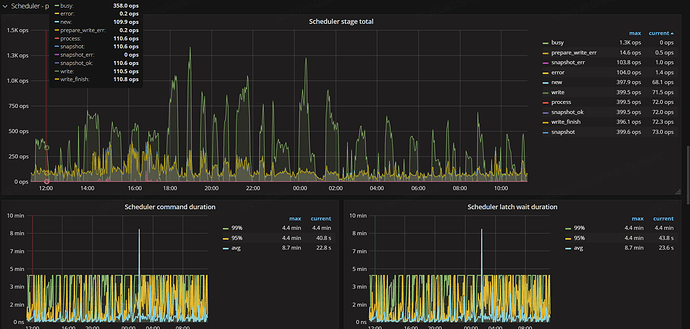

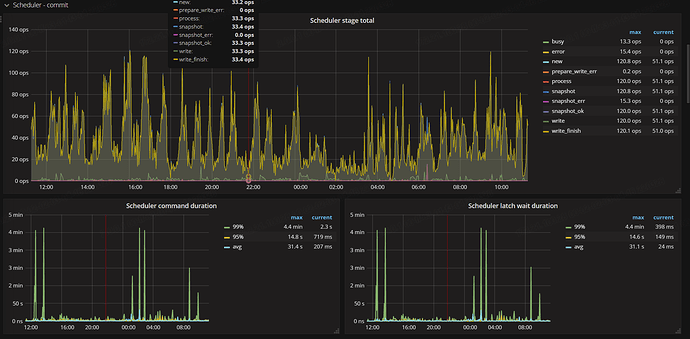

通过分析上面的监控和日志信息,可以确认 89 这个 TiKV 节点压力较大,scheduler 有大量 commands 积压。可以先确认下这个节点的状况:

- 这个节点硬件配置是否和其它节点不同?(如果不同,应该少负担写读写压力)

- 这个节点是否有特殊配置?比如是否调整过 TiKV 相关参数;

- 可以看下这个节点是否存在“热写”情况;

- 再看下这个节点是否有其他异常。

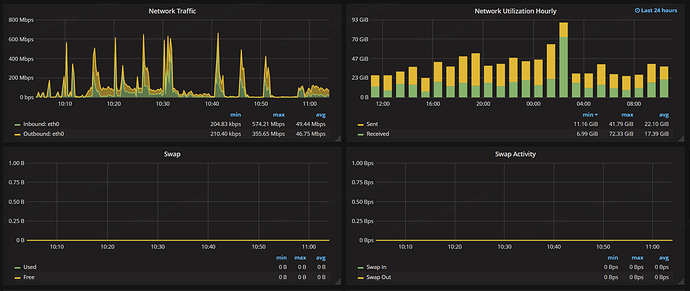

下面磁盘 和网络方面

1、89节点的配置和其他服务器都是一样的

2、目前来看没有对89做过特殊的参数调整,除了 添加此参数 pd-ctl add scheduler evict-leader-scheduler xx

3、热写的TIKV监控

各位大佬,有什么方法可以处理掉吗?

现在这个集群性能在下降

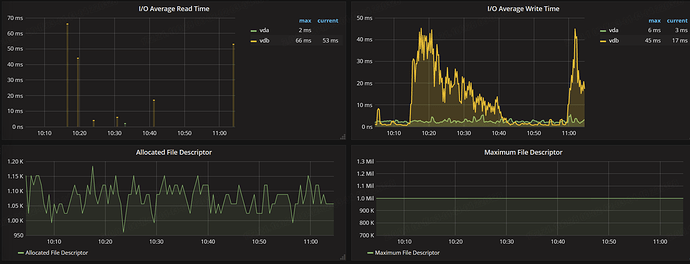

只对这个leader有效,看上面的图IO util有一点变化,平均io时间都30ms以上了,这机器磁盘有问题吧

之前还只有89那台出问题,现在全部都server is busy

pd-ctl config show看下

» config show

{

“max-snapshot-count”: 3,

“max-pending-peer-count”: 16,

“max-merge-region-size”: 10,

“max-merge-region-keys”: 50000,

“split-merge-interval”: “1h0m0s”,

“patrol-region-interval”: “100ms”,

“max-store-down-time”: “30m0s”,

“leader-schedule-limit”: 8,

“region-schedule-limit”: 100,

“replica-schedule-limit”: 4,

“merge-schedule-limit”: 8,

“tolerant-size-ratio”: 5,

“low-space-ratio”: 0.8,

“high-space-ratio”: 0.6,

“disable-raft-learner”: “false”,

“disable-remove-down-replica”: “false”,

“disable-replace-offline-replica”: “false”,

“disable-make-up-replica”: “false”,

“disable-remove-extra-replica”: “false”,

“disable-location-replacement”: “false”,

“disable-namespace-relocation”: “false”,

“schedulers-v2”: [

{

“type”: “balance-region”,

“args”: null,

“disable”: false

},

{

“type”: “balance-leader”,

“args”: null,

“disable”: false

},

{

“type”: “hot-region”,

“args”: null,

“disable”: false

},

{

“type”: “label”,

“args”: null,

“disable”: false

},

{

“type”: “evict-leader”,

“args”: [

“31906230”

],

“disable”: false

}

集群的配置什么样,有什么特殊的大流量操作吗?