你好

ok,开启之后看来还没合并

-

可能还没有达到合并阈值,需要调小

-

还有可能之前做过 drop 或者 truncate table 操作,导致有很多空表,目前默认情况,空表的region 是不自动合并的需要增加以下两个参数。(你可以先调整这两个参数,看效果不行就调小 region size 的阈值)

-

PD 参数 namespace-classifier = “default”

-

TiKV 参数 split-region-on-table: false

可以在中控节点修改 pd.yml 然后执行 ansible-playbook rolling_update.yml --tags=pd 来使修改生效或者 edit-config 之后通过 tiup cluster cluster-name reload -R pd。

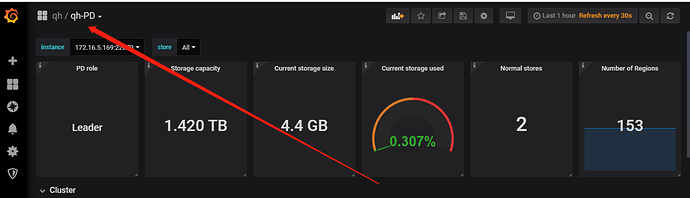

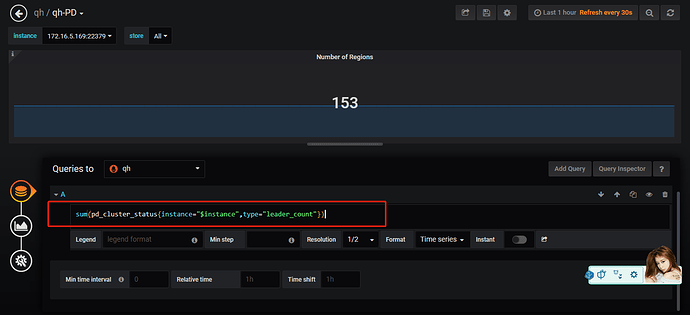

麻烦反馈下一下信息和展示信息

将下图信息展示下: