为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【 TiDB 使用环境】

【TiDB 版本】:tikv3.0.1,无tidb

【TiDB Operator 版本】:1.1.12

【K8s 版本】:1.21.X

【概述】 场景 + 问题概述

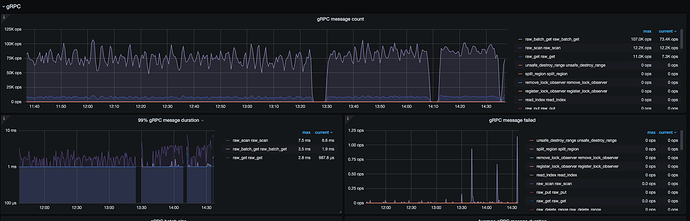

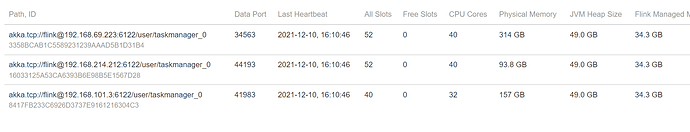

需要提高读写性能,目前测试使用flink集群资源进行测试,开2台flink机器和5台读写速度差不多,麻烦看一下tikv的监控,看一下是不是tikv的问题

【附件】 相关日志及配置信息

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

4 个赞

Hello~ 从 TiKV-details 的监控看是应该存在查询的热点问题,可以先参考一下 TiDB 热点问题处理 的文档,先排查一下是否存在热点请求。可以针对具体的 table 进行优化。

https://docs.pingcap.com/zh/tidb/stable/troubleshoot-hot-spot-issues#tidb-热点问题处理

3 个赞

xfworld

(魔幻之翼)

6

dashboard , 选择流量可视化,就能看到 热力图 了。

1 个赞

我观察了一下,我的测试job跑起来,这个面板的数据总会有一个最高,但不固定是这一个节点

1 个赞

xfworld

(魔幻之翼)

13

你直接是用的 rawAPI 么?这个我暂时帮不了你

tnxAPI 走 tidb 的,我可以帮你

还是请 lucien 帮你解答吧

xfworld

(魔幻之翼)

15

你可以看看,哪个热度比较高的节点写的什么数据?是否能均衡到其他的节点上

或者你输出日志看看…

如果能均衡,就不会出现热点问题了

提供一下加大并发的时间段,另外使用哪类 client 来处理的读写请求。

11:30-13:25的时候是34并发度

13:30:14:10是72并发度

14:10-14:35是144并发度

使用的是

org.tikv

tikv-client-java

3.1.2

从监控上面看,TiKV 的请求没有压上去,需要确认一下发压机的请求分发模式和配置情况。

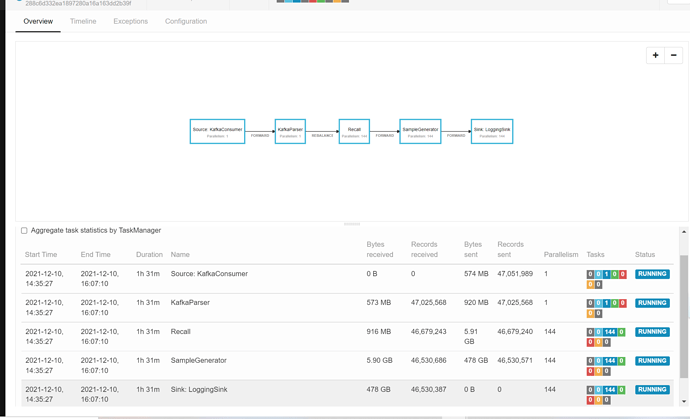

采用flink流数据执行程序,执行读数据流程大致如下

Kafka会模拟实时消费用户登陆信息,持续不断的生成数据,所以系统会一直运行。

Recall:此步骤会根据userid,scan一组该用户的click数据(raw-scan),筛选用户感兴趣的相似商品list<>itemid,用于下一步生成样本(这里理想化每次筛选10条itemid,且随机避免热点请求)

SampleGenerator:根据前面的userid(raw-get)和itemid列表(raw-batch-get),查询item,user表数据

如上图,基本上samplegenerator这部进行raw-get 和raw-batch-get的时候速度是最慢的,导致前面的步骤背压比较大

下面是配置