【 TiDB 使用环境】生产环境

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

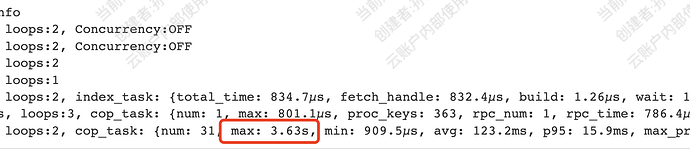

根据唯一键查询,执行计划时间较久,花费近3s,

执行计划中有Concurrency:OFF

id task estRows operator info actRows execution info memory disk

Projection_7 root 1.00 stat.table_abc.i_id, stat.table_abc.i_date, stat.table_abc.i_member_id, stat.table_abc.i_count, stat.table_abc.i_amount, stat.table_abc.ch_rank_list 1 time:2.78s, loops:2, Concurrency:OFF 3.43 KB N/A

└─TopN_10 root 1.00 stat.table_abc.i_id:desc, offset:0, count:1000 1 time:2.78s, loops:2 3.44 KB N/A

└─IndexLookUp_28 root 1.00 1 time:2.78s, loops:3, index_task: {total_time: 706.6ms, fetch_handle: 706.6ms, build: 1.02µs, wait: 2.21µs}, table_task: {total_time: 7.72s, num: 1, concurrency: 8} 11.3 KB N/A

├─IndexRangeScan_26 cop[tikv] 1.00 table:table_abc, index:UNIQ_I_MEMBER_ID(I_MEMBER_ID, I_DATE), range:[813604959883265,813604959883265], keep order:false 1 time:706.5ms, loops:3, cop_task: {num: 1, max: 706.4ms, proc_keys: 1, tot_proc: 1ms, rpc_num: 1, rpc_time: 706.4ms, copr_cache_hit_ratio: 0.00}, tikv_task:{time:1ms, loops:1}, scan_detail: {total_process_keys: 1, total_keys: 2, rocksdb: {delete_skipped_count: 0, key_skipped_count: 1, block: {cache_hit_count: 11, read_count: 0, read_byte: 0 Bytes}}} N/A N/A

└─TableRowIDScan_27 cop[tikv] 1.00 table:table_abc, keep order:false 1 time:2.07s, loops:2, cop_task: {num: 1, max: 2.03s, proc_keys: 1, rpc_num: 1, rpc_time: 2.03s, copr_cache_hit_ratio: 0.00}, tikv_task:{time:0s, loops:1}, scan_detail: {total_process_keys: 1, total_keys: 1, rocksdb: {delete_skipped_count: 0, key_skipped_count: 0, block: {cache_hit_count: 16, read_count: 0, read_byte: 0 Bytes}}} N/A N/A

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】