【常见错误】

【原因】

【解决方法】

2 个赞

【常见问题】

一、修改druid配置(如果使用druid的话)

PS.此方案对性能会有一定影响

二、修改数据库连接配置

TIKV server is busy,通常是由于tikv负载过高或网络负载打满导致的,可由监控确认后增大网络带宽或者扩容tikv节点解决

db_user

2023 年4 月 3 日 02:46

27

业务不多但负载很高,某些时候看会造成某名奇妙的慢sql

解决:

ffeenn

2023 年4 月 3 日 06:00

28

【常见问题】

LI-ldc

2023 年4 月 3 日 06:04

29

1、某sql查询时出现 other error for mpp stream 报错时,

2、dashboard报错:error.pd.client_request_failed: Request failed with status code 500 from PD API: “[PD:cluster:ErrNotBootstrapped]TiKV cluster not bootstrapped, please start TiKV first”#查看现使用的地址 http://192.168.10.51:2379 config set dashboard-address http://192.168.10.52:2379 #切换51到52 http://192.168.10.52:2379 config set dashboard-address http://192.168.10.51:2379 #切回

问题:

ERROR 8004 (HY000) at line 1: Transaction is too large, size: 100000058

原因:

在 TiDB 的早期版本中,LOAD DATA 语句每 20000 行进行一次提交。新版本的 TiDB 默认在一个事务中提交所有行。从 TiDB 4.0 及以前版本升级后,可能出现 ERROR 8004 (HY000) at line 1: Transaction is too large, size: 100000058 错误。

解决方法:tidb.toml 文件中的 txn-total-size-limit 值。如果无法增加此限制,还可以将 tidb_dml_batch_size20000 来恢复升级前的行为。

半瓶醋仙

2023 年4 月 3 日 08:03

32

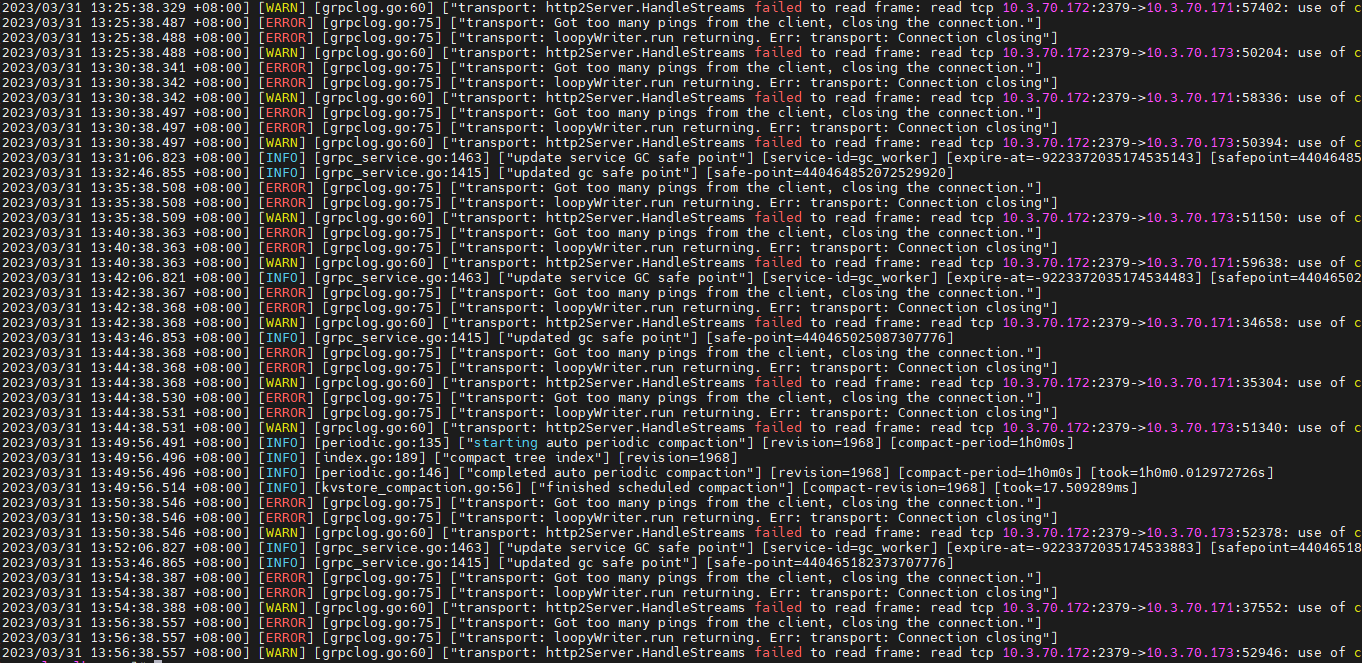

[常见错误]

常见问题:transport: Got too many pings from the client, closing the connection.

解决办法:

1.问题:利用可视化工具复制其他数据库的数据到tidb,报错事务太大同步失败

考试没答案

2023 年4 月 6 日 01:12

36

[常见问题]

Jiawei

2023 年4 月 6 日 03:11

38

我觉得还是热点问题应该是最常见的,最容易犯的。

还有一个锁的问题,尽量业务设计的时候避免频繁竞争锁,等待锁的相关问题。

Jiawei

2023 年4 月 6 日 03:18

39

对了 还有就是oom问题。

【常见错误】