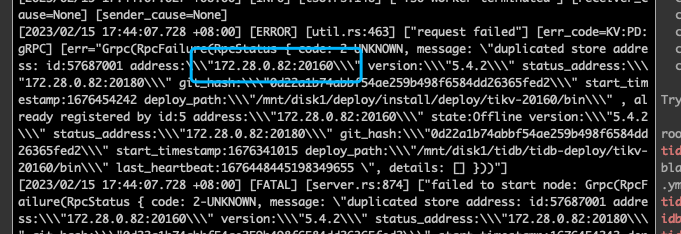

强制下线一个节点后,导致tidb 启动失败,日志中还是不断的去连下线的节点,如何修复

tidb 启动失败的日志

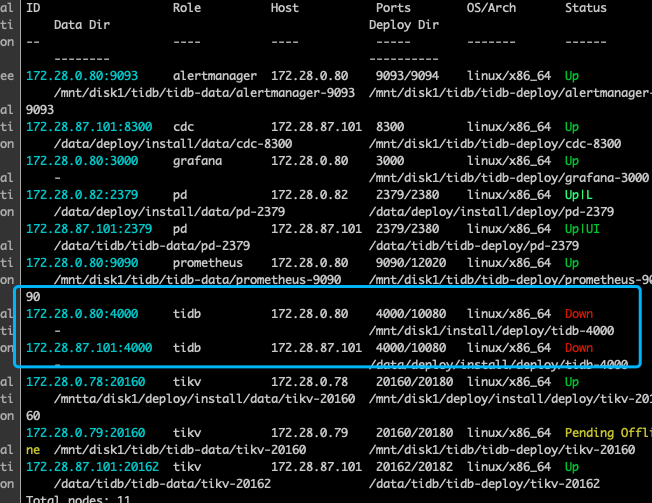

集群现在什么状态?

可能要等一段时间,估计还没结束下线。因为是异步的。

tidb 节点不应该是down啊,看下tidb节点的日志。你贴的日志不是一个fatal吧,不至于因为你那个日志退出吧。

我现在重新扩容之前下线的节点,提示我节点信息冲突,不让安装

在哪能把pd 中该部分元数据删除掉呐

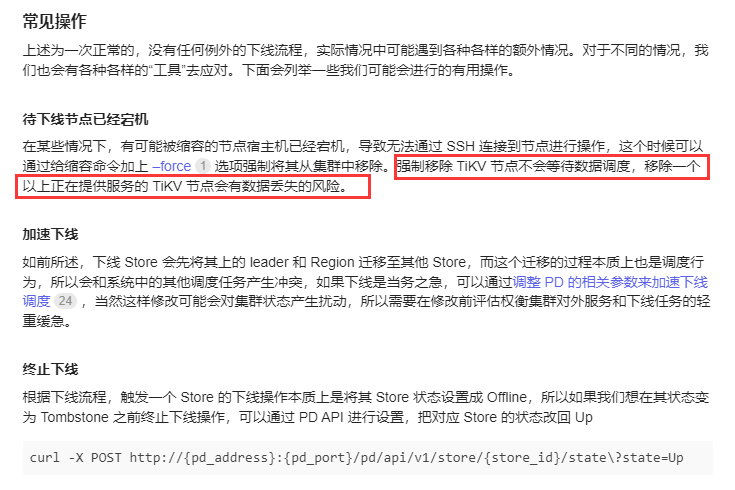

生产环境么?别这样操作。等到集群下线成功。

你只有3个tikv节点吗?那缩容不了啊,不是挂了吗?保证不了三副本了啊!

1 个赞

tikv 副本不能满足3个了啊

同节点执行了缩容后,扩容时候换个端口

一晚上过去了,下线结束了么?

tikv的多副本多数协议,强制挂掉一个,不会影响到任务服务,也就是说能提供正常服务。这个明显是操作有问题吧

tidb可以实现负载均衡的。自动故障切换吧。 并且是无状态的

您把您强制下线的命令发下。我强制下线我的测试集群看看。

找到下线节点的store id,然后用pd-ctl store cancel-delete

我有一个帖子,你可以去看看,找到下线节点的store id,一个tikv实例对应一个store_id 然后用pd-ctl store delete 删除掉这个store_id就可以

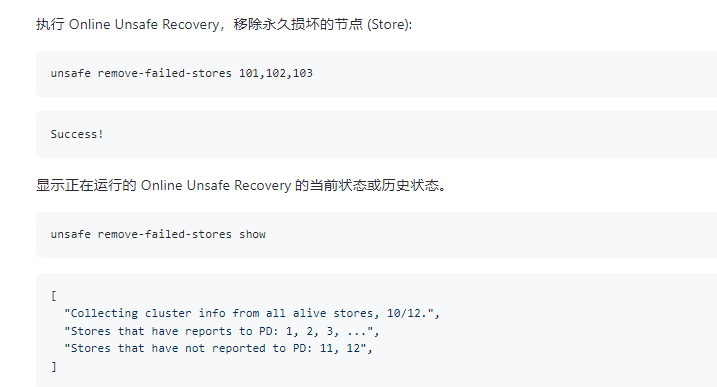

pd-ctl相关命令即可。如果确定这个tikv节点不要了。使用unsafe 命令删除。

https://docs.pingcap.com/zh/tidb/stable/pd-control#unsafe-remove-failed-stores-store-ids--show

delete 命令可能提示删除成功。但是就是删除不了的局面

1 个赞