【 TiDB 使用环境】生产环境

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

SELECT I_ID from 表名 FORCE index (IDX_SYNC_STATUS)

WHERE I_SYNC_STATUS = 0 LIMIT 1000;

【遇到的问题:问题现象及影响】

I_SYNC_STATUS = 0 的数据在表中不多,总共1000多条

上面表名数据量24亿,但是强制使用了索引,为什么依然查询很慢呢

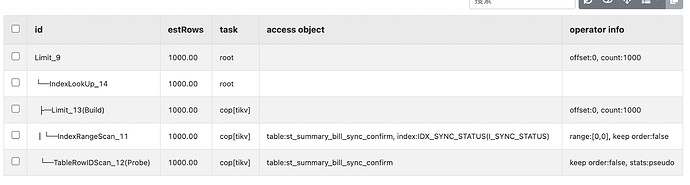

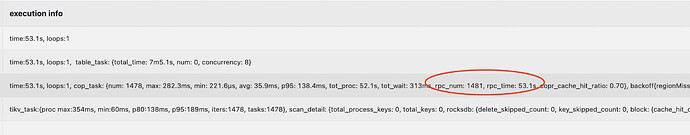

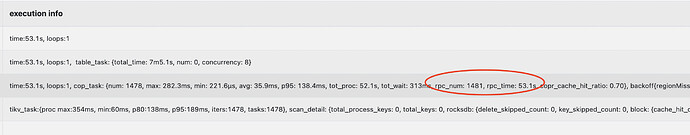

explain analyze sql

CREATE TABLE

st_summary_bill_sync_confirm (I_ID bigint(20) NOT NULL AUTO_INCREMENT COMMENT ‘自增ID’,I_SUMMARY_ID bigint(20) NOT NULL DEFAULT ‘0’ COMMENT ‘’,I_SUMMARY_TYPE int(11) NOT NULL DEFAULT ‘0’ COMMENT ‘’,I_SYNC_STATUS tinyint(4) NOT NULL DEFAULT ‘0’ COMMENT ‘同步状态,0为准备同步,1为正在同步,2为同步成功,3为同步失败,4为未处理的类型’,I_SYNC_STATUS_DETAIL int(11) NOT NULL DEFAULT ‘0’ COMMENT ‘状态信息详细说明’,I_RETRY_COUNT int(11) NOT NULL DEFAULT ‘0’ COMMENT ‘重试次数’,CH_COMMENT varchar(200) NOT NULL DEFAULT ‘’ COMMENT ‘同步涉及注释’,D_CREATED_AT datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT ‘创建时间’,D_UPDATED_AT datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT ‘’,PRIMARY KEY (

I_ID) /*T![clustered_index] CLUSTERED */,UNIQUE KEY

UNIQ_SUMMARY_ID (I_SUMMARY_ID),KEY

IDX_SYNC_STATUS (I_SYNC_STATUS)) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin AUTO_INCREMENT=2588993678 COMMENT=‘’

【资源配置】

【附件:截图/日志/监控】