【 TiDB 使用环境】Poc

【 TiDB 版本】6.1.2

【遇到的问题】我在global里配置的resource_control覆盖了所有在server_configs里的各个服务级别的resource_control,不是应该反过来吗?

【资源配置】

global:

user: hadoop

group: hadoop

ssh_port: 22

ssh_type: builtin

deploy_dir: /home/hadoop/apps/em-deploy

data_dir: /home/hadoop/apps/tidb-data

resource_control:

memory_limit: 112G

os: linux

arch: amd64

monitored:

node_exporter_port: 9100

blackbox_exporter_port: 9115

deploy_dir: /home/hadoop/apps/em-deploy/monitor-9100

data_dir: /home/hadoop/apps/tidb-data/monitor-9100

log_dir: /home/hadoop/apps/em-deploy/monitor-9100/log

server_configs:

tidb:

log.level: info

oom-use-tmp-storage: true

performance:

memory-usage-alarm-ratio: 0.8

txn-total-size-limit: 10737418240

resource_control:

memory_limit: 112G

tmp-storage-path: /home/hadoop/apps/tidb-data/tidb-temp

tmp-storage-quota: 26843545600

pd:

log.level: info

replication.enable-placement-rules: true

resource_control:

memory_limit: 12G

schedule.leader-schedule-limit: 4

schedule.region-schedule-limit: 2048

schedule.replica-schedule-limit: 64

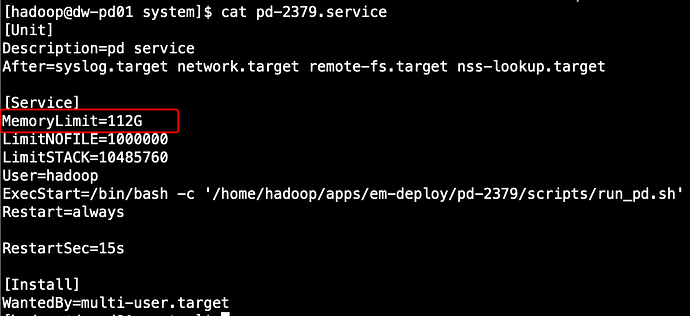

【pd的systemd配置】

【tidb文档截图】