【 TiDB 使用环境】

测试

【 TiDB 版本】

v6.4.0

【复现路径】

【遇到的问题:问题现象及影响】

经测试,发现TiDB支持日志备份的版本v6.4.0目前存在以下一些问题:

- 集群日志备份到本地失败,只生成了备份目录但没有产生备份文件,单节点备份到本地正常。

- 六节点集群,3 PD 6 TiKV 6TiDB,停掉一个TiKV节点,日志备份gap会有一定增长(五分钟左右),但在十分.

钟内能够被追平,且追平后不会再出现gap明显增长的情况,全量+增量恢复正常。

- 六节点集群,3 PD 6 TiKV 6TiDB,停掉两个TiKV节点,日志备份的gap一直累积,一直到两个半小时左右.

都未能够追平(初步判断为无法追平)。

- 日志备份正常期间,外部存储ceph节点关机,日志备份无报错,但gap一直累积,备份文件正常输出到本地.

缓存。ceph节点开机后,gap可以追平。(ceph关机十分钟)

【资源配置】

6台云主机,配置 2C4G Disk 50G

【附件:截图/日志/监控】

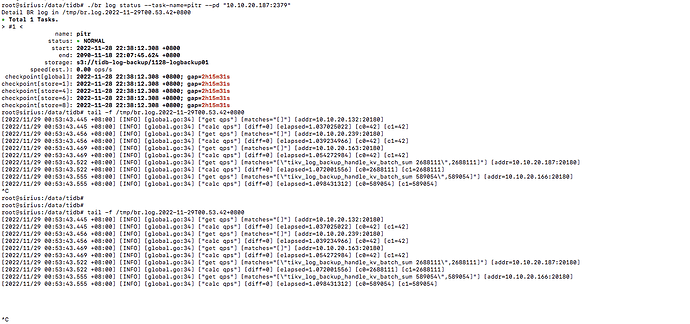

环境已经铲掉了,只有问题点3的终端能截图到日志备份任务的信息:

部署是直接从官网下载二进制包部署的,配置都是默认的没有改动。关掉的机器上面分别跑了pd+tikv+tidb 和tidb+tikv。

我就是想表达,v6.4.0的pitr功能是不是还不稳定?需要等待后续稳定版本出来再看是否能够修复这些问题?

我被你问得也差点想不起来我的核心问题是啥了要

xfworld

(魔幻之翼)

13

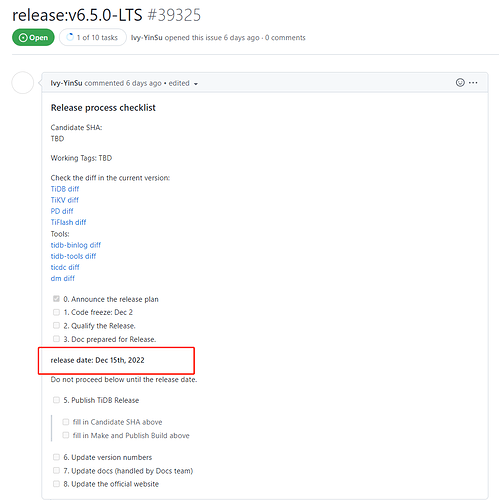

6.4 不是 LTS,是 DMR

如果想上生产的话,目前推荐 6.1 LTS

然后 POC 也建议这个版本。但是你想体验特性的话,6.4 可以,要上生产要在等等

我猜测,你想实验 同步备份和恢复的过程,本身tikv 多副本是支持调度的,可以实现副本的均衡,只要节点足够

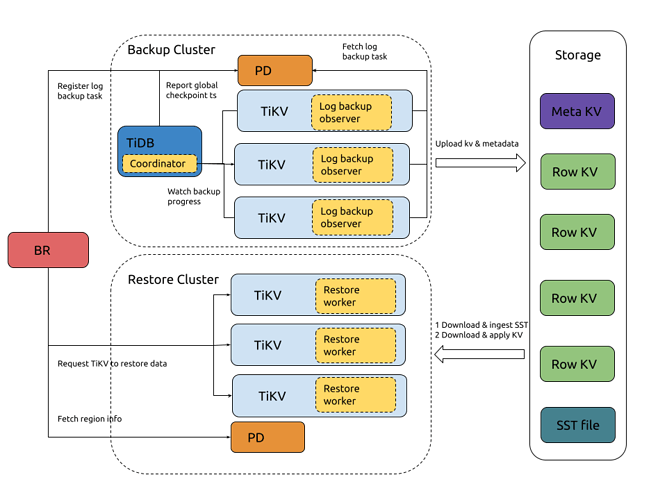

图例中描述的是 备份和恢复的过程了,你可以参考文档在模拟一下

嗯啦,准确来讲是实验全量备份+日志备份来实现PITR。

早知道我一上来就问我的核心问题了

PITR上生产大概要等多久呀?我看v6.4.0是这个月17号才出来。。。

xfworld

(魔幻之翼)

16

等到下一个 LTS 咯

这个时间很有可能会后延,发布版本的话,还是要看一些问题是否都修复了…

那我上面提的问题你可以转一下么?也可以修复一下,哈哈~

延后应该不会到明年吧?

哦解释说明一下,我测试的时候是单库单表的数据读写哈。

裤衩儿飞上天

19

等PITR GA吧,好像是还没有GA,现在问题也比较多

xfworld

(魔幻之翼)

20

这个有两种模式: 快照和日志回放,我建议你在测试一下

单库单表不是问题点咯~

关键是这个过程,是否能满足你的预期