-

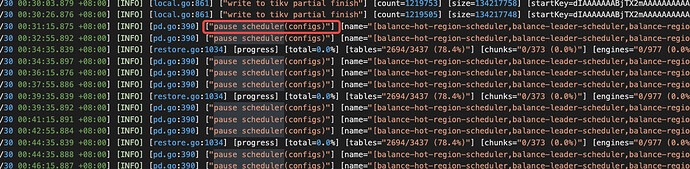

这个 pause 操作一直在重复,目前不清楚原因,启动 lightning 后有手动改过 scheduler 或开启 scheduler 吗?

-

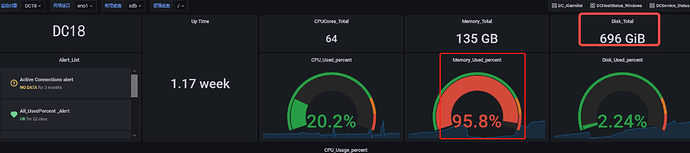

哦哦,那得解决下 oom 的问题

-

是不要将lightning和dumpling的不能放在同一个目录

→ 不需要,dumpling 和 lightning 不是同时操作的吧?只要不是同时操作 就不会争抢 io 资源,不过最好都是 ssd。但现在的主要问题应该是,数据写到 tikv 后 oom 撑不住。可以分析下 tikv memory 除了 blockcache 外,还有哪些内存消耗,看下 tikv-details 面板(是因为 io 把 tikv 打满数据都 hold 在内存里吗?等等原因) -

不建议拆了吧,也导入进去了 600GB 的数据了?还是几乎没导入进去啊🤔?拆分不同目录没有意义。

我觉得当前问题:

- 搞清 memory 消耗根本原因,不让 tikv oom,持续有数据导入(即使慢点);

- 想办法解决 tikv io 打满的问题,如果不能换盘,想办法调低并发;

- 如果已经导入一部分数据了,lighting 有 checkpoint 机制支持断点续传,尽量重用吧。节省时间,就不要动了,先解决 tikv 侧的问题。