【 TiDB 使用环境】生产环境

【 TiDB 版本】5.4.0

【遇到的问题】TiKV approximate region size is more than 1GB持续告警

【复现路径】暂未

【问题现象及影响】

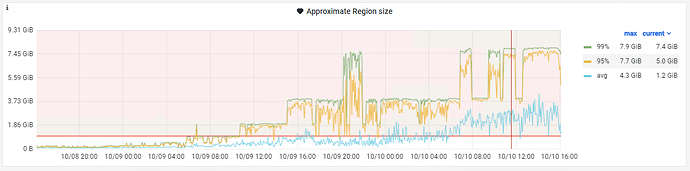

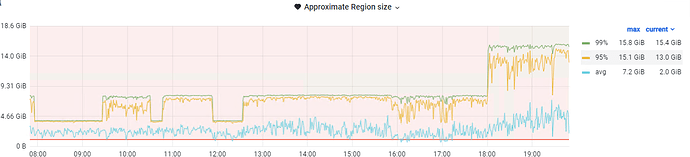

现象:持续告警,grafana上看到的 【approximate region size】面板数据持续上涨

影响:暂无

集群用途:【Juicefs的元数据服务】

目前这个告警一直持续了1天多,region size增长特别快,当前集群主要是TIKV组件,部署了一个TIDB用于GC,目前GC正常工作

集群除了这个告警,暂无其他异常

【附件】

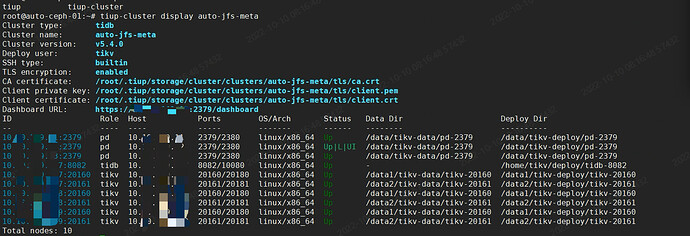

Tiup cluster Display信息:

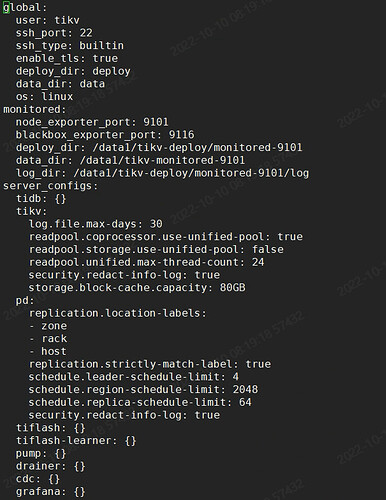

Tiup Cluster Edit Config信息:

【approximate region size】面板监控:

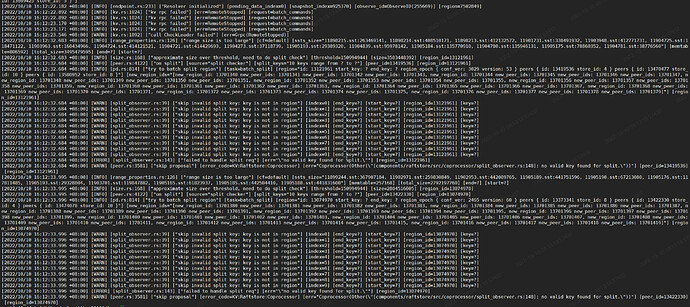

tikv部分日志:

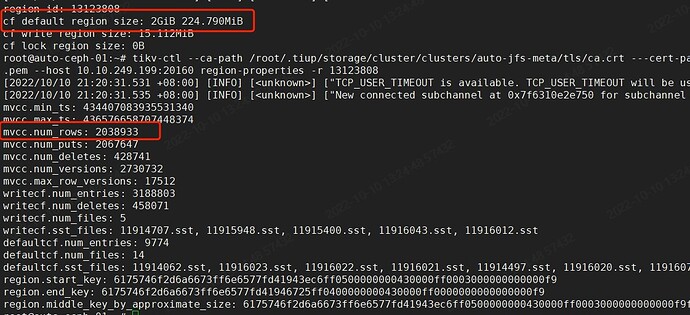

其中一个region信息:

CF default 非常大,并且mvcc num_rows特别多

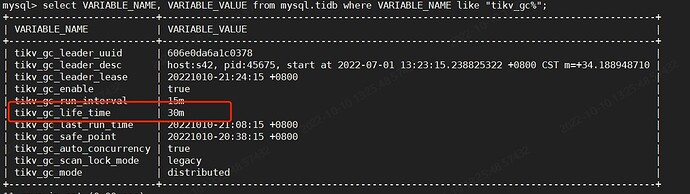

GC配置如下:

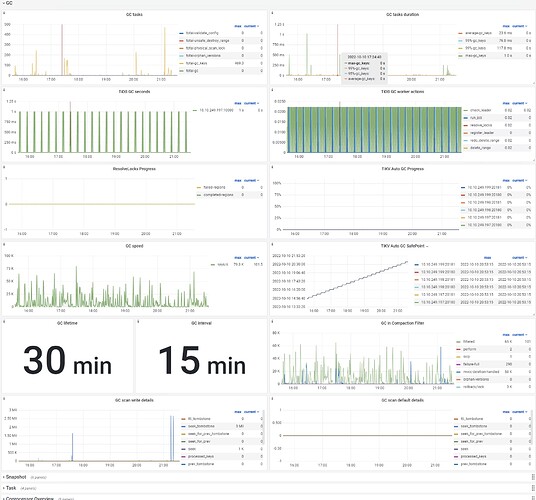

TIKV GC面板

请提供各个组件的 version 信息,如 cdc/tikv,可通过执行 cdc version/tikv-server --version 获取。