【 TiDB 使用环境】生产环境 /测试

【 TiDB 版本】v5.1.0

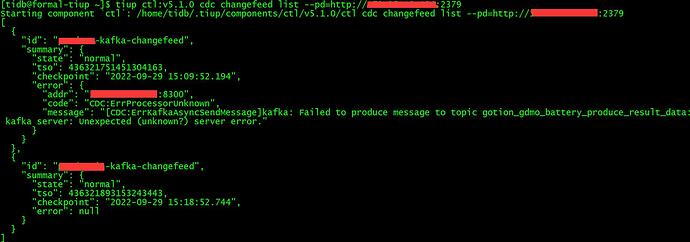

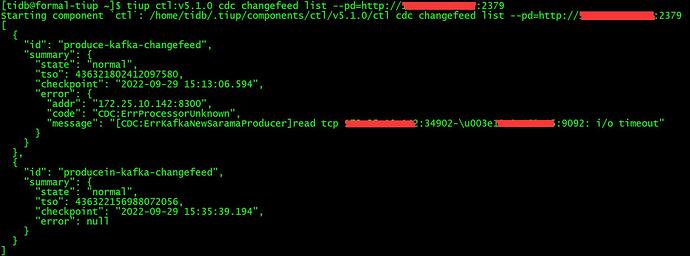

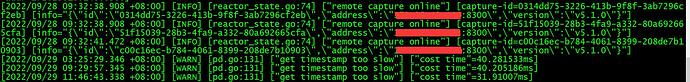

【遇到的问题】1、Ticdc同步到kafka数据报如下错误(图一),但是kafka是可以接受到数据的(同样创建的二个任务,一个正常,一个有异常),但是运行一段时间后报错信息如图二

图一:

图二:

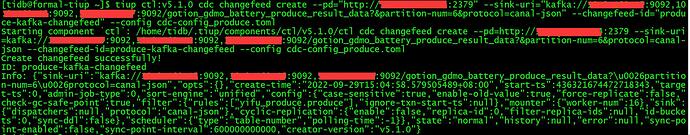

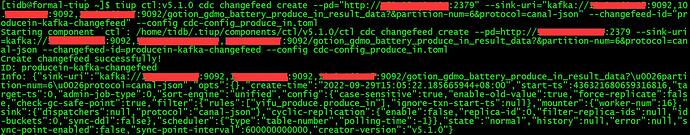

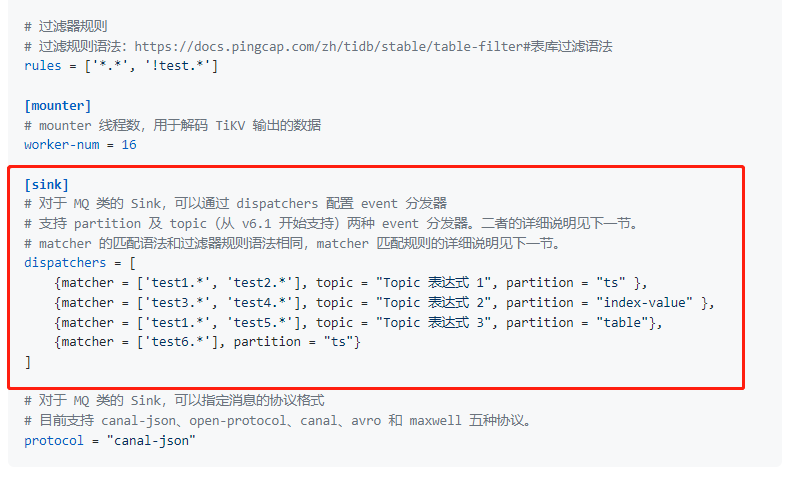

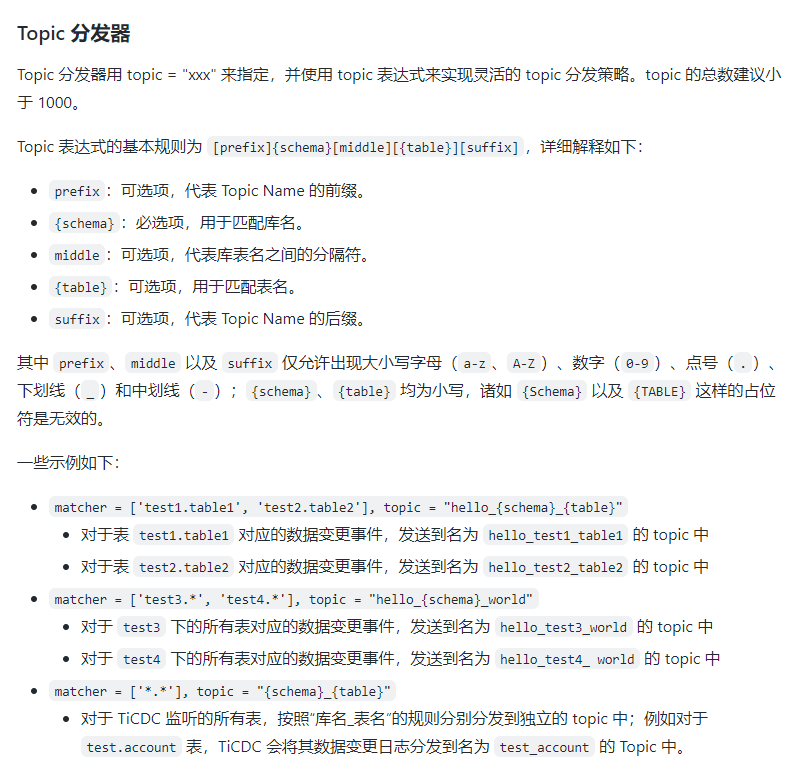

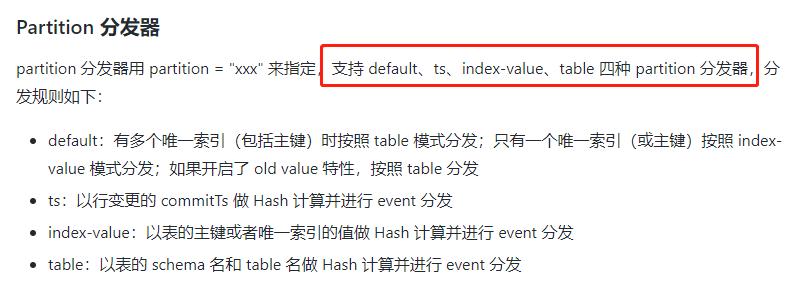

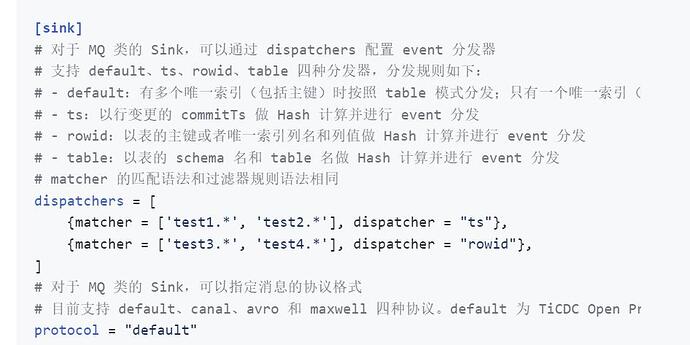

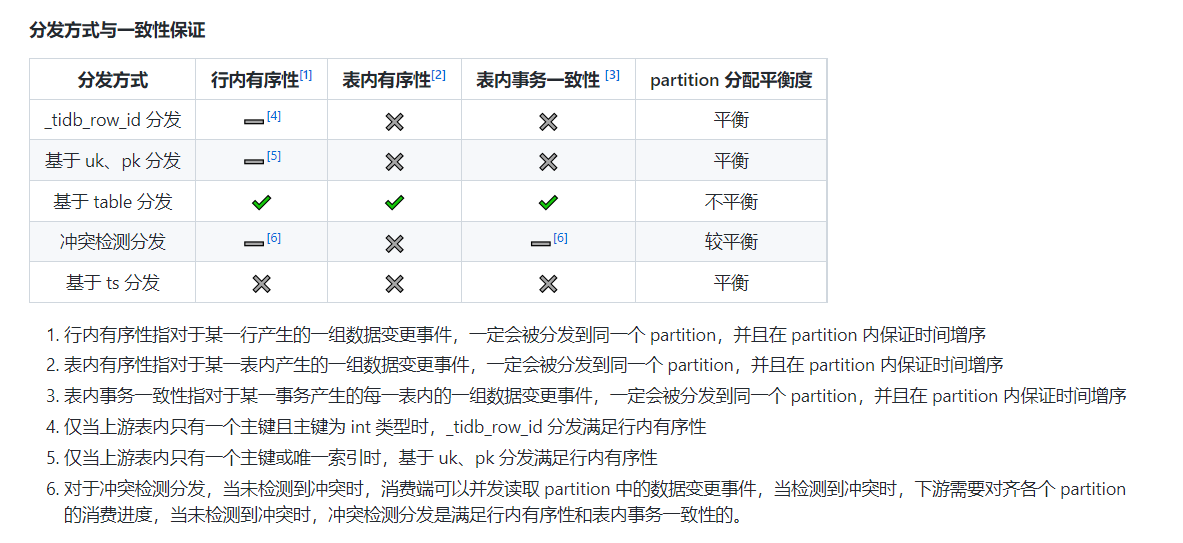

2、创建的同步任务同步到6个分区,结果kafka端接收的数据只进一个分区,不知是不是命令有问题?还是配置文件需要加worker-num = 16

tiup ctl:v5.1.0 cdc changefeed create --pd=“http://x.x.x.x:2379” --sink-uri=“kafka://y.y.y.y:9092,y.y.y.y:9092,y.y.y.y:9092/gotion_gdmo_battery_produce_result_data?&partition-num=6&protocol=canal-json” --changefeed-id=“produce-kafka-changefeed” --config cdc-config_produce.toml

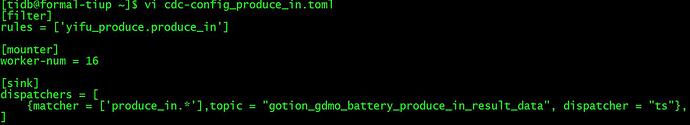

tiup ctl:v5.1.0 cdc changefeed create --pd=“http://x.x.x.x:2379” --sink-uri=“kafka://y.y.y.y:9092,y.y.y.y:9092,y.y.y.y:9092/gotion_gdmo_battery_produce_in_result_data?&partition-num=6&protocol=canal-json” --changefeed-id=“producein-kafka-changefeed” --config cdc-config_produce_in.toml

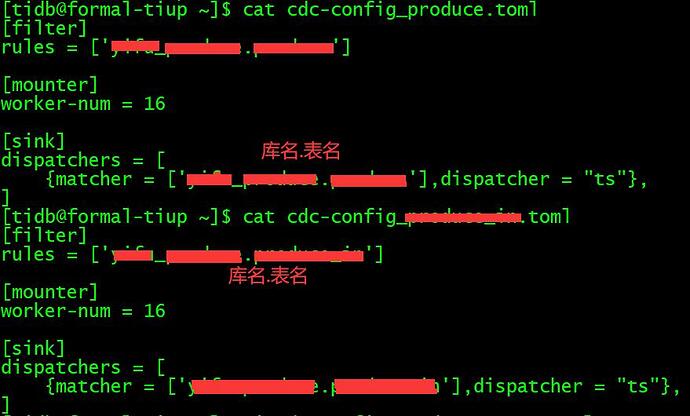

配置文件:

[tidb@formal-tiup ~]$ cat cdc-config_produce.toml

[filter]

rules = [‘xx.produ…’]

日志: