通过执行命令

tiup ctl:v5.3.0 pd -u host:port store | grep “id"” 查看所有 store 可以看到以下信息

"id": 1,

"id": 4,

"id": 256612,

"id": 527844,

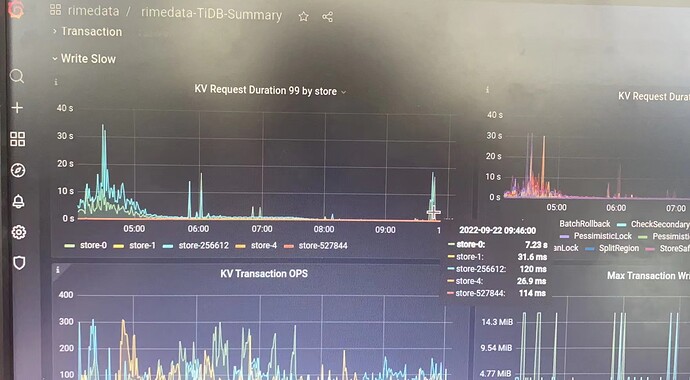

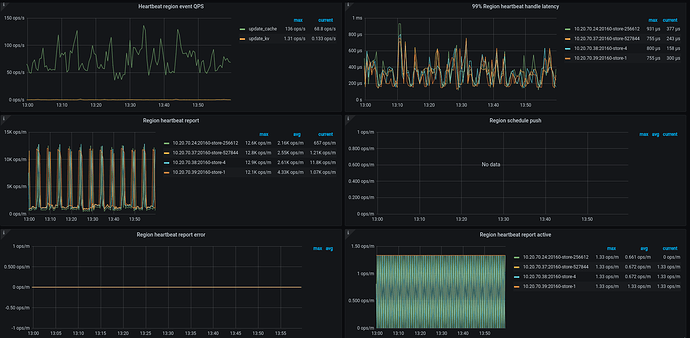

也就是 tidb 集群当前只有 4 个 store ,分别是 id 1、4、256612、527844 ,但是通过 grafana 却发现多了一个 store-0, store-0 应该是之前已经下线机器上的,但却没有被清除

想问一下怎么清除这个 store-0

1 个赞

Meditator

(Wendywong020)

2

tiup ctl:v5.3.0 pd -u host:port store 0 看看 id=0的store状态

Failed to get store: [404] "store 0 not found",显示 not found ,但不知道为什么 grafana 中还有 store-0 的信息

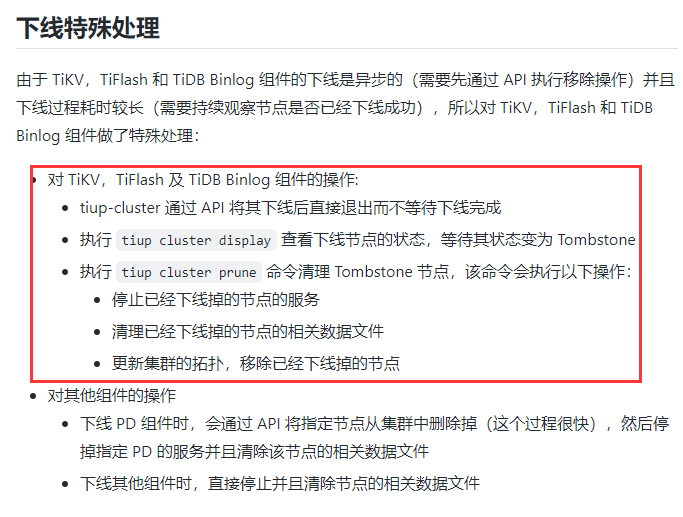

那个节点已经下线掉了,我记得之前是有执行 prune 命令的,之前是因为机器的问题,用了 --force 命令,强制下线的

Kongdom

(Kongdom)

6

grafana可能是缓存,如果是在查询时间区间内缩容的,显示是正常的。如果是在查询时间区间外缩容的,显示是不正常的,可以尝试重启一下组件看看有没有效果

Kongdom

(Kongdom)

8

哦哦,那就是–force后,还要手工在删除那个store

就是 store-0 所在的那个机器,下线了估计两三个月了,文中的 grafana 数据是今天的,那就是说我重启一下 grafana 组件再看看是吗

那我去官网找找手动删除某个 store 的命令试试看

Kongdom

(Kongdom)

11

tiup cluster display里是已经没有store-0对应的节点了么?如果已经没有了,那就重启一下grafana组件试试

是的,没有了。

但是有个背景需要说明一下就是: 之前 store-0 所在的机器被缩容掉,后面重装系统后又被扩容进来了。

我之前确实是执行过这个命令的,所以理论上来说 store-0 应该是确实被删除了,执行 tiup ctl:v5.3.0 pd -u http://10.20.70.39:12379 store 也确实找不到 store-0 的信息

重启 grafana 组件后,依然能在 grafana 中的TiDB-Summary KV Request 99 By store 中看到 store-0 的信息

Kongdom

(Kongdom)

17

这种情况我遇到过,强制缩容,然后又扩容,出现过信息混乱的情况,后来我又正常缩容扩容做了一遍才好的。

这种情况我遇到过,强制缩容,然后又扩容,出现过信息混乱的情况,后来我又正常缩容扩容做了一遍才好的。

但是这时候那个被强制缩容的节点已经不在了,我已经没办法对 store-0 所在的节点缩容了。