Johnpan

(Johnpan)

1

TiDB版本5.4.0,TiCDC版本5.4.0

目前用TiCDC任务同步TiDB数据到下游MySQL实例的时候,延迟很大,增量数据一天也就1G,但是任务已经延迟11小时,为什么呢?怎么优化呢?

另外,下游MySQL实例产生的binlog的速度很快,基本上一分钟1G的日志,有啥优化吗?

【 TiDB 使用环境】生产\测试环境\ POC

【 TiDB 版本】

【遇到的问题】

【复现路径】做过哪些操作出现的问题

【问题现象及影响】

【附件】

- 相关日志、配置文件、Grafana 监控(https://metricstool.pingcap.com/)

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

- TiDB-Overview 监控

- 对应模块的 Grafana 监控(如有 BR、TiDB-binlog、TiCDC 等)

- 对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

Meditator

(Wendywong020)

2

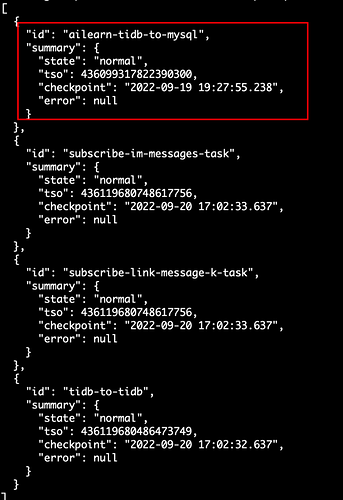

1)你这个几个task的sink都是同一个mysql实例吗?还是说sink不同?

2)ailearn-tidb-to-mysql这个task的下游mysql 每分钟产生1G的日志?每分钟能产生1G的日志,这个写量已经很大了。

3)对应changefeed的日志能发下吗?

4)每分钟产生1G的binlog日志,可以查看先binlog,到底都是写的什么数据?

5)下游mysql是什么架构?怀疑是双主,然后binlog中有第三方的server_id event

Meditator

(Wendywong020)

4

1)上游tidb每天的数据量只有1G,但是下游mysql的binlog 每分钟能产生1G的binlog日志,可以分析下这些binlog日志是否复合预期?

2)看下官方文档,查看下changefeed对应的processor是哪个,然后查看对应的capture(cdc-server)的日志,参考这里:https://docs.pingcap.com/zh/tidb/stable/manage-ticdc

3)理论不可能出现这么诡异的问题,除非这个changefeed出问题了,可否贴下这个changefeed的配置看看。

Johnpan

(Johnpan)

5

sorry,有部分同步是全量数据,所以binlog量大