Bug 反馈

清晰准确地描述您发现的问题,提供任何可能复现问题的步骤有助于研发同学及时处理问题

【 Bug 的影响】

TiDB Lightning V5.0.3

无法导入大的csv文件(2亿行数据左右)

【可能的问题复现步骤】

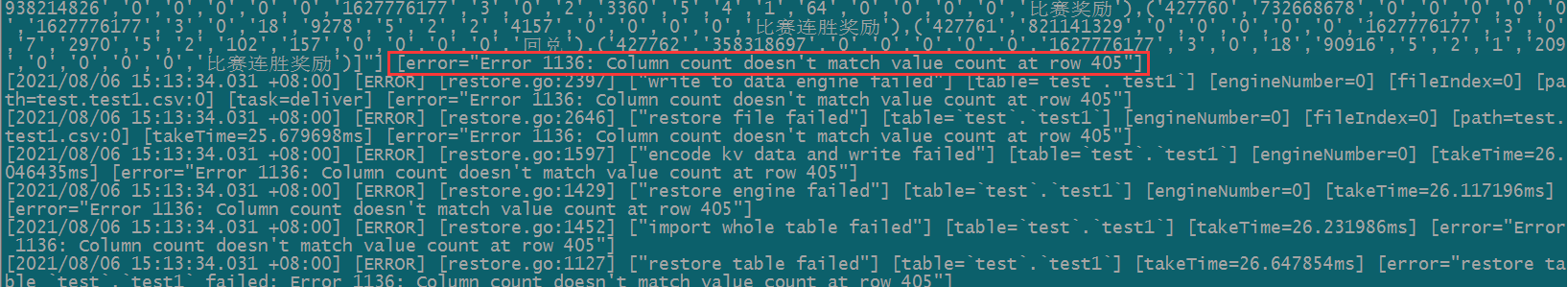

在使用TiDB Lightning导入csv文件,cvs文件比较大的情况下,导入数据过程中会出现类型如下的报错:

[2021/08/05 18:19:57.277 +08:00] [ERROR] [main.go:91] [“tidb lightning encountered error”] [error=“restore table test.test1 failed: Error 1136:

Column count doesn’t match value count at row 489”]

把报错信息行489的行数据提取出来没法先有啥问题

把报错行的前后50行数据(包括报错行)导入到一个小的csv文件中,然后重新导入小文件,可以成功导入;

【看到的非预期行为】

1、大文件导入过程中报错

2、拆分成小文件后可以导入成功

【期望看到的行为】

【相关组件及具体版本】

【其他背景信息或者截图】

如集群拓扑,系统和内核版本,应用 app 信息等;如果问题跟 SQL 有关,请提供 SQL 语句和相关表的 Schema 信息;如果节点日志存在关键报错,请提供相关节点的日志内容或文件;如果一些业务敏感信息不便提供,请留下联系方式,我们与您私下沟通。