LKLK

(Lklk)

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【背景】做过哪些操作

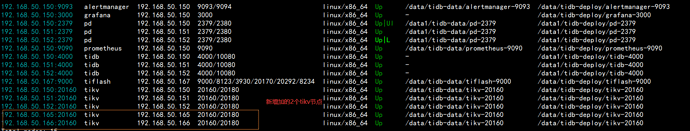

线上新增2个tikv 节点,机器配置跟原先3个tikv节点一样,参数也一样 ,扩容期间新2个TIKV节点就一直很高,以为数据在均衡,等数据已均衡, IO 使用率还是一直非常高!请问如何需要优化?

【现象】业务和数据库现象

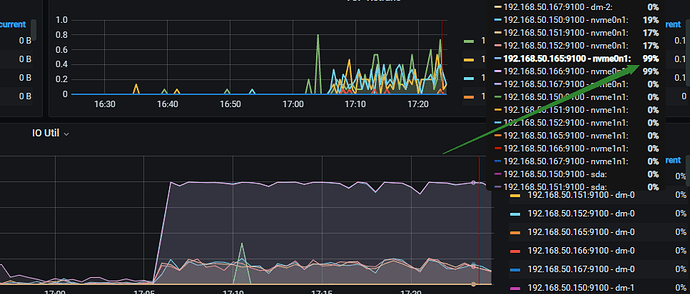

tikv 新增节点(数据已均衡) IO 使用率99%还是一直非常高!

【业务影响】

tikv 新增节点(数据已均衡) IO 使用率还是一直非常高!

【TiDB 版本】

v5.1.1

【附件】

- TiUP Cluster Display 信息

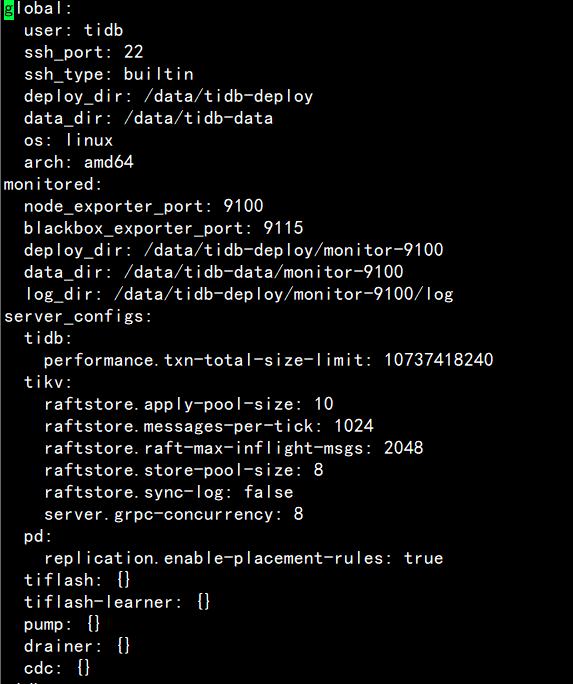

- TiUP Cluster Edit Config 信息

- TiDB- Overview 监控

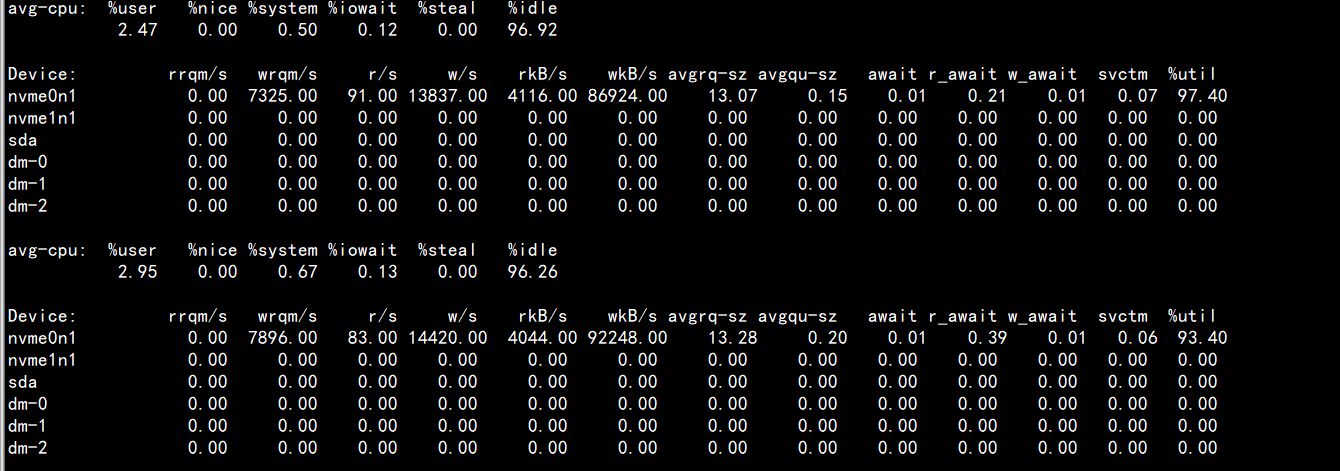

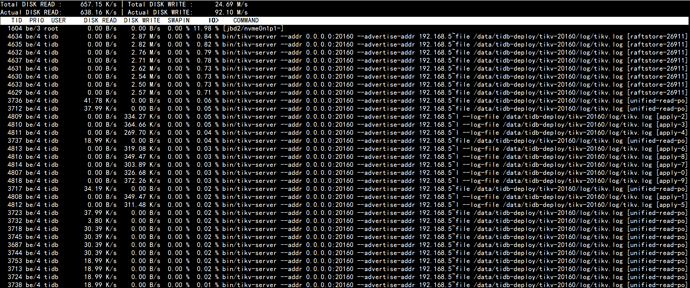

iostat %util 90%多,但iotop 显示才10%多,到底哪个准?

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

2 个赞

Lucien

( Lucien)

2

是在监控看到 I/O 使用率一直都是 98% 左右吗? 以系统 stats 查询结果为准。

1 个赞

LKLK

(Lklk)

4

是的,命令是要iostat -x 1 查看到的,请问从哪些方面排查?

Lucien

( Lucien)

10

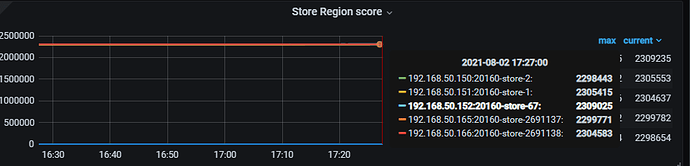

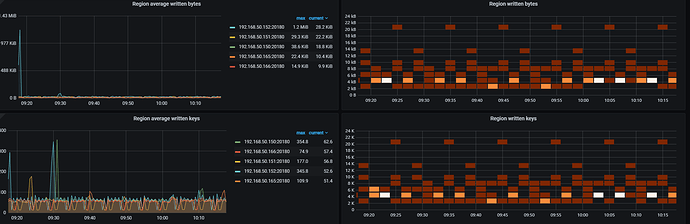

两方面, iostat -x 1 抓取的当前的,grafana 监控展示的是以 1 分钟粒度抓取的数据。所以 iostat -x 应该会比 grafana 精确,如果没有哦明显的性能瓶颈,可以按照 xfworld 同学的提示看一下是否存在热点问题。也有一种情况是新扩容的 TiKV在 balance region ,所以有大量的写入请求。这个可以看一下 tikv- details 监控里面的 server 监控部分,有 write bytes 监控。

LKLK

(Lklk)

11

谢谢解答。

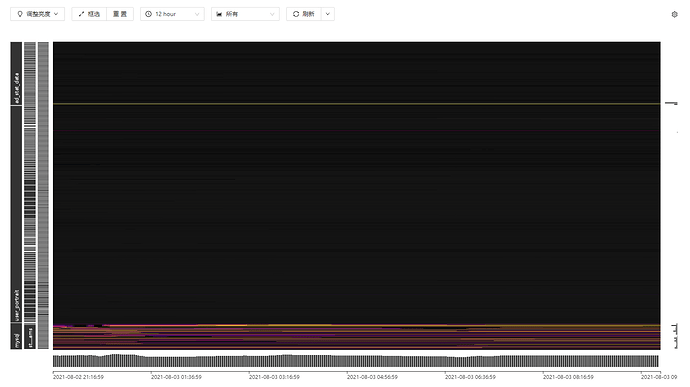

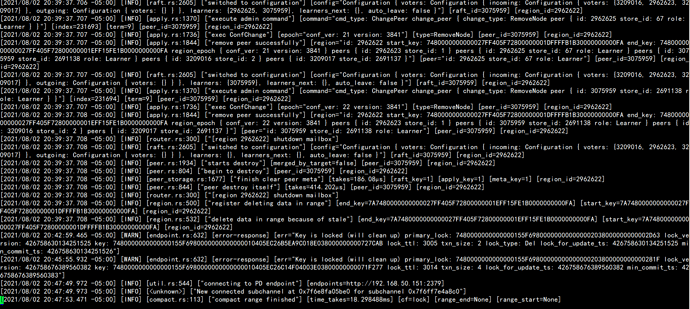

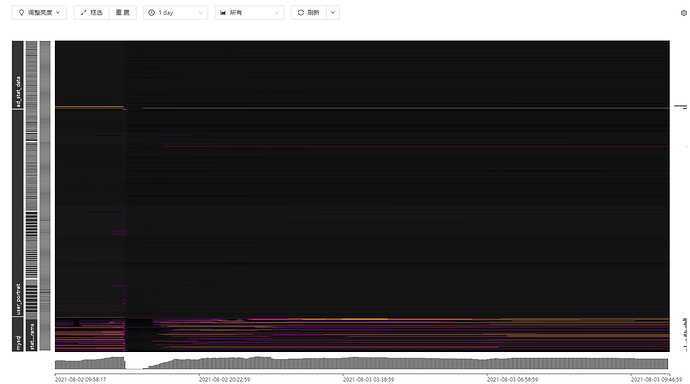

热点问题:我有截取1天的图,断掉部分在维护

tikv- details 监控里面的 server 监控部分,有 write bytes 监控。

Lucien

( Lucien)

12

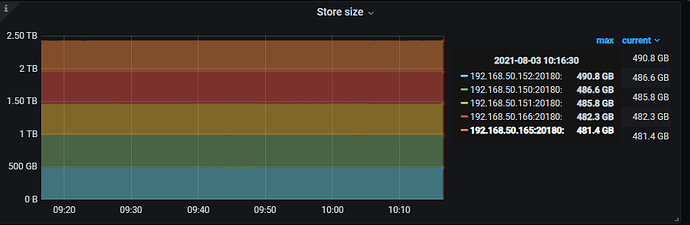

可以先用 metrictools 导出一下 tikv-details 、对应的扩容节点的 disk performance 监控,一起分析一下。

LKLK

(Lklk)

13

Lucien

( Lucien)

15

现在线上影响是什么 ?除了告警 ?其他的业务影响是怎么样的?

LKLK

(Lklk)

16

现在业务不受影响,但是新增2个节点io 使用率一直很高,就想知道如何解决?

LKLK

(Lklk)

18

Lucien

( Lucien)

19

监控数据还不完善,定位不了问题哈。看看能不能先自己排查一下,可以参考做一下排查。TiDB 写入慢流程排查系列(四)— TiKV Server 写入流程

LKLK

(Lklk)

20

查了半天,是我们新机器购买的intel磁盘io 应该有问题,跟tidb 配置和参数没关系