xxxxxxxx

(Hacker Z Vu Xy Nh8)

1

背景:有个mysql集群需要迁移到tidb,现在使用dm工具将mysql 5.7全量+增量同步到Tidb 4.0.13。

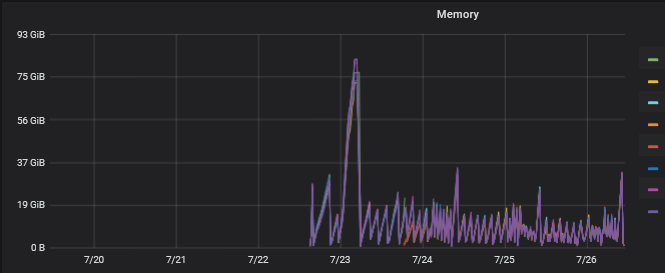

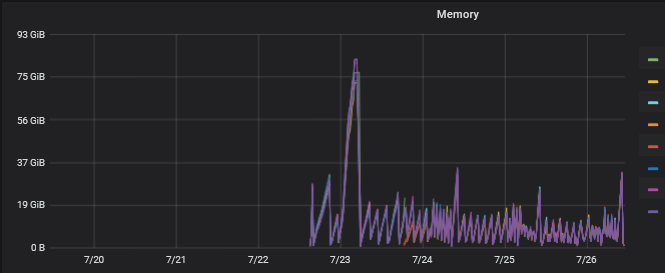

问题:遇到Tikv节点内存暴增问题,最高能飙到80G+,具体见下图。

处理方式,我现在的处理方式就是每两小时重启一下tikv节点

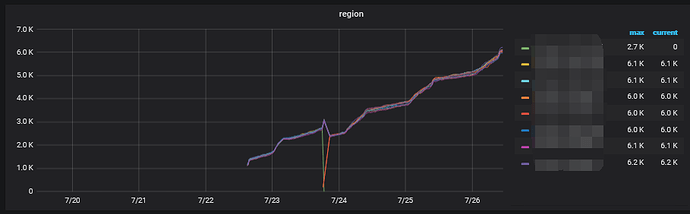

region 分布也比较均衡

关于安装:添加了如下配置,其余配置都是使用默认配置进行安装。

server_configs:

tidb:

mem-quota-query: 10737418240

tikv:

mem-quota-query: 10737418240

pd: {}

tiflash: {}

tiflash-learner: {}

pump: {}

drainer: {}

cdc: {}

关于大页:所有tidb,pd节点都启用大页,部分tikv节点启用大页,部分tikv节点关闭大页。

疑惑一:这个现象是否与启用大页有关,如果有,那关闭大页的tikv节点为啥也会内存飙升。

疑惑二:因为现在我们的环境都是机器混部,这套集群所在的机器也部署了其他tidb集群。如果需要将所有节点都关闭大页,是否对原有集群有问题,该集群是可以重启,但是其他集群不能重启,所以比较关注这个问题。

1 个赞

有关系,建议关掉内存大页设置

混合部署对资源争抢比较严重,建议做一定的调整,关掉内存大页设置。另外单个 TiKV 内存比较高,有可能存在写入热点情况,就是全量导入 schema 数据中确认一下是否使用自增主键的表。

xxxxxxxx

(Hacker Z Vu Xy Nh8)

3

现在的问题是,部分没用启用大页的tikv节点的内存也飙高,就是说整个集群所有tikv节点的内存都飙高,所以是不是还有什么其他原因导致内存彪高呢,还有就是热点问题,从监控来看是没有的

如果内存都在飙高,还有一种情况,是因为 TiKV 的 cache size 设置 buffer 默认很高。导致存储的内存持续增长,可以参考一下 TiKV 内存调优的文档了解一下。

https://docs.pingcap.com/zh/tidb/stable/tune-tikv-memory-performance

好的,如果你的问题已经解决了,可以再解决问题的帖子上面标记一下“对我有用”

system

(system)

关闭

8

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。