版本 v5.1.0

遇到了 tikv region 分布不均的问题,三个 tikv 的机器配置是相同的,监控信息如下:

可以看到 leader 和 region 大部分都分布在 172.26.55.92 节点上。

根据官方排查文档,先查询了各节点的 store 打分:

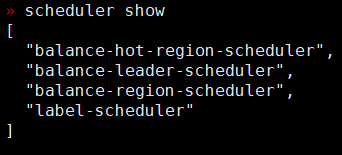

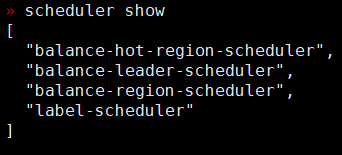

三个 store 的打分看起来差的不多。另外 scheduler 的信息如下:

到这里,不知道接下来应该朝哪个方向排查优化了,麻烦大佬给点思路,谢谢!

版本 v5.1.0

遇到了 tikv region 分布不均的问题,三个 tikv 的机器配置是相同的,监控信息如下:

可以看到 leader 和 region 大部分都分布在 172.26.55.92 节点上。

根据官方排查文档,先查询了各节点的 store 打分:

三个 store 的打分看起来差的不多。另外 scheduler 的信息如下:

到这里,不知道接下来应该朝哪个方向排查优化了,麻烦大佬给点思路,谢谢!

可以先参考这个文档排查下,先确认下是否有正常生成调度(在 pd-ctl 中看下具体的调度配置情况:config show scheduler),若调度正常生成,看下是否调度速度太慢,可以通过调大参数 leader-schedule-limit、 region-schedule-limit和 store limit 来加速 region 均衡:

https://docs.pingcap.com/zh/tidb/stable/pd-scheduling-best-practices#leaderregion-分布不均衡

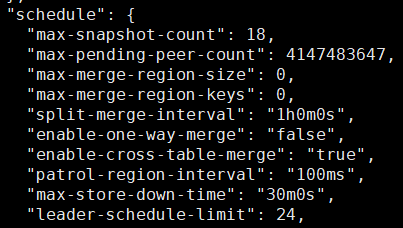

原配置:

修改后配置:

修改以下四个参数:

leader-schedule-limit: 12 → 24

region-schedule-limit: 40 → 80

max-pending-peer-count: 2147483647 → 4147483647

max-snapshot-count : 9 → 18

跑了段时间,region 还是很不均衡,接下来可以从哪个角度去排查问题?

从 pd-ctl 的 store 信息中查看,三个 tikv 使用空间只有 2 G 左右,region_score 的分数比较接近,可以看下集群中是否有较多的小 region 或者空 region ,如果是的话尝试进行 region merge ,然后再观察下 region 分布情况。

region merge ,可以了:

做了以下操作:

config set max-merge-region-keys 50000config set max-merge-region-size 10

根据官方文档,这两个值是有默认值的,但是刚查看的时候发现这两个参数值都是0:

这个到时候再看看,谢谢老哥!

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。