【 TiDB 使用环境】

【概述】:集群频繁的报9005导致业务写入慢

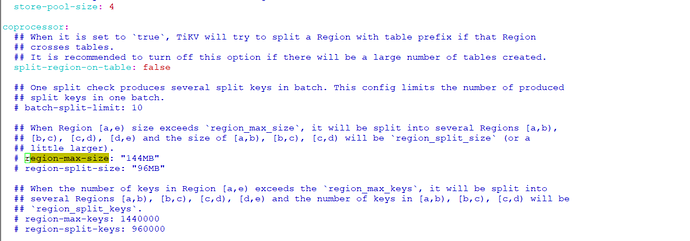

【背景】:优化过rafstore的参数,apply-pool-size /store-pool-size,append/apply logx响应小于100毫秒内,对业务表进行shard值为5.

符合这个case:https://github.com/pingcap/tidb-map/blob/master/maps/diagnose-case-study/case958.md

按这个排查过:https://docs.pingcap.com/zh/tidb/stable/tidb-troubleshooting-map#22-latency-持续升高

通过jq分析是否region存在没有leader问题,检查正常

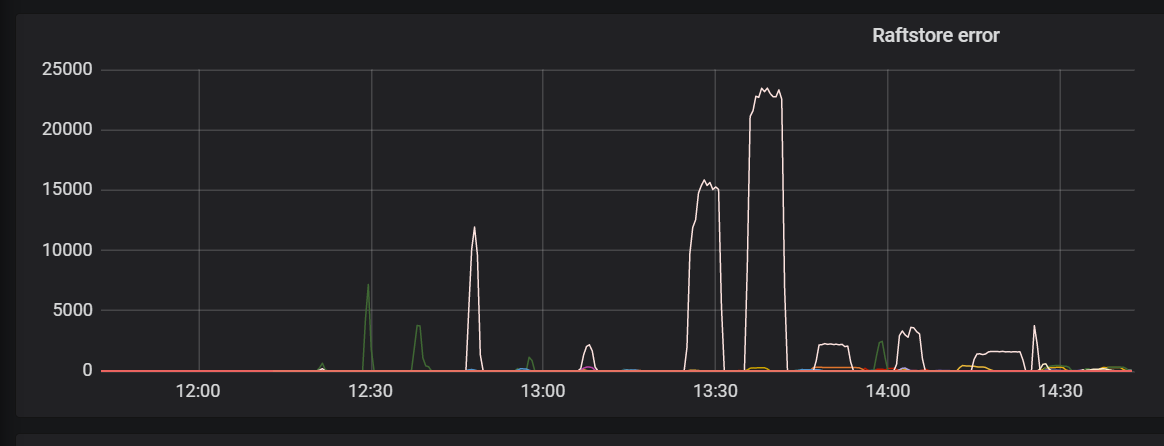

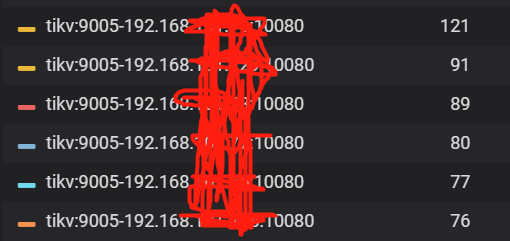

【现象】:业务属于每10分钟批量写入数据,一个批次在40W+左右,高峰期写入频繁报9005 Region is unavailable,raftstore error值报err_epoch_not_match,根据日志查看是数据写入后split引起的问题

【问题】:集群频繁的9005,引起写入慢

【业务影响】:数据写入延迟,影响报表等服务

【TiDB 版本】:V3.0.19