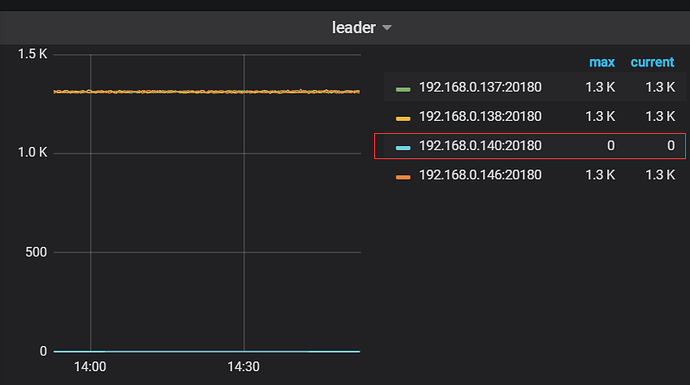

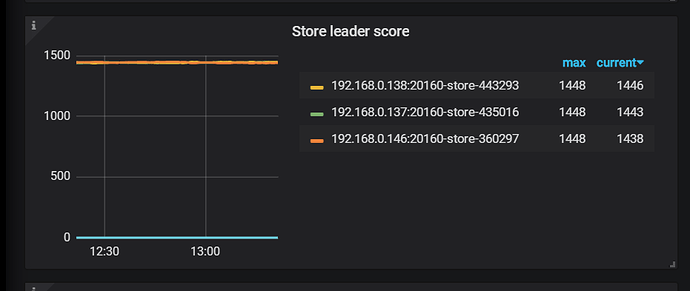

【概述】 集群中有一台TIKV的leader为0!

【背景】 原来副本为4改成了3

【现象】

【问题】 为何PD没有向这个节点调度数据?

【业务影响】 这台服务器的负载小,导致其它负载加大

【TiDB 版本】

V4.0.9

【应用软件及版本】

【附件】 相关日志及配置信息

synclog为false

- TiUP Cluster Display 信息

Cluster type: tidb

Cluster name: tidb-test

Cluster version: v4.0.9

SSH type: builtin

Dashboard URL: http://192.168.0.145:2379/dashboard

ID Role Host Ports OS/Arch Sta tus Data Dir Deploy Dir

192.168.0.143:9093 alertmanager 192.168.0.143 9093/9094 linux/x86_64 Up /data/tidb/tidb-data/alertmanager-9093 /data/tidb/tidb-deploy/alertmanage r-9093

192.168.0.143:3000 grafana 192.168.0.143 3000 linux/x86_64 Up - /data/tidb/tidb-deploy/grafana-300 0

192.168.0.143:2379 pd 192.168.0.143 2379/2380 linux/x86_64 Up /data/tidb/tidb-data/pd-2379 /data/tidb/tidb-deploy/pd-2379

192.168.0.144:2379 pd 192.168.0.144 2379/2380 linux/x86_64 Up /data/tidb/tidb-data/pd-2379 /data/tidb/tidb-deploy/pd-2379

192.168.0.145:2379 pd 192.168.0.145 2379/2380 linux/x86_64 Up| L|UI /data/tidb/tidb-data/pd-2379 /data/tidb/tidb-deploy/pd-2379

192.168.0.143:9090 prometheus 192.168.0.143 9090 linux/x86_64 Up /data/tidb/tidb-data/prometheus-9090 /data/tidb/tidb-deploy/prometheus- 9090

192.168.0.143:4000 tidb 192.168.0.143 4000/10080 linux/x86_64 Up - /data/tidb/tidb-deploy/tidb-4000

192.168.0.144:4000 tidb 192.168.0.144 4000/10080 linux/x86_64 Up - /data/tidb/tidb-deploy/tidb-4000

192.168.0.145:4000 tidb 192.168.0.145 4000/10080 linux/x86_64 Up - /data/tidb/tidb-deploy/tidb-4000

192.168.0.137:20160 tikv 192.168.0.137 20160/20180 linux/x86_64 Up /data/tidb_data/tikv-20160 /data/tidb_deploy/tikv-20160

192.168.0.138:20160 tikv 192.168.0.138 20160/20180 linux/x86_64 Up /data/tidb_data/tikv-20160 /data/tidb_deploy/tikv-20160

192.168.0.140:20160 tikv 192.168.0.140 20160/20180 linux/x86_64 Up /data/tidb_data/tikv-20160 /data/tidb_deploy/tikv-20160

192.168.0.146:20160 tikv 192.168.0.146 20160/20180 linux/x86_64 Up /data/tidb_data/tikv-20160 /data/tidb_deploy/tikv-20160

Total nodes: 13

- TiUP CLuster Edit config 信息

监控(https://metricstool.pingcap.com/)

- TiDB-Overview Grafana监控

- TiDB Grafana 监控

- TiKV Grafana 监控

- PD Grafana 监控

- 对应模块日志(包含问题前后 1 小时日志)