为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【概述】k8s上docker容器启动,3个tikv节点有1个报错

【背景】清空挂载硬盘重新启动tikv服务,命令./tikv-server --config /config/tikv.toml >> /home/tikv.log &

【现象】1个tikv启动失败

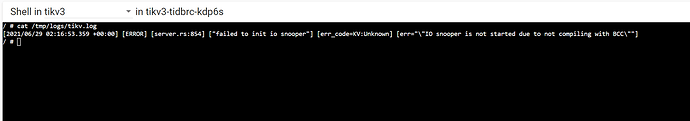

错误信息:

[2021/06/29 02:16:53.359 +00:00] [ERROR] [server.rs:854] [“failed to init io snooper”] [err_code=KV:Unknown] [err=“"IO snooper is not started due to not compiling with BCC"”]

【TiDB 版本】v5.0.1配置文件.docx (33.9 KB)

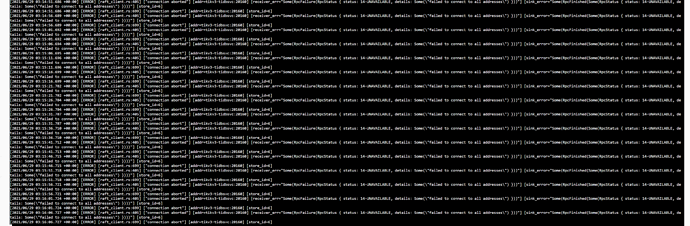

我看过这个帖子,我跟他的情况不太一样吧,我看了一下自己的集群硬盘正常挂载,而且我是新建集群,直接删除节点重建也试过不行,而且开始是两个tikv建起来了,但现在再看发现有两个的日志都有点问题,一个和上一个报同一个错误,另一个是这样:

懂的都懂

2021 年6 月 29 日 03:59

6

可以提供一下完整的 tikv.log 和 tikv_err.log 吗

新建文本文档.txt (14.3 KB)

没有使用operator部署,是采用 TiDB Docker 部署方案部署。配置文件.docx (92.9 KB) 1.0是配置pv的我截掉了,可以算是全部yaml配置文件。

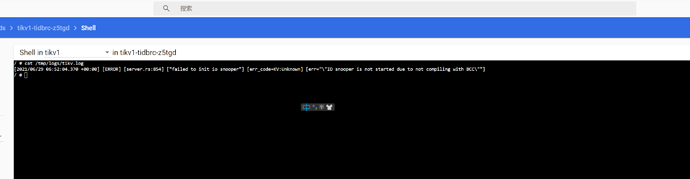

好吧我发现是tikv三个容器都报这个群,只是之前另外两个tikv容器映射的端口可以telnet通,我就以为是容器服务正确启动起来了。我删了重建一次,就是这报错:

这是我配置有问题吗?我用的节点是27G内存,应该够了吧,一个节点指启动一个tikv容器。

懂的都懂

2021 年6 月 29 日 06:58

14

尝试一下 3.0 的版本吧。4.0 的版本应该就已经不维护了。

懂的都懂

2021 年6 月 29 日 06:58

15

另外,建议您安装一下日志回收系统,您的 tikv 的日志并不完整。需要完整日志来排查情况。

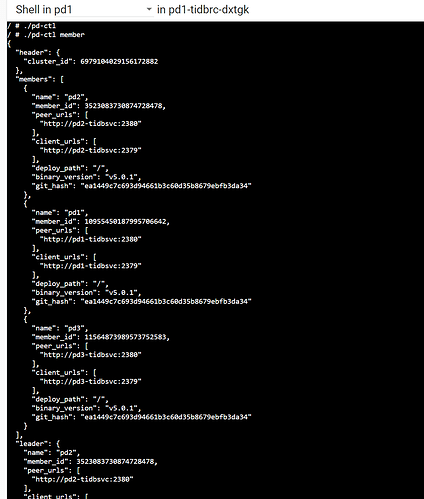

另外我有考虑使用tidb operator进行部署,但是不知道是不是我部署的配置文档有问题,先会启动三个pd,且三个pd容器都因为绑定pv的问题启动失败,请问有详细一点的tidb集群配置文件吗?三个pd的话怎么挂载硬盘呢?

懂的都懂

2021 年6 月 29 日 07:12

19

懂的都懂

2021 年6 月 29 日 07:15

20

kubernetes 上裸安装 tidb cluster 可能会导致 pv 双写的问题。

懂的都懂

2021 年6 月 29 日 10:47

22

参数上会有不兼容的情况。https://docs.pingcap.com/zh/tidb-in-kubernetes/stable

1. 准备 Kubernetes 的网络环境

如果你使用可类似于 Kubeadm 这样的工具部署,请确保以下的组件可以正常运行

kube-proxy

flannel

coredns

如果你使用了二进制的部署方式,可以参考以下步骤安装上述的组件。

1.1 部署 flannel

1.1.1 下载 flannel package

## create a folder to download th…

2. 部署 TiDB Operator

2.1 创建 TiDB Operator CRD

2.1.1 下载 TiDB Cluster CRD 部署文件

[root@r21 soft]# wget https://raw.githubusercontent.com/pingcap/tidb-operator/v1.1.7/manifests/crd.yaml

2.1.2 创建 TiDB Clust…

system

2022 年10 月 31 日 19:20

23

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。