萍萍723

1

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

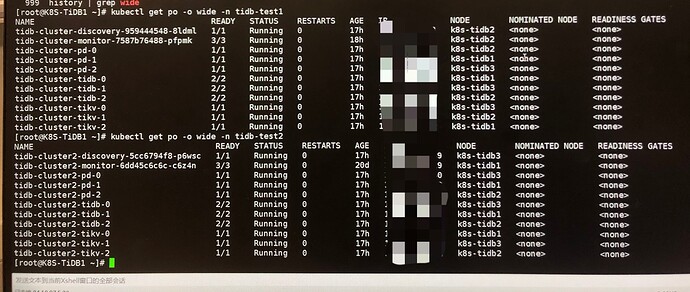

【概述】:一个K8s上运行多个TiDB集群,在宿主机内存、CPU、网络、磁盘没有到瓶颈的情况下,压测过程中发现集群之间有一定干扰,出现性能下降

【背景】:sysbench压测

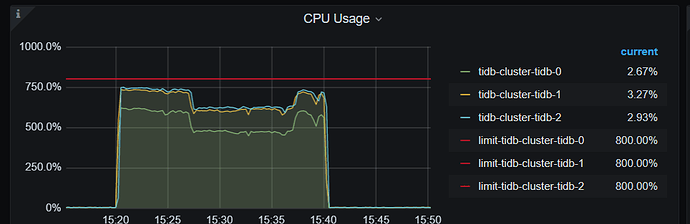

【现象】:2个TiDB集群在进行压测的时候,CPU、内存、磁盘、网络均未到瓶颈,TPS比单个集群压测时有较为明显的下降,且延时也增加

【问题】:k8s部署多个TiDB集群,在压测时发现会互相干扰

【业务影响】:

【TiDB 版本】:v4.0.12

【TiDB Operator 版本】:v1.1.12

【K8s 版本】:v1.14.0

【附件】:

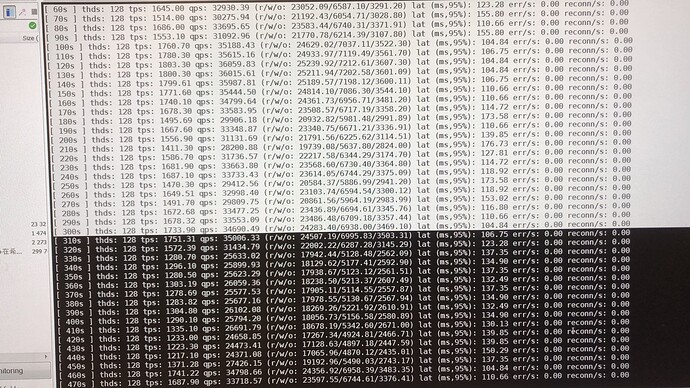

(在300s左右的时候跑上的第二个sysbench)

1 个赞

萍萍723

3

1、集群拓扑架构:PD、TiDB、TIKV各一个实例,压测机是集群外的另一台服务器

2、压测的服务器没有使用公用的ELB

萍萍723

5

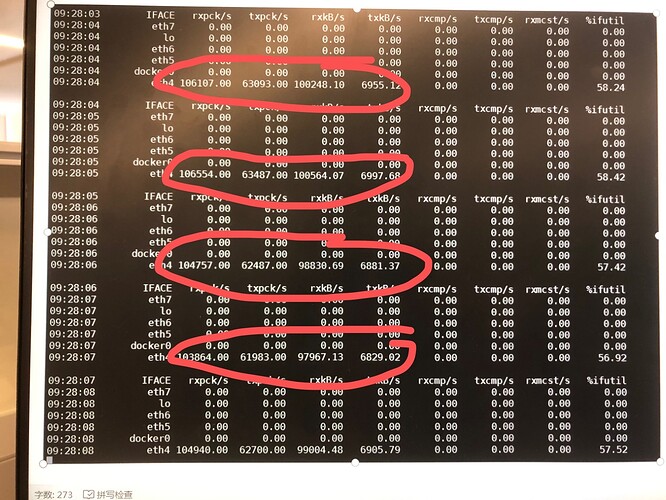

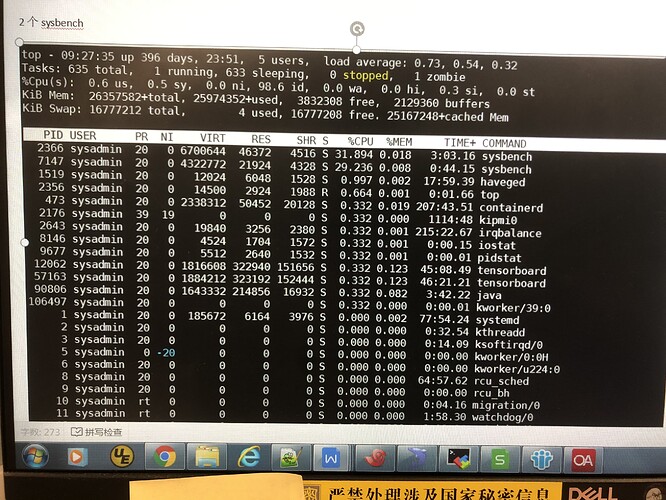

1、发压机器的资源使用情况均未达到饱和状态,CPU、磁盘,内存使用均良好。

2、压测机到2个tidb的网络带宽未打满

yilong

(yi888long)

6

麻烦先收集下两个集群,这段时间的 over-view,tidb ,detail-tikv 监控,多谢。

萍萍723

8

萍萍723

10

萍萍723

12

1、第一个集群压测的时候,TPS在1500~1700左右,第二个集群压测打开后,集群1的TPS下降了400~500

2、node 的哪些监控信息