【 TiDB 使用环境】生产环境

【 TiDB 版本】5.3.0

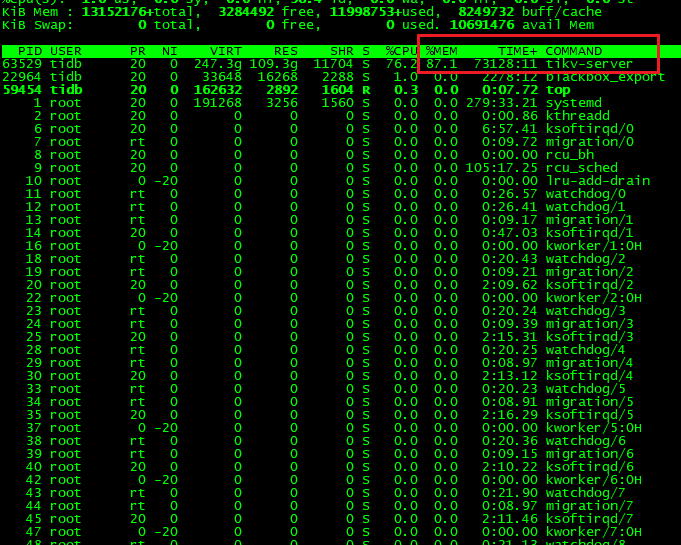

【遇到的问题】已设置 storage.block-cache.capacity 参数限制 Block Cache Size 为 90G。但是Grafana 面板显示 Block Cache Size 为 75G。系统 top 命令显示 TiKV-Server 占用了 111G 内存。

【问题现象及影响】

- 如下为

tiup cluster edit-config <集群名>返回的 TIKV 配置

tikv:

raftdb.defaultcf.block-cache-size: 4GiB

readpool.unified.max-thread-count: 38

rocksdb.defaultcf.block-cache-size: 50GiB

rocksdb.lockcf.block-cache-size: 4GiB

rocksdb.writecf.block-cache-size: 25GiB

server.grpc-concurrency: 14

server.grpc-raft-conn-num: 5

split.qps-threshold: 2000

storage.block-cache.capacity: 90GiB

-

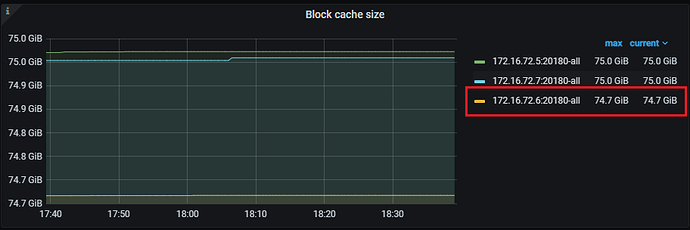

下图为

Grafana->TiKV-Detail->RocksDB-KV->Block Cache Size面板,

-

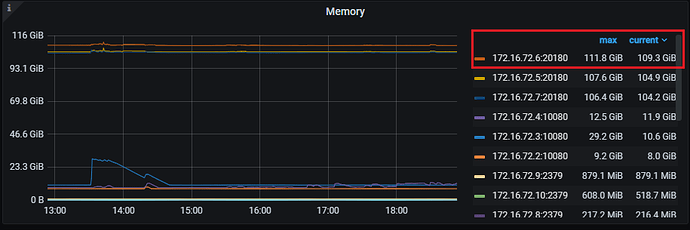

下图为

Grafana->TiKV-Detail->Cluster->Memory面板,这里和系统 top 显示的一致。

疑问

-

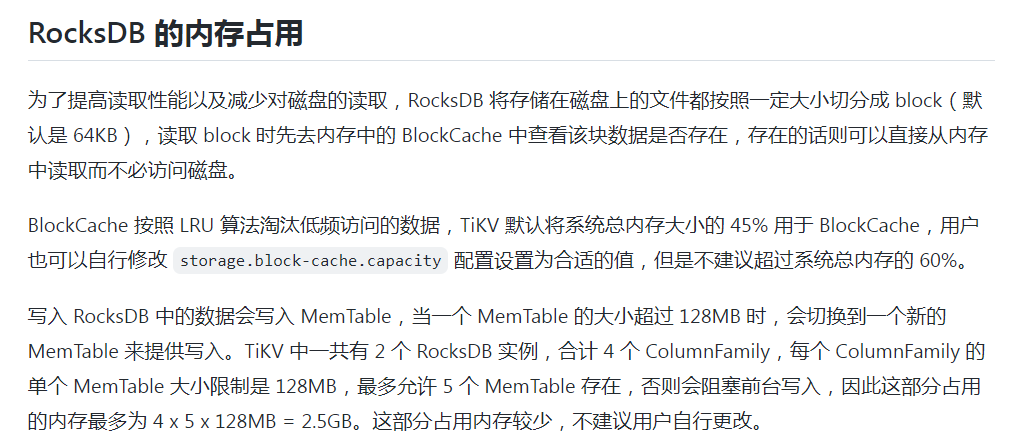

Grafana->TiKV-Detail->RocksDB-KV->Block Cache Size面板的值不应该是90G么?为何是75G? -

Grafana->TiKV-Detail->Cluster->Memory显示 TIKV 一共使用了 111G 内存,那剩下的 36G(即111-75)被谁用了?在哪个面板查?