【 TiDB 使用环境】生产 【 TiDB 版本】v6.1.0 【遇到的问题】配置placement rules 没有生效 【复现路径】做过哪些操作出现的问题`

【问题现象及影响】

- 第一次使用tiup的时候没有配置tikv的region选项, 后来补充了这个选项

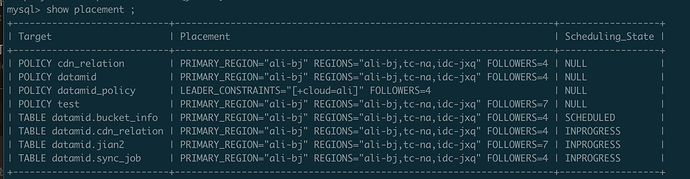

目前的配置:

datamid这个规则 放在了 bucket_info 和 cdn_relation 这两个表上,

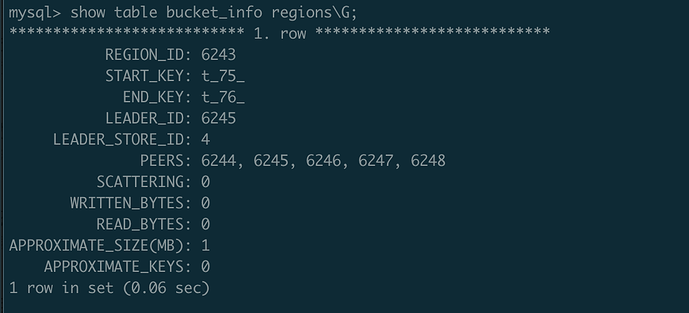

bucket_info 表 LEADER_STORE_ID 是调度过去了 (不确定是调度过去还是频繁修改重启tikv当中的误操作), PEERS数量还是5个

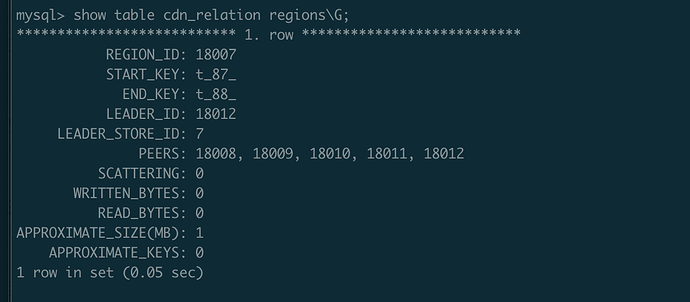

cdn_relatioin 这个表 LEADER_STORE_ID 还是在其他region的tikv节点上

这个是 pd-ctl config show的输出

{

“replication”: {

“enable-placement-rules”: “true”,

“enable-placement-rules-cache”: “false”,

“isolation-level”: “”,

“location-labels”: “cloud,zone,rack,host”,

“max-replicas”: 5,

“strictly-match-label”: “false”

},

“schedule”: {

“enable-cross-table-merge”: “true”,

“enable-joint-consensus”: “true”,

“high-space-ratio”: 0.7,

“hot-region-cache-hits-threshold”: 3,

“hot-region-schedule-limit”: 4,

“hot-regions-reserved-days”: 7,

“hot-regions-write-interval”: “10m0s”,

“leader-schedule-limit”: 4,

“leader-schedule-policy”: “count”,

“low-space-ratio”: 0.8,

“max-merge-region-keys”: 200000,

“max-merge-region-size”: 20,

“max-pending-peer-count”: 64,

“max-snapshot-count”: 64,

“max-store-down-time”: “30m0s”,

“max-store-preparing-time”: “48h0m0s”,

“merge-schedule-limit”: 8,

“patrol-region-interval”: “10ms”,

“region-schedule-limit”: 2048,

“region-score-formula-version”: “v2”,

“replica-schedule-limit”: 64,

“split-merge-interval”: “1h0m0s”,

“tolerant-size-ratio”: 0

}

}