为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】4.0.12

【问题描述】

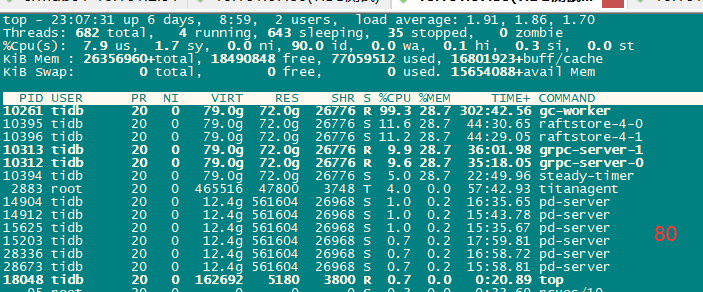

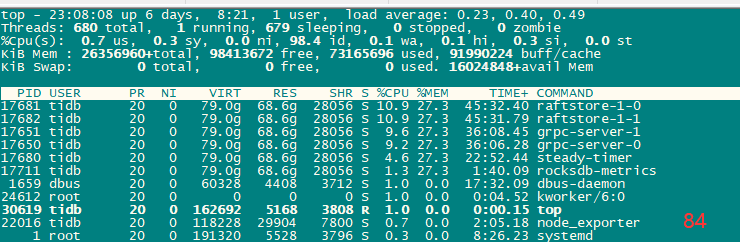

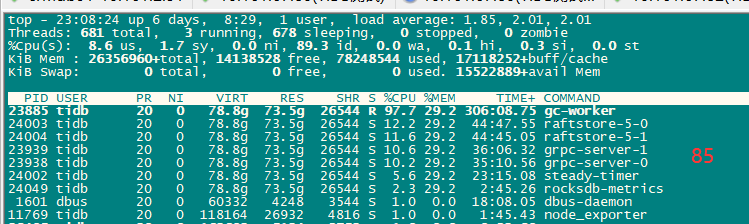

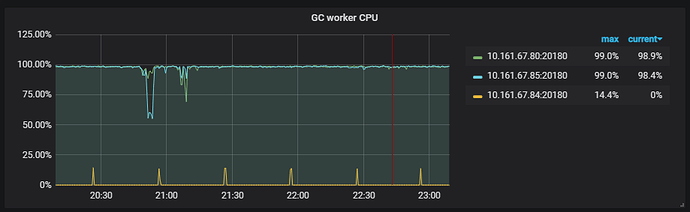

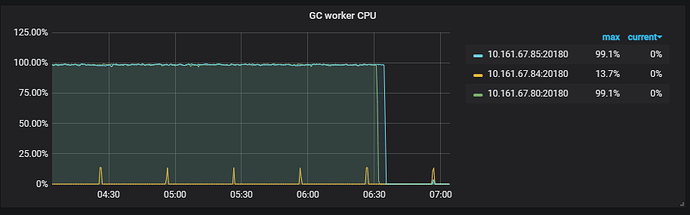

3节点tikv , 其中2个节点的gc-worker CPU利用率高,剩下1个该线程 CPU 利用率几乎为0

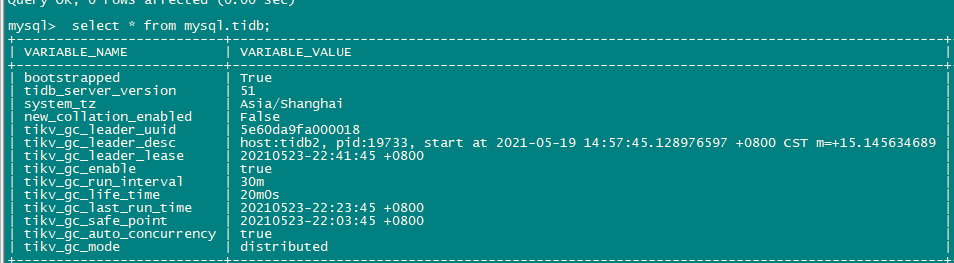

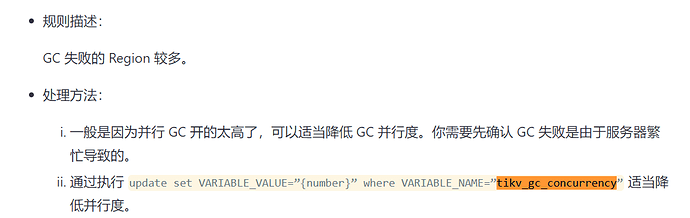

1、 什么原因导致GC 线程CPU利用率差异较大? 如果是Leader 写入不均衡 该如何找到这些region?

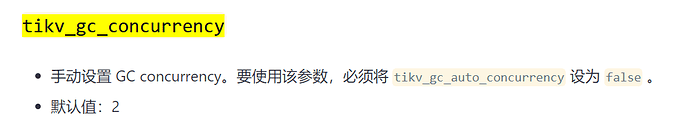

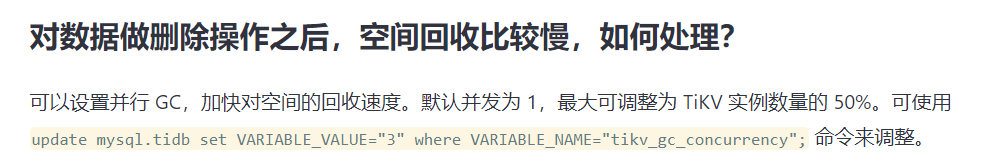

2、 官方描述禁用tikv_gc_auto_concurrency 但tidb表里并没有该参数设置,该如何调整

谢谢!