【 TiDB 使用环境】

- 生产,v4.0.12

【概述】 场景 + 问题概述

- 单

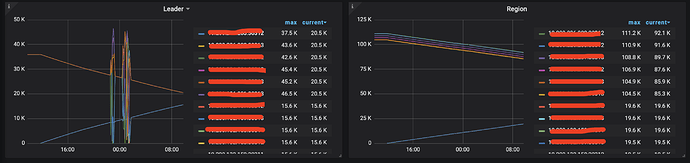

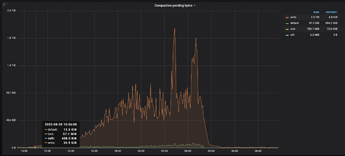

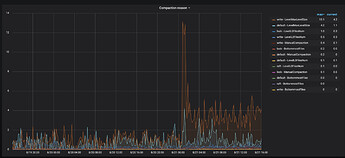

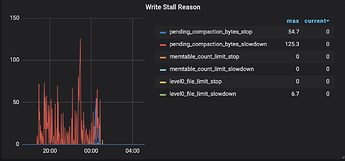

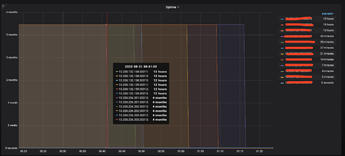

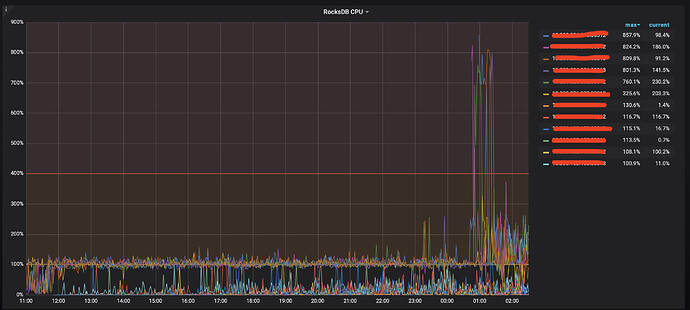

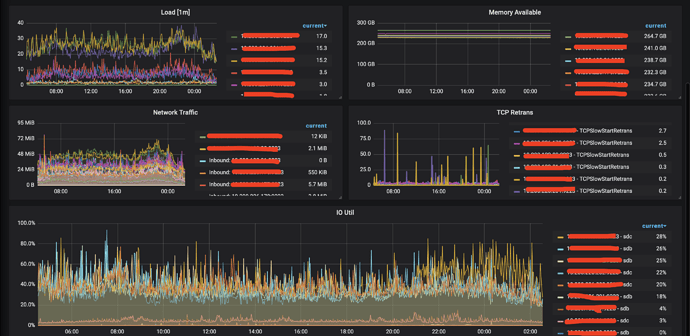

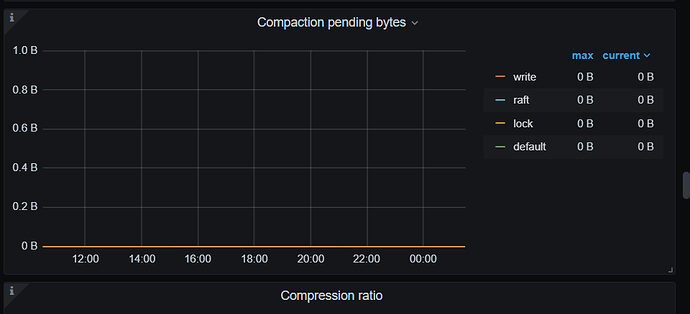

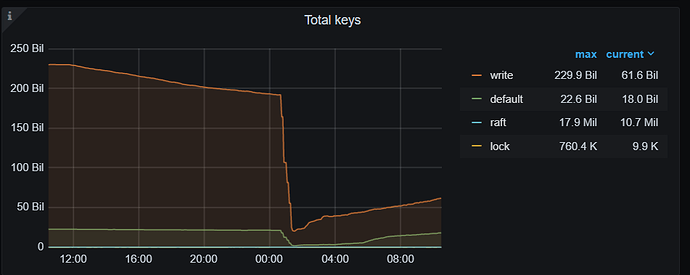

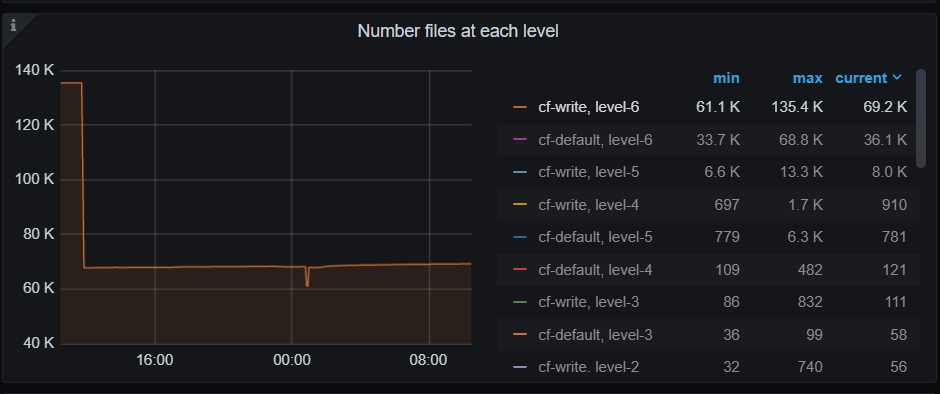

tikv的region10w,leader在 3.6w, 扩容过程中,刚开始没有无异常,因为扩容导致了config重新加载,配置alertmanager被覆盖,一直无告警,直到业务方反馈链接池打满,发现rocksdb-kvpending-compaction-bytes一直在持续增加,超过soft后write stall,在超过hard之后,集群恶化.

【背景】 做过哪些操作

-

扩容动作

tiup cluster:v1.2.3 scale-out xxx scale-out_tikv20220820.yml -i ../ssh/tiup -

rocksdb 线程池参数调整及

soft和hardpending-compaction-bytes-limit 调整,重启之后好转,因此我们判断为compaction太慢.

rocksdb.defaultcf.hard-pending-compaction-bytes-limit: 512G

rocksdb.defaultcf.soft-pending-compaction-bytes-limit: 512G

rocksdb.writecf.hard-pending-compaction-bytes-limit: 512G

rocksdb.writecf.soft-pending-compaction-bytes-limit: 512G

rocksdb.max-background-jobs: 12 -

部分监控如下

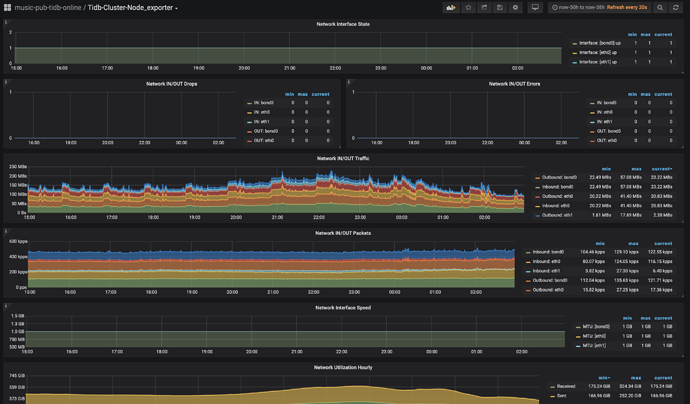

1). TiKV-Details

2). TiKV-Trouble-Shooting

-

留在最后:请教下社区大佬们,在扩容过程中

pending-compaction-bytes一直在增加是正常的现象吗