【 TiDB 使用环境】

生产

【 TiDB 版本】

v4.0.5

【遇到的问题】

执行如下命令时,出现报错。

命令:

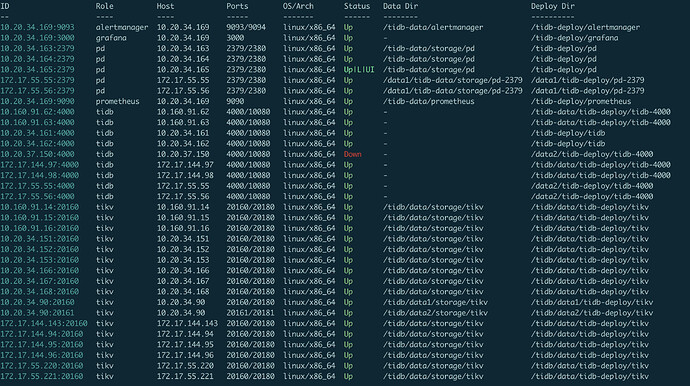

tiup cluster scale-in jichujiagou-bigdata-tidb --force --node 10.20.34.27:4000

报错:

Process exited with status 1 transfer from /home/tidb/.tiup/storage/cluster/clusters/jichujiagou-bigdata-tidb/config-cache/tikv-172.17.144.143-20160.service to /tmp/tikv_89549722-c523-47bf-b596-d769900441e5.service failed github.com/pingcap/tiup/pkg/cluster/spec.(*BaseInstance).InitConfig github.com/pingcap/tiup@/pkg/cluster/spec/instance.go:159 github.com/pingcap/tiup/pkg/cluster/spec.(*TiKVInstance).InitConfig github.com/pingcap/tiup@/pkg/cluster/spec/tikv.go:173 github.com/pingcap/tiup/pkg/cluster/task.(*InitConfig).Execute github.com/pingcap/tiup@/pkg/cluster/task/init_config.go:49 github.com/pingcap/tiup/pkg/cluster/task.(*Serial).Execute github.com/pingcap/tiup@/pkg/cluster/task/task.go:189 github.com/pingcap/tiup/pkg/cluster/task.(*Parallel).Execute.func1 github.com/pingcap/tiup@/pkg/cluster/task/task.go:242 runtime.goexit runtime/asm_amd64.s:1357 init config failed: 172.17.144.143:20160

【复现路径】

【问题现象及影响】

不确定缩容后,对现有集群是否有影响。