【 TiDB 使用环境】生产 【 TiDB 版本】5.1 【遇到的问题】tikv oom后,定位到可能是grpc 堆积,于是想限制grpc最大使用量,于是想调整参数server.grpc-memory-pool-quota,请问这个参数有什么注意事项吗,例如我的服务器内存是32g,分给block.cache的是15g,我打算分给server.grpc-memory-pool-quota:12g,是否合理? 【复现路径】做过哪些操作出现的问题`

【问题现象及影响】

如果超过了临时磁盘 tmp-storage-quota,可能报错 Out Of Global Storage Quota,目前支持落盘的算子有:Sort、MergeJoin、HashJoin、HashAgg,其他 join 内存统计还不准确,暂不支持落盘

https://docs.pingcap.com/zh/tidb/stable/configure-memory-usage/#数据落盘

官方建议仅在出现内存不足 (OOM) 的情况下限制内存使用。需要注意,限制内存使用可能会导致卡顿。

现在确实是 oom,tikv节点内存使用率高,目前是两个思路:

1、限制tikv的资源使用设置:不知道是否支持tidb集群已经搭建好的情况,(没有测试环境,头疼)

global:

user: “tidb”

resource_control:

memory_limit: “2G”

2、限制grpc内存使用,设置如下参数:

tikv:

server.grpc-memory-pool-quota

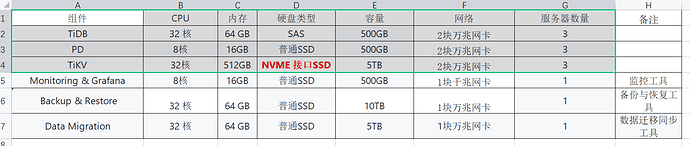

我们现在生产设计的时候,tikv都配置的512G内存物理机,性能拉满

你们厉害呀,哈哈哈,我们才32g,

能考虑上Tidb的都是核心大数据量的系统,配置低了比集中式的数据库性能还差,没有上的意义了

这倒是,那你们有设置 参数 server.grpc-memory-pool-quota吗, 那你们512g物理机,你们是单实例部署的吗

一个实例建议不超过2t,你们tikv规划5t是要做多实例吗?还是计划给备份使用呢?备份不应该用共享盘吗

BR备份恢复规划的10t数据,这个到时候需要nfs挂载这10t的盘到每个tikv节点上吧,

–>https://docs.pingcap.com/zh/tidb/v5.1/tikv-configuration-file#grpc-memory-pool-quota

- 如 cs58_dba 所说 “能考虑上Tidb的都是核心大数据量的系统,配置低了比集中式的数据库性能还差”。

- 文档中也指出 “需要注意,限制内存使用可能会导致卡顿” 这是业务可忍受的吗?

目前在 github 没找到相关已知 BUG。

是的,一般都是手动动态调整的

该主题在最后一个回复创建后60天后自动关闭。不再允许新的回复。