为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】

v4.0.10

【问题描述】

tikv日志内不断重启失败

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】

v4.0.10

【问题描述】

tikv日志内不断重启失败

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

麻烦确认一下,数据文件是否有丢失 ? 需要提供一下详细的 tikv log 看一下

麻烦确认一下 tikv 是否有重启,通过 welcome 字段进行过滤。

麻烦把这台 TiKV 第一次 panic 的前后的日志都上传一下吧,方便我们定位原因和提供解决方法

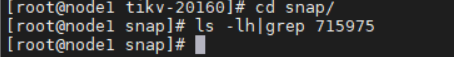

同时麻烦对这个 TiKV 当前 data/snap 目录 ls -lh|grep 715975 并贴一下结果吧,thanks!

该机器没有停过机

方便上传下完整的日志,不是截图吗? 这样方便搜索查看,多谢。

我这边的文件只有25M也上传不了

多谢反馈。

麻烦执行以下命令 find . -name “tikv.log*” |xargs grep “715975” 然后把文件上传一下吧,主要是需要看第一次 panic 之前的信息,后面不断 panic 重复的数据看不出原因。