为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】

3.0.12

5 tidb

3 tipd

5 tikv 双实例

CPU Gold 5218 * 2 64C

MEM 32G * 16 512G

SSD 3T * 2 用于双实例

【问题描述】

tikv内存不释放,每当集群稳定运行2-3个月后,需要手动滚动重启来缓解该问题.

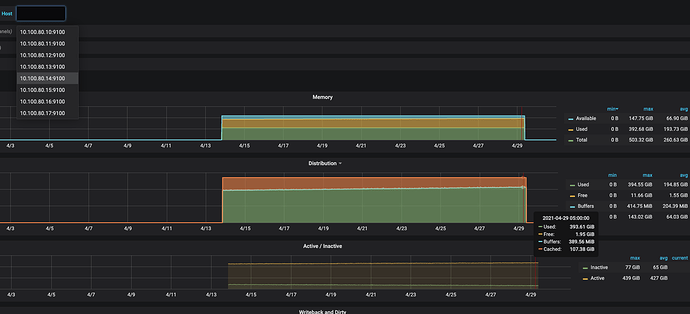

以下是监控图

监控是一个月的时间,前面的数据应该是被滚动清除了

图片都是大图,可以点击或拖拽到新窗口查看

node_exporter

overview

kv

THP默认关闭的

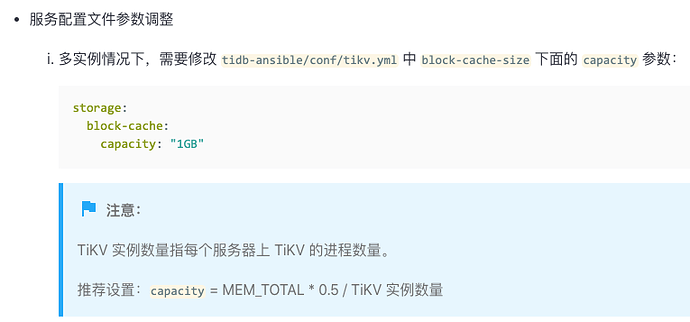

看到其他的文章主要在说是调节 block-cache capacity 的大小

我现在是512内存,按照官方文档的推荐是配置

512 * 0.5 / 2 = 128G

我现在配置的是80G

那么我应该是调大 还是 调小的?

这个问题持续了差不多一年了把,基本上每2-3个月重启下kv

block_cache 内存这块的大小应该是固定了的,超过 block cache size 部分的内存肯能是 Linux 内存中的 buffer 和 cache 的内存,可以尝试通过 linux 的命令手动清理一下

xfworld

(魔幻之翼)

5

他的期望是tikv 可以自动释放内存,不用手工运维,关注ing…

每几个月重启一下也很闹心的,如果内存持续增长要溢出,是不是 Linux 会 OOM 掉这个很吃内存的服务?

哥们懂我

虽然每隔个几个月这么手动运维,或者搞个自动化运维脚本,不痛不痒;

但是这个问题我问了好几个公司,目前都是这样,需要手动处理,确实有点尴尬;

1 个赞