为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】

v5.0.0(从v4.0.11升级上来的)

【问题描述】

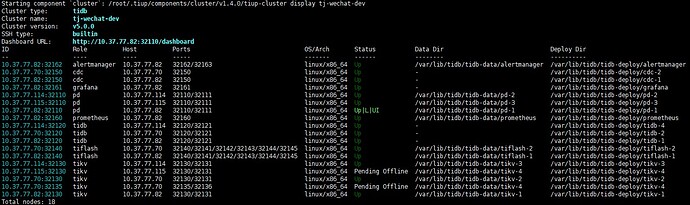

tikv最开始有三个节点,由于需要迁移,所以使用扩容后再缩容的办法。

max_replicas为默认值3。

首先通过scale-out,扩一个新节点(10.37.77.114),正常。

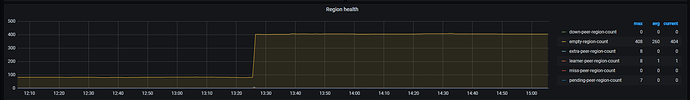

然后scale-in,缩一个旧节点(10.37.77.115),就一直处于Pending Offline。

翻了下社区帖子,说再扩一个后,再缩就好?…然后我就在(10.37.77.70:32136)扩了一个后,再删。

现在就115和70都删不掉了…

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。

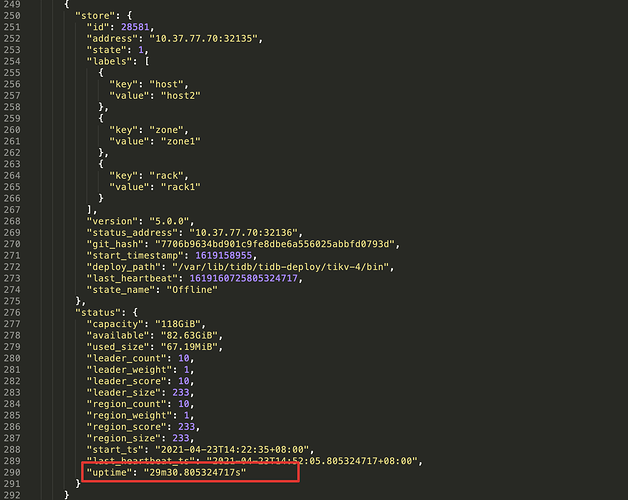

pd-ctl 执行下 store 命令看下

另外执行下 region store <store_id> 拿下下线的两个节点上的 region 信息。

是的… 看到社区别的帖子说 扩一个之后再缩回去就正常,就照着操作了。结果还是不行

下线的节点的时候要保证 tikv 进程是存活的,或者 region 或迁移不掉

tikv一直都是存活的,现在还活着,因为还有region没有转移走,然后一直没有转移走就下线不了

刚开始有。然后迁移到剩几个就不动了… 好久了…而且是开发环境 数据量不大 不可能因为量的问题

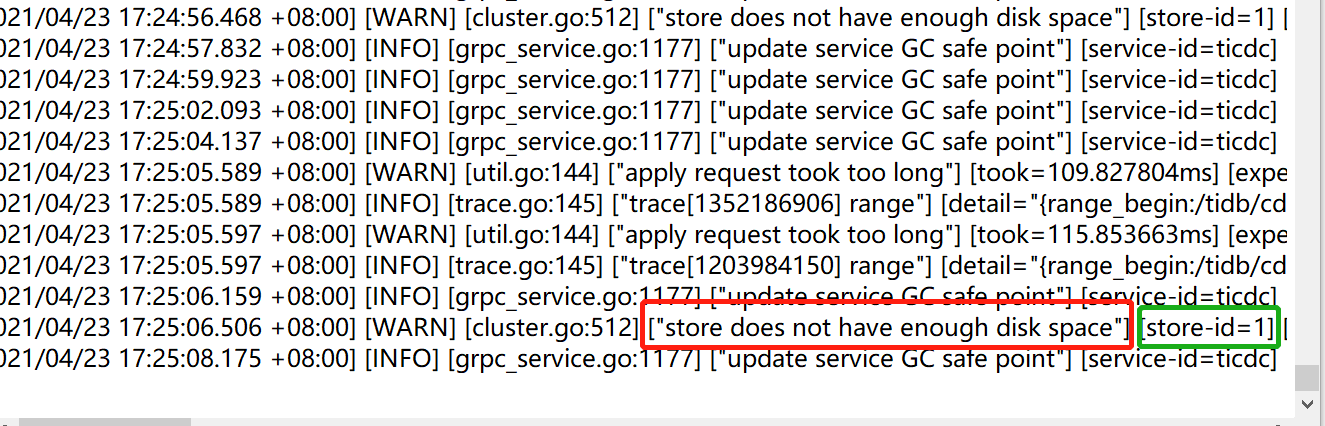

可以提供一下 pd leader 节点的日志信息么。

pd_stderr.log (16.8 KB) pd-1.log (4.0 MB) pd-2.log (4.3 MB)

日志我从扩容开始截取了出来,但还是太大 我分了2个文件给您

…还真是。 没注意到这台机 已经到90% 麻烦再问下,硬盘扩容后能自动恢复吗?