为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

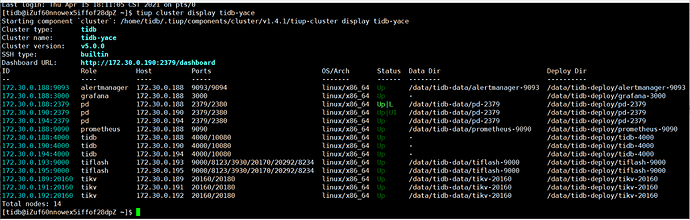

【TiDB 版本】

5.0 版测试

配置:

TIDB+PD+monitor 3台 8C 16G 100g硬盘

TIKV 3台 8C 16G 100g硬盘

DM+monitor+worker 1台 4C 8G 100g硬盘

TIFLASH 2台 8C 16G 100g硬盘

WORKER 1台 4C 8G 100g硬盘

【问题描述】

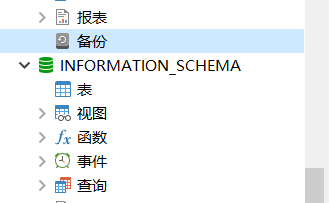

- 使用navicat无法看到INFORMATION_SCHEMA 下表,使用命令或sql可以查询到

navicat试过 10.* 12.*

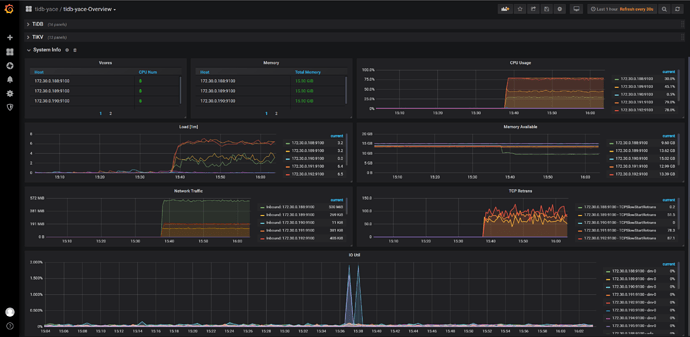

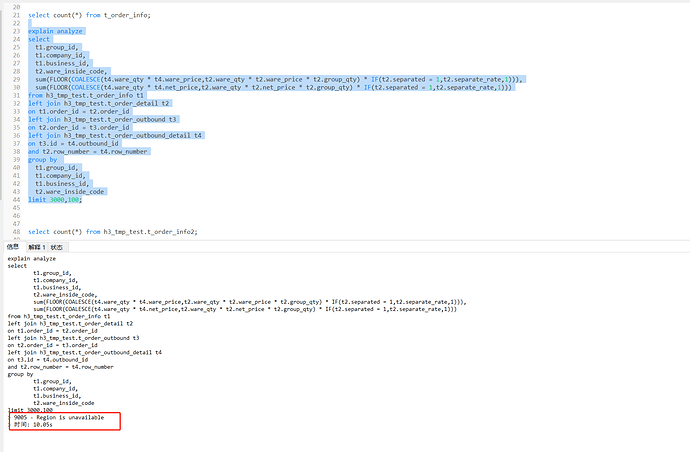

2.压测导致tiflush超时:什么原因?

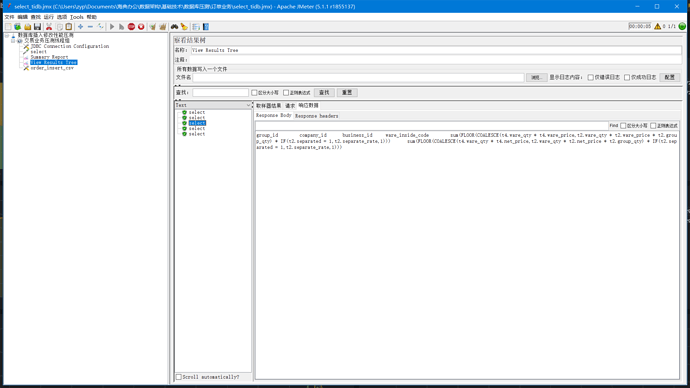

说明:2.1 压测指标 jmeter 32线程 32 连接 执行sql (尝试16线程 16连接数也是同样问题)

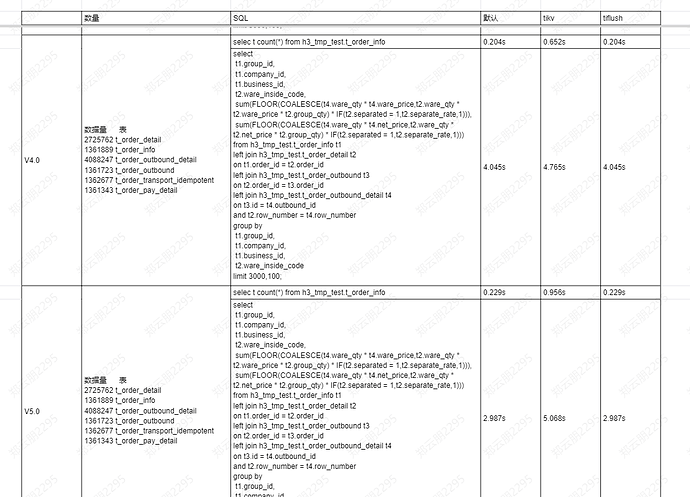

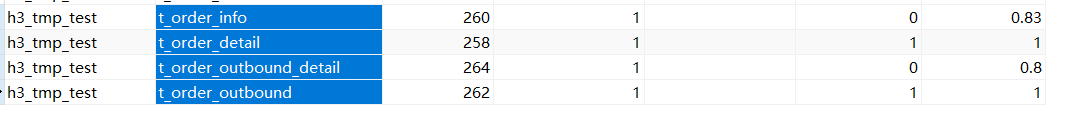

2.2 同样SQL 、压测指标4.0 QPS:2

- 4.0 5.0 压测结果

tiflush查询新能提升明显,tikv查询性能下降

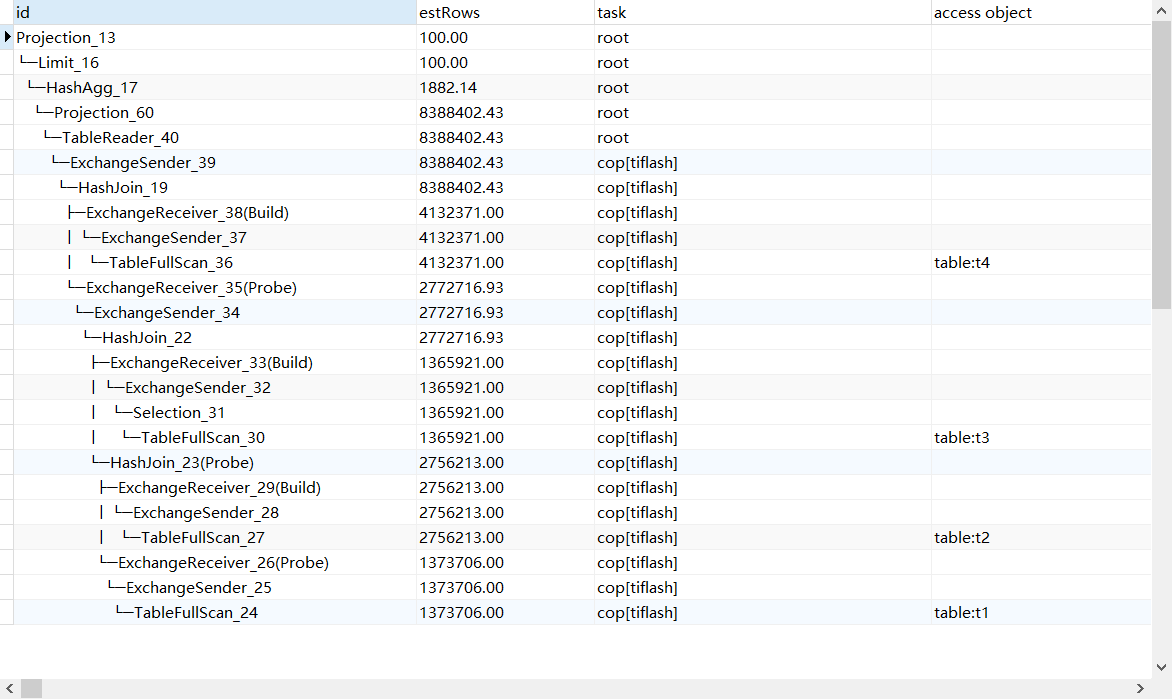

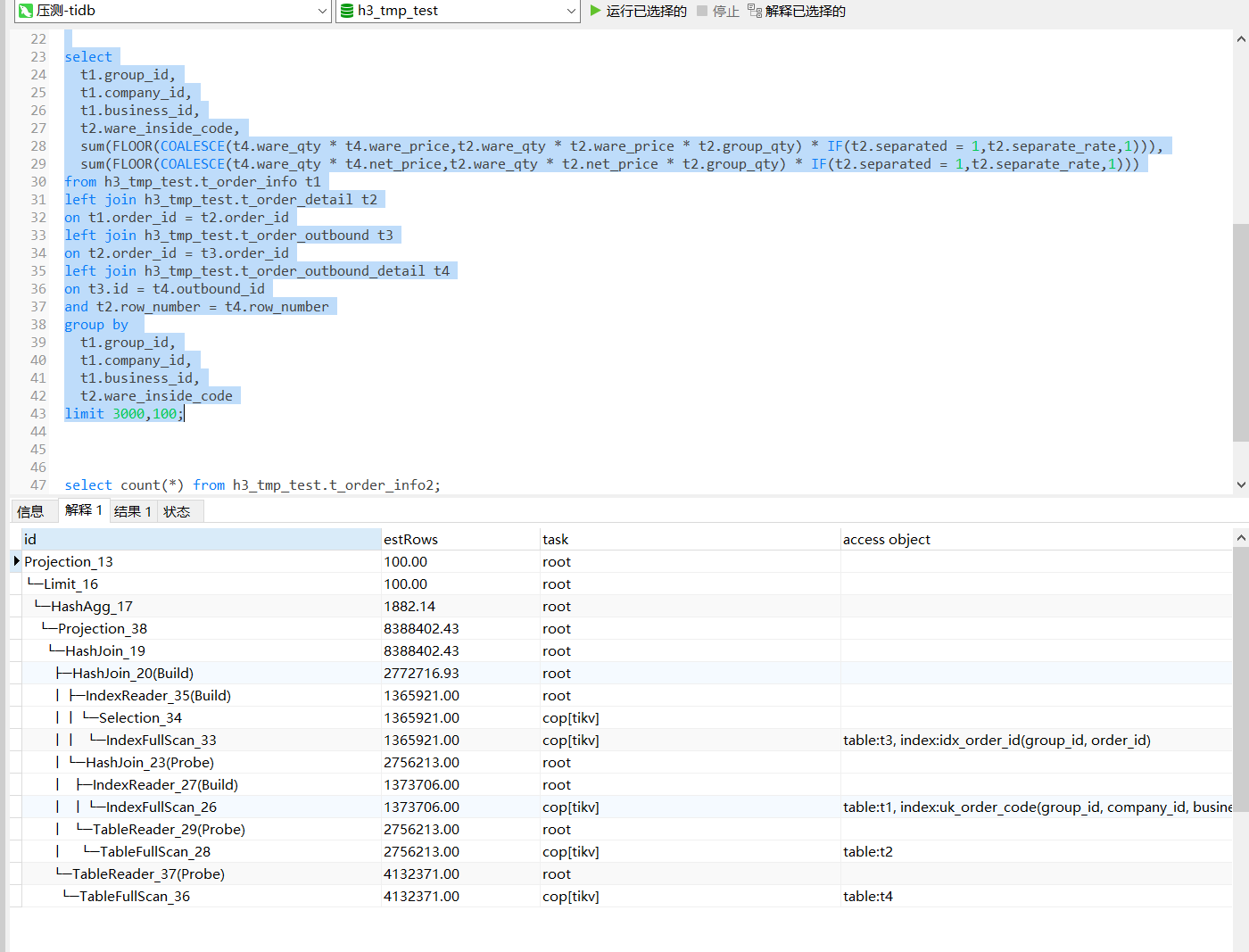

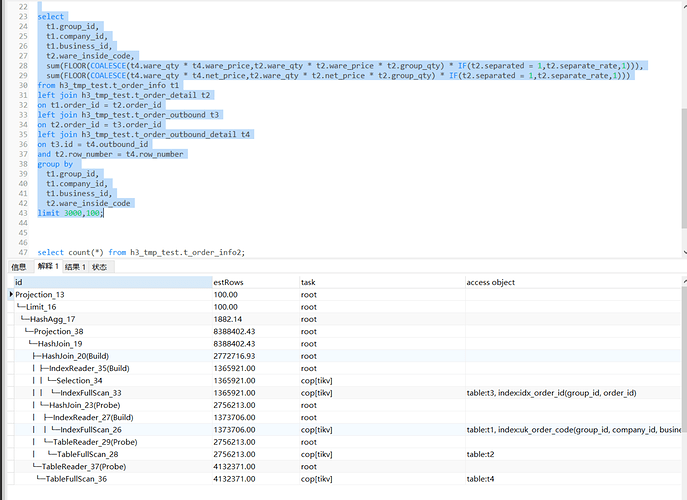

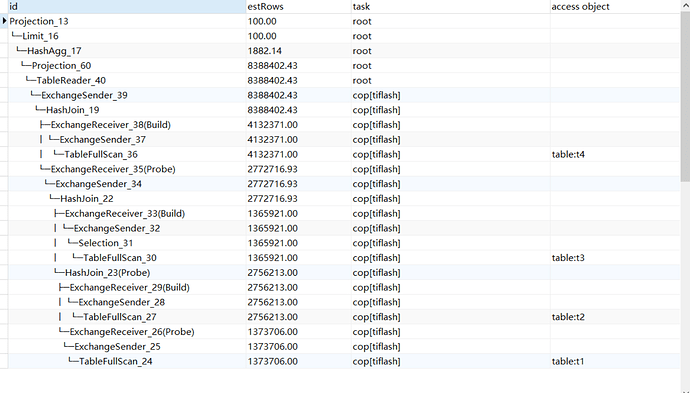

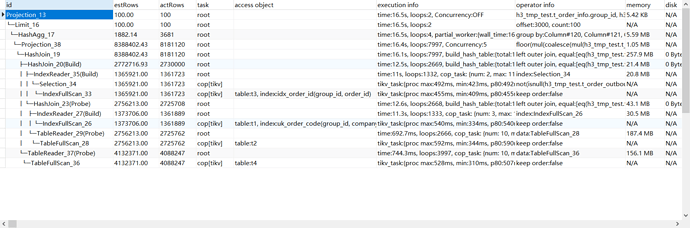

- 执行计划

sql中使用的关联均为主键,但是没有走索引?

- 数据库连接池问题

使用jmeter压测时,线程数100,连接数32 报错线程时内无可用线程

使用Mysql时不存在该问题,可能与SQL执行过慢有关,进一步排查中

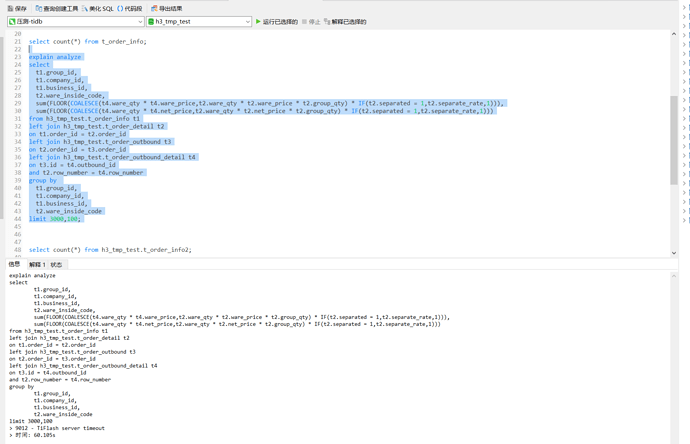

附:sql:

select

t1.group_id,

t1.company_id,

t1.business_id,

t2.ware_inside_code,

sum(FLOOR(COALESCE(t4.ware_qty * t4.ware_price,t2.ware_qty * t2.ware_price * t2.group_qty) * IF(t2.separated = 1,t2.separate_rate,1))),

sum(FLOOR(COALESCE(t4.ware_qty * t4.net_price,t2.ware_qty * t2.net_price * t2.group_qty) * IF(t2.separated = 1,t2.separate_rate,1)))

from h3_tmp_test.t_order_info t1

left join h3_tmp_test.t_order_detail t2

on t1.order_id = t2.order_id

left join h3_tmp_test.t_order_outbound t3

on t2.order_id = t3.order_id

left join h3_tmp_test.t_order_outbound_detail t4

on t3.id = t4.outbound_id

and t2.row_number = t4.row_number

group by

t1.group_id,

t1.company_id,

t1.business_id,

t2.ware_inside_code

limit 3000,100;