生产环境,前一天升级完6.1.0并开启动态裁剪模式,夜里跑批的时候所有的tiflash节点报错无法分配内存,导致服务器重启,重启后关闭了动态裁剪模式。环境为tikv和tiflash混合部署,今天没有出现内存无法分配的报错,但出现了以下报错,只有一个tiflash节点出现了问题,且这个节点没有配置numa,其它混合部署的节点配置了numa。

【 TiDB 版本】

6.1.0

【遇到的问题】

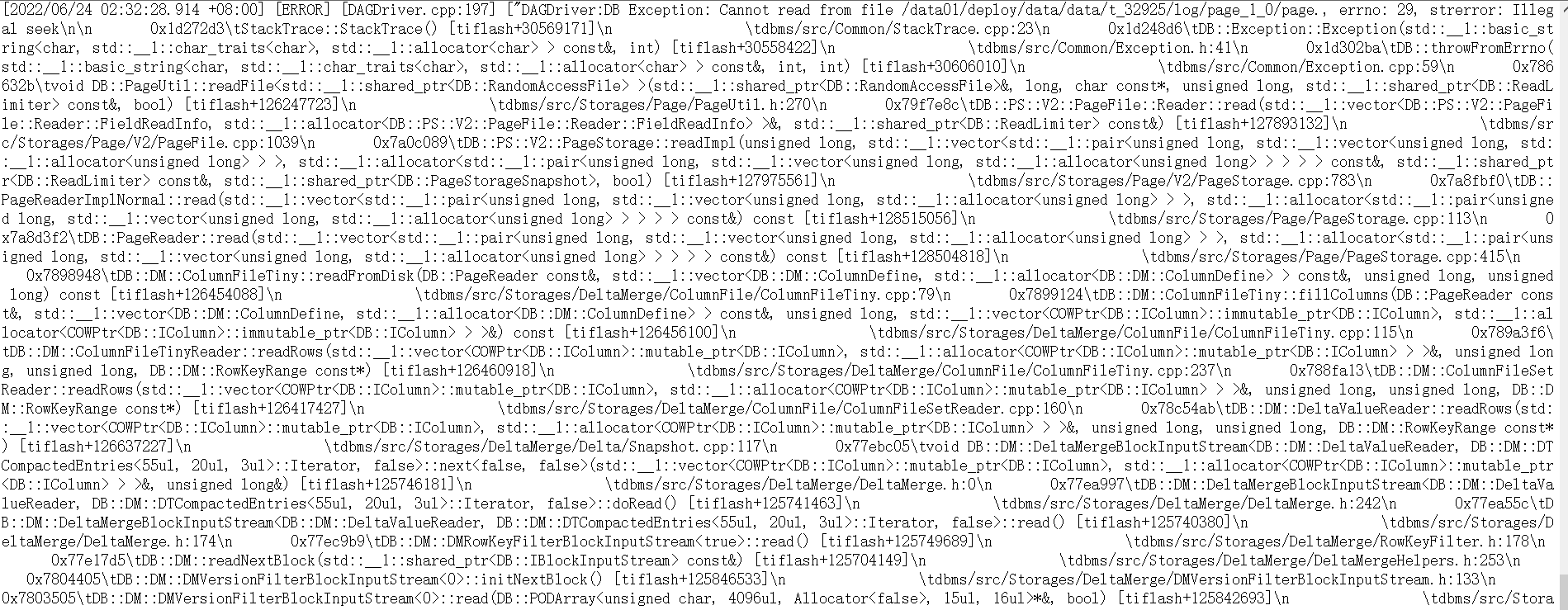

夜里跑批,tiflash反复重启,报错如下:

tiflash_stderr.log :

Logging debug to /data01/deploy/log/tiflash.log

Logging errors to /data01/deploy/log/tiflash_error.log

deprecated configuration, log-file has been moved to log.file.filename

override log.file.filename with log-file, “/data01/deploy/log/tiflash_tikv.log”

libc++abi: terminate_handler unexpectedly threw an exception

Logging debug to /data01/deploy/log/tiflash.log

Logging errors to /data01/deploy/log/tiflash_error.log

deprecated configuration, log-file has been moved to log.file.filename

override log.file.filename with log-file, “/data01/deploy/log/tiflash_tikv.log”

tiflash.log:

【处理】

问题节点强制缩容后再扩容没再报错,并添加了numa绑定。