【 TiDB 使用环境】生产\测试环境\ POC

【 TiDB 版本】5.4

【遇到的问题】使用dmctl同步数据意外终止报错

【复现路径】tiup dmctl --master-addr 172.21.0.5:8261 start-task --remove-meta task1.yaml

task1.yaml

【问题现象及影响】

同步10w行左右时会报错

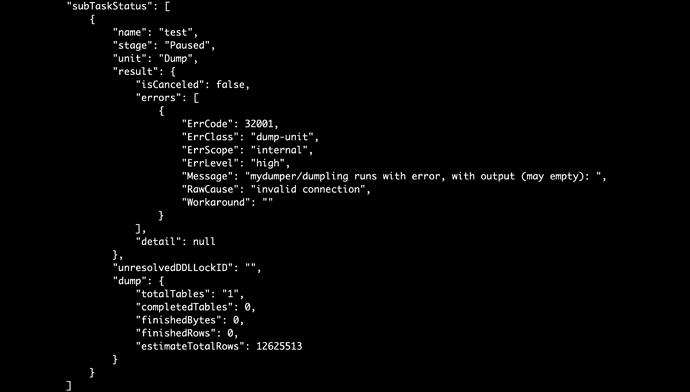

日志错误信息

[2022/06/21 15:34:50.817 +08:00] [WARN] [writer_util.go:181] [“fail to dumping table(chunk), will revert some metrics and start a retry if possible”] [task=test] [unit=dump] [database=news] [table=totalnews] [“finished rows”=9510] [“finished size”=10625668] [error=“invalid connection”]

【附件】

- 相关日志、配置文件、Grafana 监控(https://metricstool.pingcap.com/)

- TiUP Cluster Display 信息

- TiUP CLuster Edit config 信息

- TiDB-Overview 监控

- 对应模块的 Grafana 监控(如有 BR、TiDB-binlog、TiCDC 等)

- 对应模块日志(包含问题前后 1 小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。