缩容之后,可以按照提示tiup cluster prune tidb-mes执行,Tombstone状态的节点就会被清除。

grafana中会显示,是因为你选择的时间段包含了缩容节点的信息,选择执行tiup cluster prune tidb-mes之后的时间段,应该就不会显示缩容之后的节点了。

谢谢大师,果真如此。

关于加速迁移的参数,生产环境的话建议不要调整太高,你可以酌情设置。

也可以参考一下这个文章中的参数设置

专栏 - 生产环境TiDB集群缩容TiKV操作步骤 | TiDB 社区

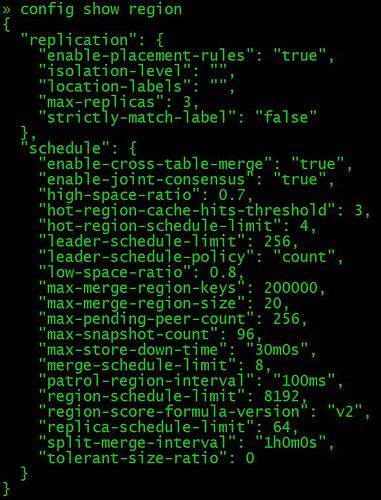

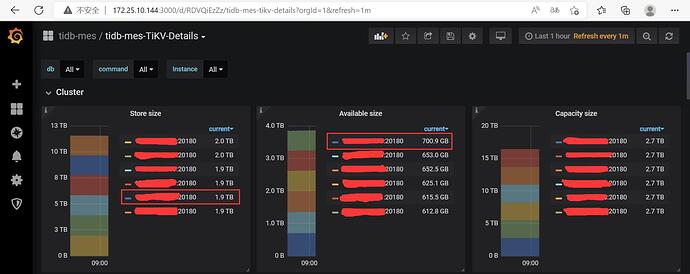

上述文档看完后我也将相关参数调整如下,但是今天看监控感觉速度还是超慢,已经用过es扩容同样的数据也就1-2个小时就自动同步完成,不知TiDB怎么慢,有没有其它参数需要修改?

config set leader-schedule-limit 256

config set region-schedule-limit 8192

config set max-pending-peer-count 256

config set max-snapshot-count 96

store limit all 800 add-peer

store limit all 20000 remove-peer

这两个参数都可以调整的大一些,甚至几千上万都行,前提是要注意集群的资源占用情况

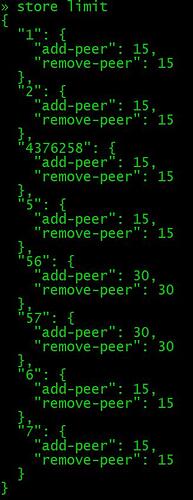

这二个值的确实值怎么查看?我准别region均衡完后再修改回来?

在pd-ctl中输入:

» store limit

如果我要恢复原值,是不是使用如下命令:

store limit all 15 add-peer

store limit all 15 remove-peer

store limit “56” 30 add-peer

store limit “56” 30 remove-peer

store limit “57” 30 add-peer

store limit “57” 30 remove-peer

对的,没问题

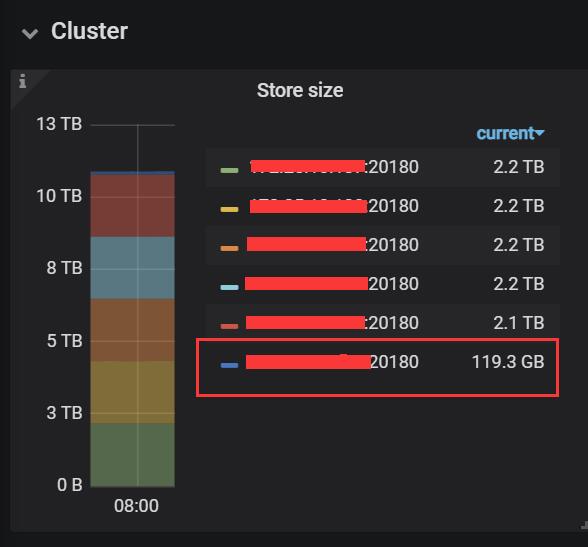

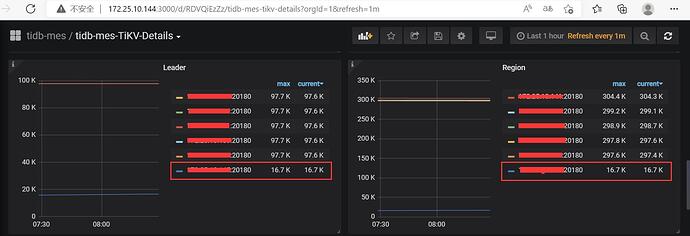

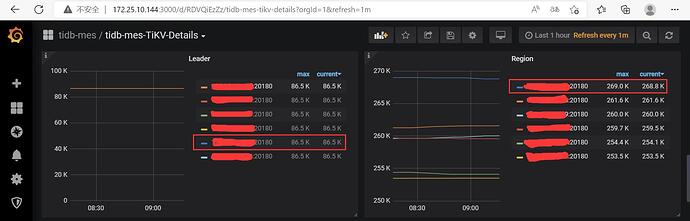

我一般就看下面的图,leader和region中的新增节点数据和其他节点基本一致就是完成了

好的,谢谢!

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。