【 TiDB 集群信息】

- 版本: v5.1.1

- TiKV节点个数: 5

【遇到的问题】

发现 TiKV region 分布不均衡,明明有个 TiKV 节点 (1.17) 可用容量只有 10%,可是 Store Region Score 分数却很高,这样的话会导致其他节点的资源无法得到充分利用!

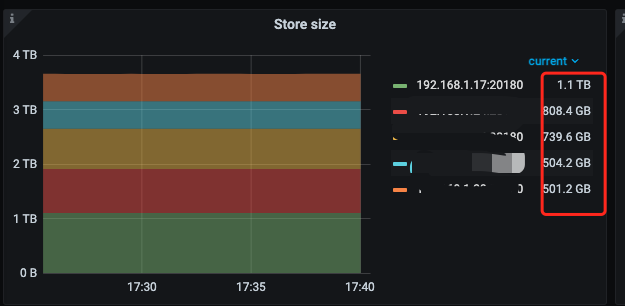

【grafana监控】

【 TiDB 集群信息】

【遇到的问题】

发现 TiKV region 分布不均衡,明明有个 TiKV 节点 (1.17) 可用容量只有 10%,可是 Store Region Score 分数却很高,这样的话会导致其他节点的资源无法得到充分利用!

【grafana监控】

TiKV的可用容量越少,Score就越高,这个没毛病啊。PD会把Region从分数高的Store上调度到分数低的上去

我把容量比较多的节点的 region-weight 设置成 1.1 了,但是看监控 region 的数量也没有增多啊,调度的话是比较看重 score 还是 region-height 呢

即使分数降低了,但是 store size 还是比其他节点大很多啊

没遇到过这个问题, 还是进来看下 大佬怎么处理的

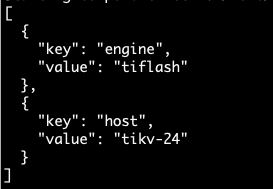

tikv有没有打过label,有没有自定义placement rules

集群里面有1个节点打了标签,本来想做多实例,后面做不成。placement rules 没有设置

去掉TiKV上没用的labels

检查空Region数量(Grafana PD页面的Region Health),确认schedule.enable-cross-table-merge为true

大佬,有几个疑问

1、删除标签需要重启才能生效吗?

2、空 region 会有什么影响吗?

1,修改reload是要重启的

2,你这个空Region不多,可以先不用管schedule.enable-cross-table-merge配置

3,参照一下这个SOP吧,写的比较全了