为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【TiDB 版本】V4.0.4

【问题描述】 由于目前的环境是虚拟机环境,我们计划把tikv节点全部改成物理机多实例的集群,在缩容虚拟机tikv节点前,计划先把3台物理机(每台物理机计划部署3个实例,3台物理机共计9个tikv节点)扩容上去。后续再缩容虚拟机的tikv。

一、配置cpu:72c,numa信息

NUMA node0 CPU(s): 0-17,36-53

NUMA node1 CPU(s): 18-35,54-71

二、内存:376G

三、SSD磁盘,每台物理机挂载挂载多个盘:如下

/dev/mapper/data1vg-data1lv 1.7T 195G 1.5T 12% /data1

/dev/mapper/data2vg-data2lv 1.7T 183G 1.5T 11% /data2

/dev/mapper/data3vg-data3lv 1.7T 196G 1.5T 12% /data3

四、根据以上信息,想咨询下以下几个扩容的问题

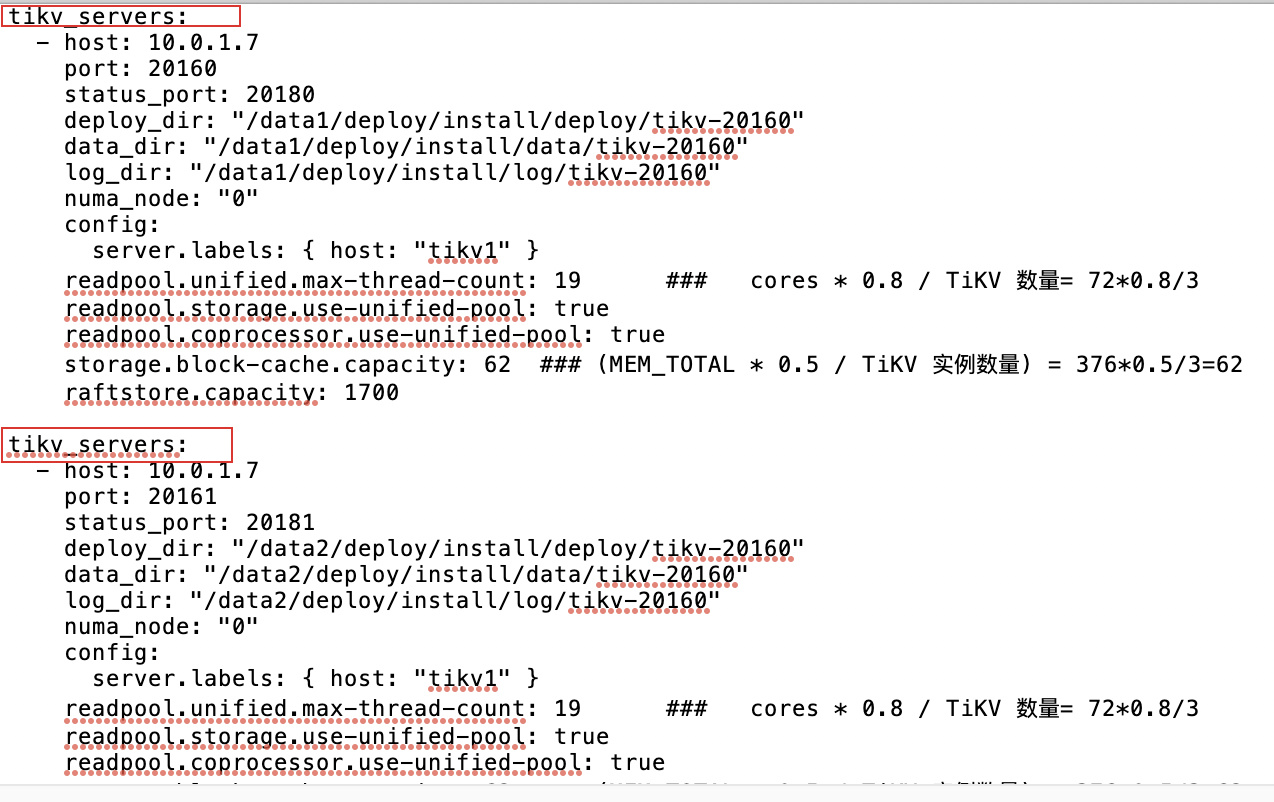

1、帮忙确认下以下附件中,扩容配置项是否可行(只写了一个物理机的扩容配置)

扩容配置.txt (1.8 KB)

2、如果可行,再帮忙解答下以下几个配置项

1)numa_node由于只有0和1,那么如果配置3个节点,是否有1个节点使用了其中36个cpu?是否有更优的节点数配置?

2)readpool.unified.max-thread-count 计算结果是 cores * 0.8 / TiKV 数量= 720.8/3 =19 是否可行?

3)storage.block-cache.capacity 计算结果是 MEM_TOTAL * 0.5 / TiKV 实例数量) = 3760.5/3=62 是否可行?

4)根据磁盘的挂载情况,raftstore.capacity 是否直接填写 1700 即可?还是说可以直接不需要这个配置?

由于是在虚拟机环境扩容物理机的节点,比较少这种场景的方案,还请帮忙解答下,感谢!