为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

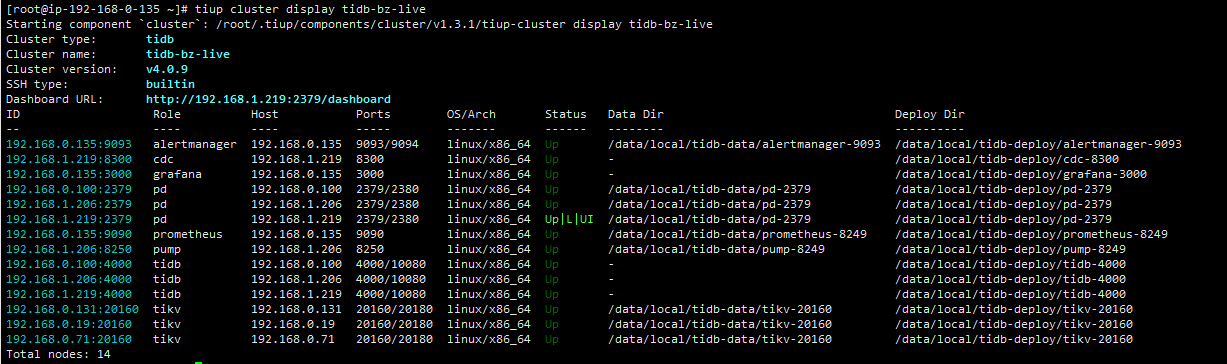

【TiDB 版本】tidb v4.0.9

【问题描述】我们tidb数据库生产环境v4.0.9,下游是mysql8.0.14, 添加了一个数据同步任务,现在查询cdc任务状态时,提示owner not found,这是什么原因导致的,现在数据不同步了,停止任务也报这个错误提示

查询状态

[root@ip-192-168-0-135 soft]# tiup cdc cli changefeed list --pd=http://192.168.1.219:2379

Starting component cdc: /root/.tiup/components/cdc/v4.0.9/cdc cli changefeed list --pd=http://192.168.1.219:2379

[2021/01/26 17:20:50.419 +08:00] [WARN] [client_changefeed.go:143] [“query changefeed info failed”] [error=“owner not found”]

[

{

“id”: “simple-replication-task”,

“summary”: null

}

]

停止任务报错

[root@ip-192-168-0-135 soft]# tiup cdc cli changefeed pause --pd=http://192.168.1.219:2379 --changefeed-id simple-replication-task

Starting component cdc: /root/.tiup/components/cdc/v4.0.9/cdc cli changefeed pause --pd=http://192.168.1.219:2379 --changefeed-id simple-replication-task

Error: owner not found

Usage:

cdc cli changefeed pause [flags]

Flags:

-c, --changefeed-id string Replication task (changefeed) ID

-h, --help help for pause

Global Flags:

–ca string CA certificate path for TLS connection

–cert string Certificate path for TLS connection

-i, --interact Run cdc cli with readline

–key string Private key path for TLS connection

–log-level string log level (etc: debug|info|warn|error) (default “warn”)

–pd string PD address, use ‘,’ to separate multiple PDs (default “http://127.0.0.1:2379”)

owner not found

Error: run /root/.tiup/components/cdc/v4.0.9/cdc (wd:/root/.tiup/data/SNC5vYM) failed: exit status 1

请问该如何处理?现在只同步了一张表的数据,如何能初始化重新同步整个数据库数据。