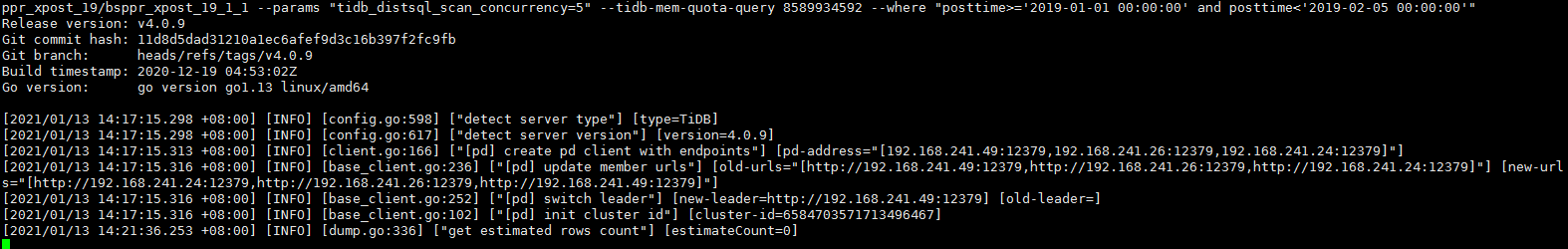

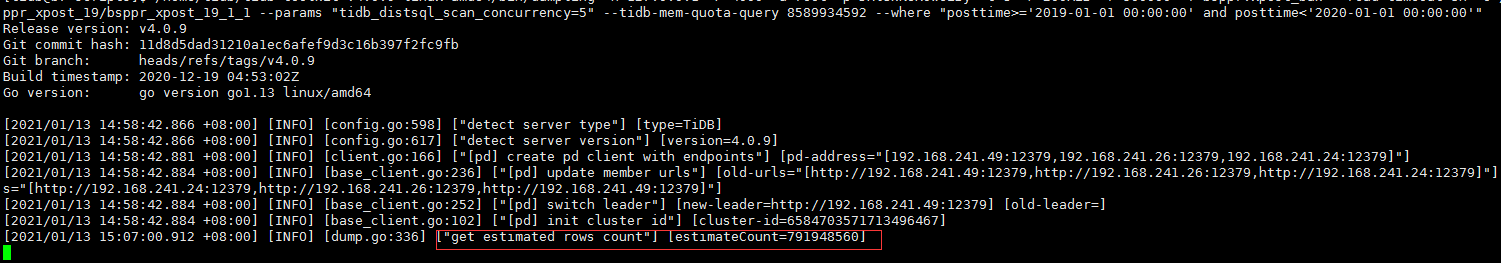

调整了参数仍然不能正常导出。-r设置为100不现实。

每个自然月有5千万-2亿的数据量。

/*!40101 SET NAMES binary*/;

CREATE TABLE `xpost` (

`postid` bigint(20) NOT NULL AUTO_INCREMENT,

`facetid` int(10) NOT NULL,

`entryid` int(10) NOT NULL,

`title` varchar(255) COLLATE utf8mb4_bin NOT NULL DEFAULT '',

`url` varchar(512) COLLATE utf8mb4_bin NOT NULL,

`abstract` text COLLATE utf8mb4_bin COMMENT '摘要',

`click` int(11) DEFAULT '0' ,

`reply` int(11) DEFAULT '0' COMMENT '回复/评论',

`repost` int(11) DEFAULT '0' COMMENT '转发',

`praise` int(11) DEFAULT '0' COMMENT '点赞',

`collect` int(11) DEFAULT '0' COMMENT '收藏',

`watch` int(11) DEFAULT NULL,

`wordscount` int(11) DEFAULT '0',

`keywordcount` int(11) DEFAULT NULL,

`siteid` int(11) DEFAULT '0',

`domain` varchar(60) COLLATE utf8mb4_bin DEFAULT '',

`author` varchar(60) COLLATE utf8mb4_bin DEFAULT '',

`author_id` varchar(60) COLLATE utf8mb4_bin DEFAULT '' ,

`posttime` datetime NOT NULL,

`include_t` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP,

`type` tinyint(4) DEFAULT '0' COMMENT 'positive/negtive/neutrual',

`source` int(11) DEFAULT '0',

`hidden` tinyint(4) NOT NULL DEFAULT '0',

`sourcetype` tinyint(4) NOT NULL,

`crisis_post` tinyint(4) NOT NULL DEFAULT '0',

`ontop` tinyint(4) NOT NULL DEFAULT '0' COMMENT '是否标记,0否1是',

`type_rank` tinyint(4) NOT NULL DEFAULT '0' ,

`noise_rank` tinyint(4) NOT NULL DEFAULT '0' ,

`device` varchar(60) COLLATE utf8mb4_bin DEFAULT '',

`is_origin` tinyint(4) NOT NULL DEFAULT '0',

`is_top` tinyint(4) NOT NULL DEFAULT '0',

`media_type` tinyint(4) NOT NULL DEFAULT '0',

`author_type` tinyint(4) NOT NULL DEFAULT '0' ,

`content_type` tinyint(4) NOT NULL DEFAULT '0',

`client_type` tinyint(4) NOT NULL DEFAULT '0',

`industry` varchar(60) COLLATE utf8mb4_bin DEFAULT '',

`tags` text COLLATE utf8mb4_bin,

`post_type` tinyint(4) DEFAULT '0' COMMENT '内容类型 0:未知,1;PGC,2:UGC',

`type_reason` varchar(256) COLLATE utf8mb4_bin DEFAULT '' ,

`update_time` datetime DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP ,

`origin_source` varchar(64) COLLATE utf8mb4_bin DEFAULT '',

`media_id` int(11) DEFAULT '0',

`w_level` tinyint(1) NOT NULL DEFAULT '0' ,

PRIMARY KEY (`postid`),

UNIQUE KEY `idx_fid_url` (`facetid`,`url`),

UNIQUE KEY `postid` (`postid`),

KEY `idx_xpost_url` (`url`(255)),

KEY `idx_xpost_entryid` (`entryid`),

KEY `idx_xpost_type` (`type`),

KEY `idx_xpost_sourcetype` (`sourcetype`),

KEY `idx_xpost_pt` (`posttime`),

KEY `idx_xpost_source` (`source`),

KEY `idx_fid` (`facetid`)

) ENGINE=InnoDB AUTO_INCREMENT=35754662501 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_bin ROW_FORMAT=DYNAMIC;