3.4 Data Backup and Restore (BR)(备份恢复工具 BR)

BR介绍

**Backup & Restore(以下简称 BR)是 TiDB 分布式备份恢复的命令行工具,用于对 TiDB 集群进行数据备份和恢复。相比 dumpling 和 mydumper ,BR 更适合大数据量的场景。

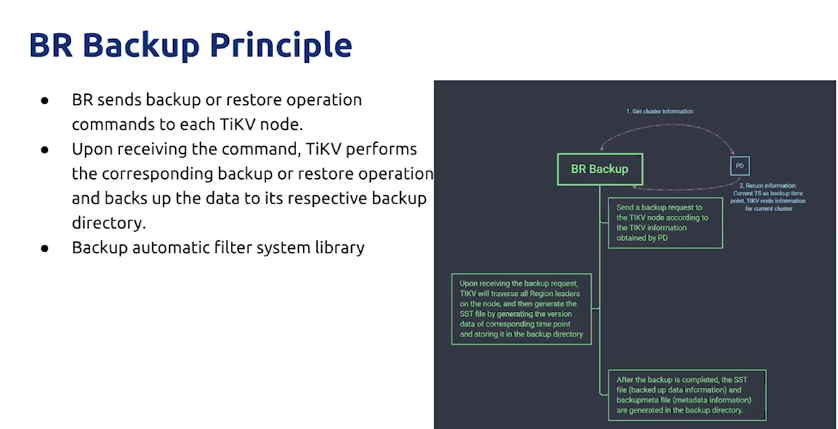

BR 备份的原理

BR的限制

新版备份恢复设计方案

背景:由于需要和 TiDB CDC 在技术上整合,这个文档描述了一个基本思路是 kv scan 的新方案。

备份原理

备份的原理其实就是 select * ,但是这个方案和 mydumper 的区别:

- 分布式导出数据,数据由各个 region 的 leader 生成,理论上备份的吞吐能达到集群极限。

- 数据是形式是 SST,SST 格式有优点在于能快速恢复,同时可以直接用 rocksdb 自带一些功能比如,数据压缩/加密。

- 数据直接保存第三方存储,比如 S3, GCS 等。

- 备份的一致性保证:SI,需要保证能恢复到 point-in-time 的状态。

备份流程

整个备份过程由独立于 TiKV 的外部程序推进,整体的基本流程:

- 外部程序根据用户指定备份范围下发备份命令到 TiKV,这个外部程序最终会整合到 TiDB 中,入口是 SQL。

- TiKV 接受备份请求后交由 region leader 处理,并使用一个特殊的 iterator 读取数据

- TiKV 读取的数据会被组织成 SST 文件。这里需要控制 IO 和内存使用。

- TiKV 会把 SST 文件写到外部存储,比如自身的本地存储,s3 等,这里需要流控。

- TIKV 把执行信息汇报给外部程序。

- 下推备份到所有 TiKV

- 接受 TiKV Streaming 发过来的备份结果

- 聚合检查是否有范围没有备份到或者发生错误

- 如果有范围错误或者没有备份到则重试

- 重试需要精细化,查询 PD 对应的 leader 然后下发

- 如果外部需要备份 table 或者 database,除了它们的数据外,还需要备份 schema

备份下推

Iterator

在增量备份中,TiKV 需要扫出 一段时间 的增量数据,一段时间具体来说:

[(backup_ts, current_ts]](https://docs.pingcap.com/zh/tidb/stable/backup-and-restore-using-mydumper-lightning)

Key: tablePrefix{tableID}_recordPrefixSep{rowID}

Value: [col1, col2, col3, col4]

Key: tablePrefix{tableID}_indexPrefixSep{indexID}_indexedColumnsValue

Value: rowID

参考文档:

新的恢复 RPC 见这里。

备份 RPC 的相关内容已经可以在 kvproto 仓库 找到。

Backup gRPC 服务

附录

我们通过 Key rewrite 在理论上支持原集群恢复。

原集群恢复涉及到各种 ID 的问题,最简单办法就是 rewrite key,把 key 中老 ID 替换成新 ID。这是 crdb 的方案,我们同样可以借鉴。

- 原集群恢复

我们通过 placement rule 实现资源隔离。

这里的困境是 ingest SST 失败会导致各个副本之间的数据不一致。

- 在线恢复

问题

- 使用备份的 schema 信息创建新表。

- 通过备份的元数据构建 key-value 的范围,同时依照新表 ID 构建 rewirte rules。

- 依照 rewrite rules 和 key 范围分割并打散 regions。

- 调用 download 和 ingest API 完成导入。

现在使用的方案已经不再使用 tikv-importer(它也预计会在 4.0 被移除),转而使用了 TiKV 一组能够下载/导入 SST 文件的新 API。相关的信息可以在这里找到。

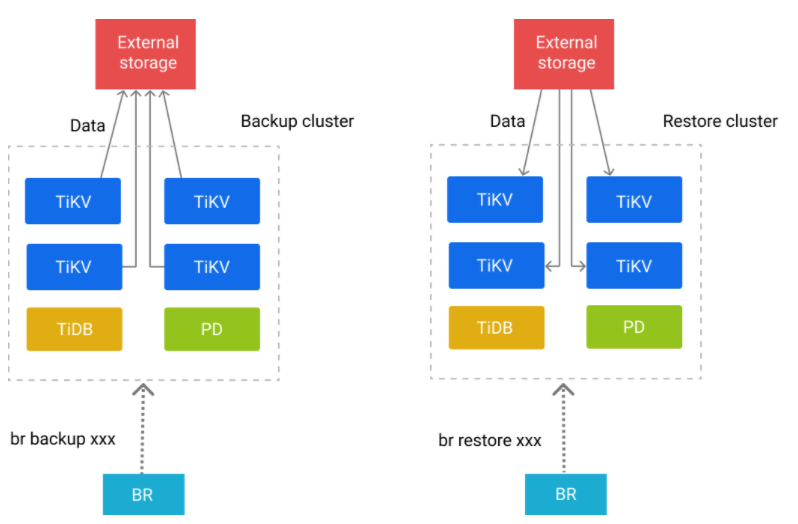

恢复流程

Split & Scatter

为了解决该问题,我们必须在恢复前对 SST 文件进行 key 的改写,将原有的 tableID 替换为新创建的 tableID,同样的 indexID 也需要相同的处理。

在 Key 中编码了 tableID,所以我们不能直接把备份下来的 SST 文件不经任何处理恢复到 TiKV 中,否则就有可能因为 tableID 对不上而导致数据错乱。

Key Rewrite

- 创建需要恢复的 database 和 table

- 根据 table 和 SST 文件元信息,进行 Split & Scatter Region

- 将备份下来的 SST 文件按需读取到 TiKV 各节点

- 根据新 table 的 ID 对 SST 进行 Key Rewrite

- 将处理好的 SST 文件 Ingest 到 TiKV

恢复

超出 GC 时间是说,需要备份的数据已经被 GC,这情况一般发生在增量备份上,会导致增量不完整。在发生这个错的时候,外部程序需要重新来一个全量备份。

超出 GC 时间

除了以上的其他错误都是不可恢复异常,发生后,它们会打断备份的进度。

- RegionError,一般由 region split/merge,not leader 造成。

- KeyLocked,一般由事务冲突造成。

- Server is busy,一般由于 TiKV 太忙造成。

异常处理备份期间的异常和 select * 一样,可分为两种可恢复和不可恢复,所有的异常都可以直接复用 TiDB 现有的机制。