3.2.1 TiDB Cluster Monitoring(K8s 部署的 TiDB 集群监控)

一、Config and Deploy Grafana and Prometheus

- 创建一个拓扑文件.yaml

- metadat.name配置的是TiDB监控本身的名称

- spec.clusters.name配置需要监控TiDB集群本身的名称

- 执行Kubectl apply

$ kubectl apply -f ${tidb-monitor-file}.yaml -n ${namespace}

3.确认监控是否正常启动

$kubectl get pod -l app.kubernets.io/instance=basic -n ${namespace} | grep monitor - 监控数据持久化保持

- 配置persistent true

- 配置storageClassName

- 删除监控

$ kubectl delete tidbmonitor ${tidb-monitor-name} -n ${namespace}

二、Access Grafana and Prometheus

- $ kubectl get svc -n ${namespace}

- $ kubectl -n ${namespace} port-forward svc/${grafana-svc-name} 3000:3000 &>/tmp/pf-grafana.log &

- 通Ingress方式访问

- 首先部署Ingress controller

- 配置监控

- 通过Ingress访问界面

三、Monitor Kubernetes

通过prometheus监控kubernets

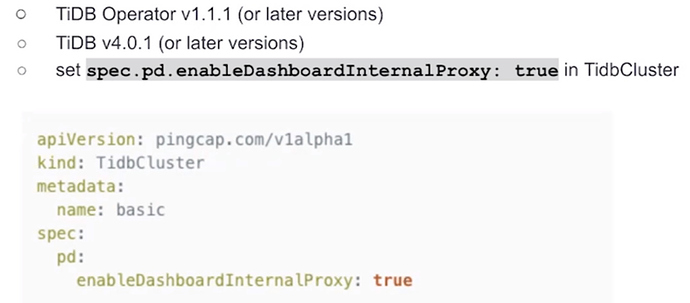

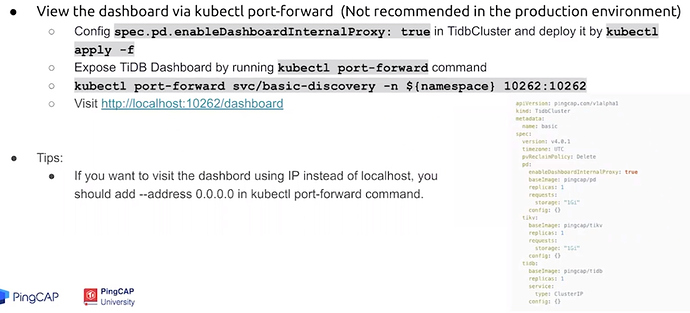

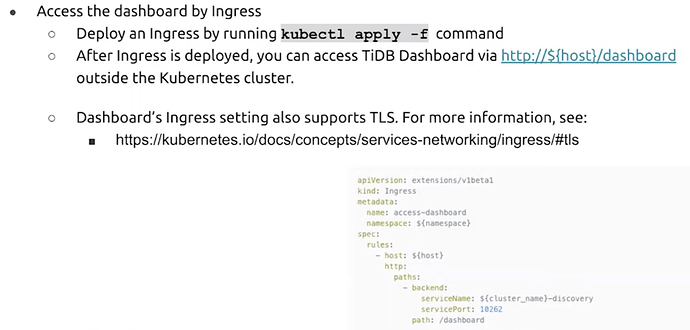

四、Access the dashboard

-

前提

-

通过 kubectl port-forward访问

-

通过Ingress访问

- tidb-monitor.yaml

- Ingress Controllers

- Ingress

- kube prometheus

- [kube-prometheus coreos](

image.jpg1581×312 78.8 KB

image.jpg1581×312 78.8 KB image.jpg1075×473 63.1 KB

image.jpg1075×473 63.1 KB image.jpg1606×730 178 KB

image.jpg1606×730 178 KB image.jpg1529×732 138 KB

image.jpg1529×732 138 KB