非常感谢~

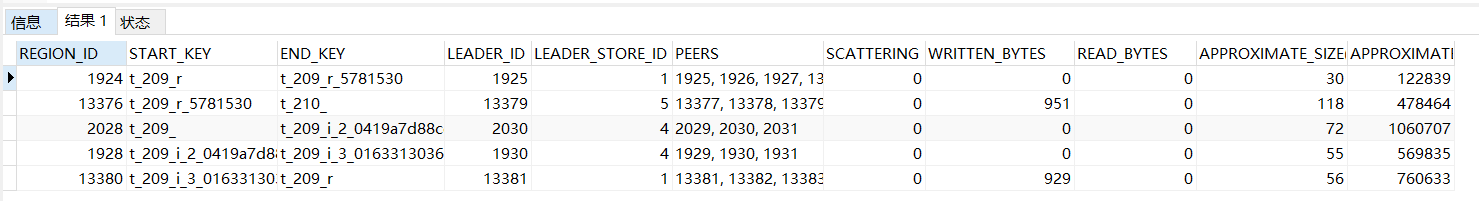

tiup ctl pd -u http://: region 1924

{

“id”: 1924,

“start_key”: “7480000000000000FFD15F720000000000FA”,

“end_key”: “7480000000000000FFD15F728000000000FF58381A0000000000FA”,

“epoch”: {

“conf_ver”: 8,

“version”: 106

},

“peers”: [

{

“id”: 1925,

“store_id”: 1

},

{

“id”: 1926,

“store_id”: 4

},

{

“id”: 1927,

“store_id”: 5

},

{

“id”: 13597,

“store_id”: 13595,

“is_learner”: true

}

],

“leader”: {

“id”: 1925,

“store_id”: 1

},

“down_peers”: [

{

“peer”: {

“id”: 13597,

“store_id”: 13595,

“is_learner”: true

},

“down_seconds”: 77657

}

],

“pending_peers”: [

{

“id”: 13597,

“store_id”: 13595,

“is_learner”: true

}

],

“written_bytes”: 0,

“read_bytes”: 0,

“written_keys”: 0,

“read_keys”: 0,

“approximate_size”: 30,

“approximate_keys”: 122839

}

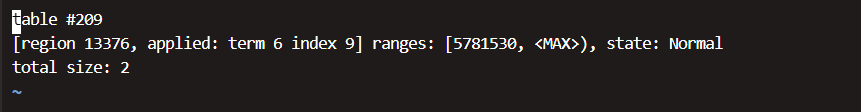

tiup ctl pd -u http://: region 13376

{

“id”: 13376,

“start_key”: “7480000000000000FFD15F728000000000FF58381A0000000000FA”,

“end_key”: “7480000000000000FFD200000000000000F8”,

“epoch”: {

“conf_ver”: 8,

“version”: 105

},

“peers”: [

{

“id”: 13377,

“store_id”: 1

},

{

“id”: 13378,

“store_id”: 4

},

{

“id”: 13379,

“store_id”: 5

},

{

“id”: 13598,

“store_id”: 13595,

“is_learner”: true

}

],

“leader”: {

“id”: 13379,

“store_id”: 5

},

“written_bytes”: 951,

“read_bytes”: 0,

“written_keys”: 2,

“read_keys”: 0,

“approximate_size”: 118,

“approximate_keys”: 478464

}

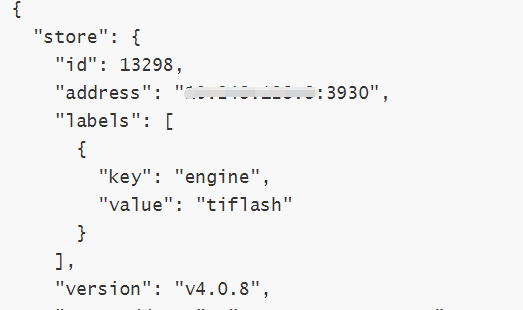

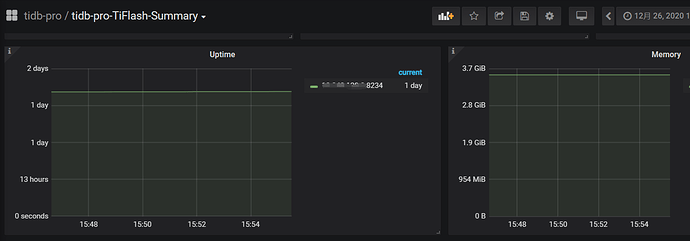

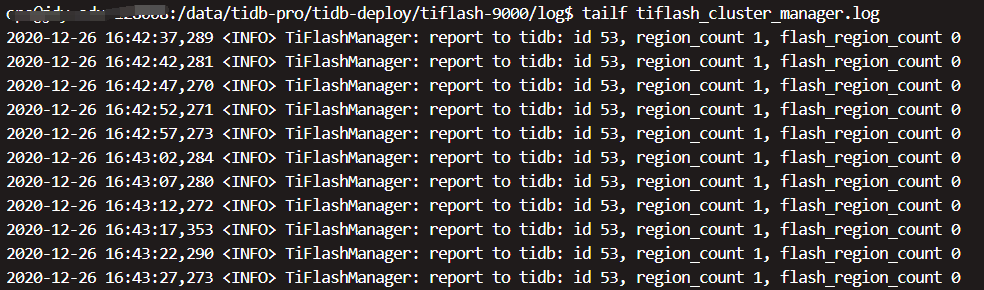

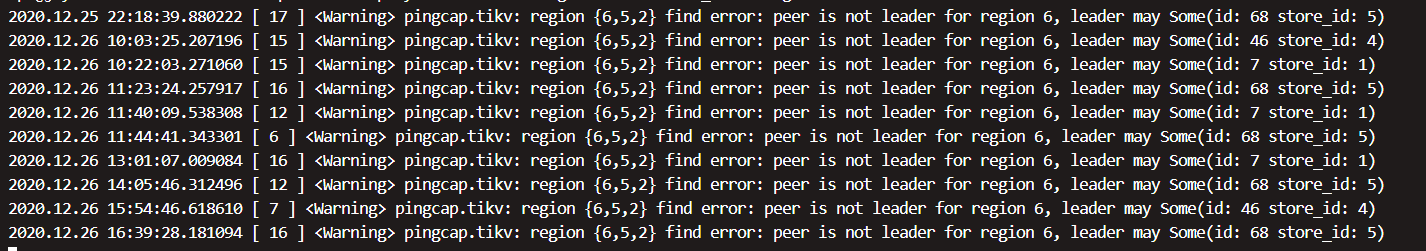

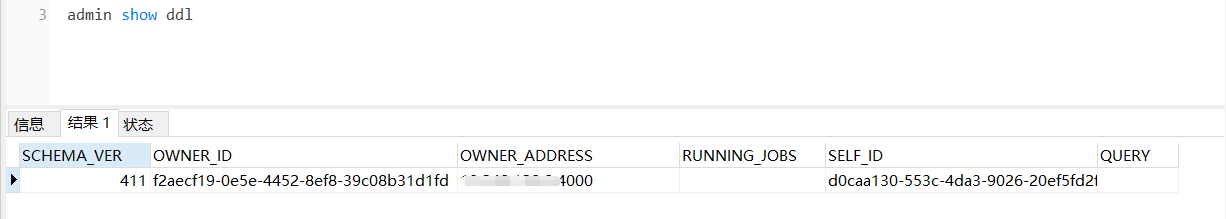

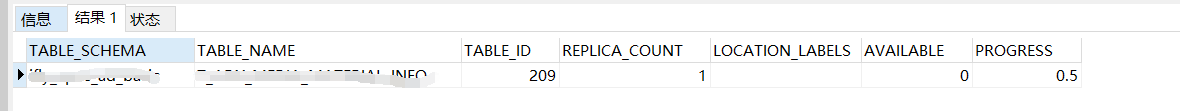

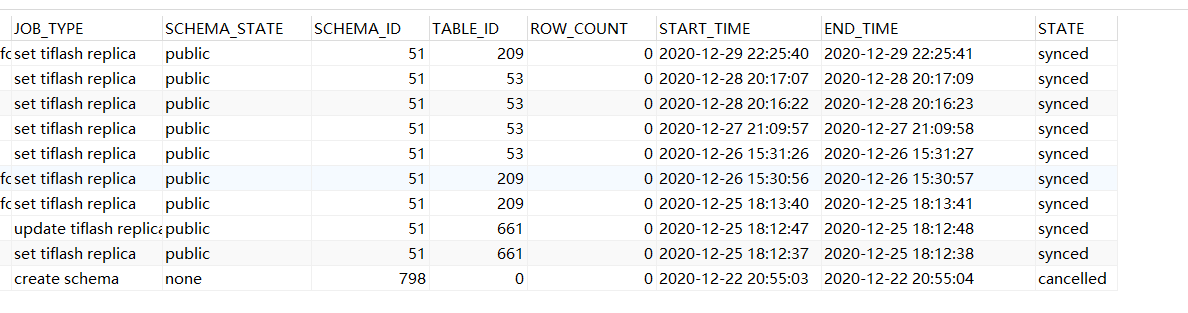

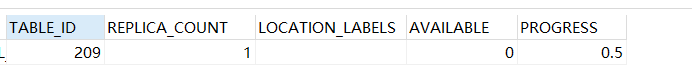

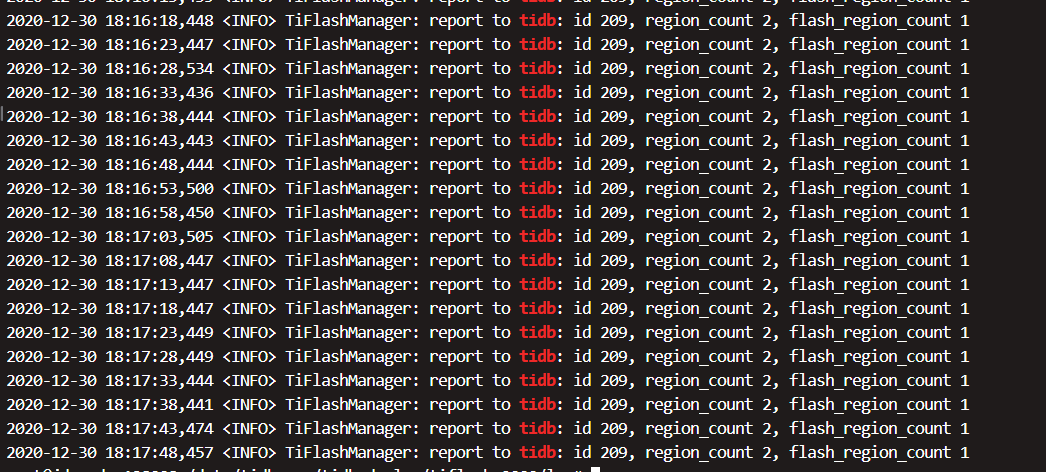

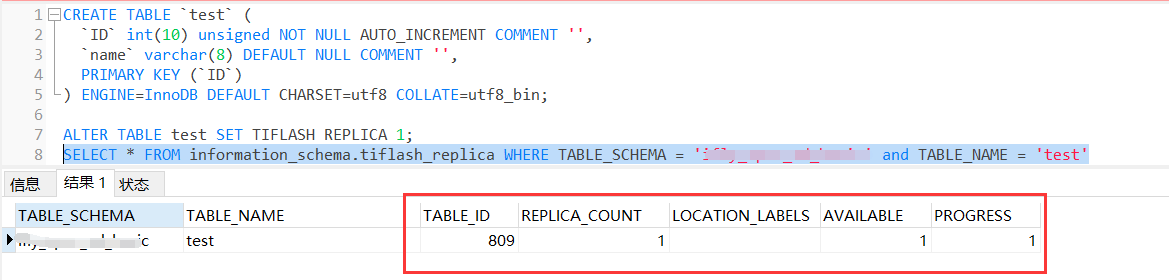

集群中一直只有 1个 TiFlash 节点,但这个节点部署过两次

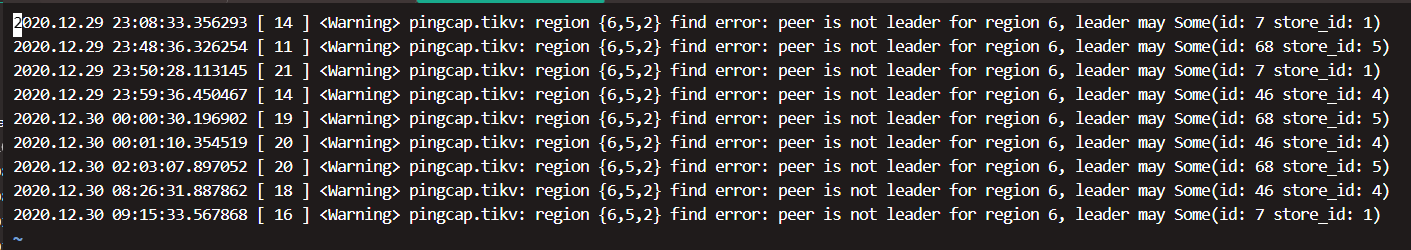

2020/12/25 18点 第一次部署成功,然后同步数据表副本不可用,未排查出原因后强制下线了。

2020/12/29 22点 第二次部署成功