【 TiDB 使用环境`】生产环境

【 TiDB 版本】5.4

【遇到的问题】

我们生产环境刚开始部署的时候,将prometheus、grafana和PD混合部署在同一台机器了,现在发现有点不稳定,想要将prometheus和grafana迁移到一台新机器上面去。

历史监控的数据无所谓,可以丢弃。只需要将服务迁移出来即可。我初步打算是重新在新机器部署prometheus和grafana,然后停掉原来的prometheus和grafana,我看了“手动部署监控” 文档,我发现文档里面的配置文件和现有集群里面的prometheus.yml的配置文件差距比较大,为了避免生产环境GG,所以想问一下各位大佬,有没有更好的迁移方案,或者有没有相关的文档可以参阅,谢谢

版本一致的情况下,应该是一样的,可以贴一下截图,看看有哪些不一样的地方。

也可以考虑采用扩容缩容的方式,进行重新部署。

扩容缩容的方式。

扩容缩容就可以,社区有同学尝试过

扩缩容的方式来部署迁移 历史数据就丢失了

不在乎历史数据,先缩容再扩容最简单,两条命令就可以搞定

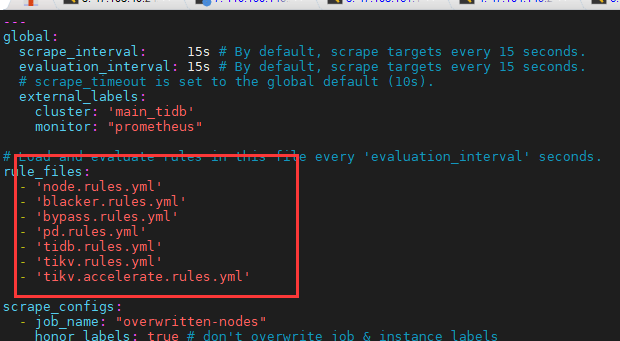

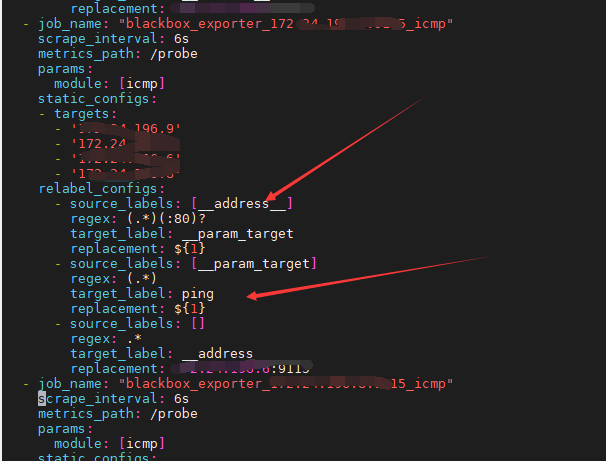

比如说rule的配置文件和下面的job抓取metrics配置文件,tiup安装会默认引进来这些配置文件,但是自己手动安装就不太确定能不能弄对。

大概明白了,谢谢

大概明白了,谢谢。监控历史数据不重要,丢了就丢了,没啥事平常都懒得看

这样就好了吗?

tiup cluster scale-in <cluster-name> --node x.x.x.x: 9090

tiup cluster scale-out <cluster-name> scale-out.yml

![]() 感觉先扩容再缩容会好一点~

感觉先扩容再缩容会好一点~

先扩再缩就不会丢数据是吧

会丢。因为上面写了不要原来老的prometheus数据,大家才都建议扩容缩容这么做。

不想丢prometheus,就找到原来老的prometheus的数据目录,如果没有做修改,将会是/tidb-data/prometheus-9090,把里面的内容传到扩容的服务器上,同时设置拓扑文件中的monitoring_servers下的data_dir,指向这个目录。

https://docs.pingcap.com/zh/tidb/stable/tiup-cluster-topology-reference#monitoring_servers

扩容就可以了

先扩容新的机子,完了再缩容?

先扩容一个grafana和一个prometheus,再缩容老的,注意安装目录就行了。

![]() 这个是真没有想到。这么想想不知道prometheus支不支持数据导出导入,如果支持就简单了。

这个是真没有想到。这么想想不知道prometheus支不支持数据导出导入,如果支持就简单了。

明白了,等于扩容后是写了两份独立的数据

先扩容,没有问题在缩容就行了

历史数据没意义。扩容,缩容就好了。

tiup cluster scale-in --node x.x.x.x: 9090

tiup cluster scale-out scale-out.ym

写好你的配置文件就好、