lazzyfu

(Lazzyfu)

1

TiDB版本:4.0.7

TiKV参数:storage.block-cache.capacity: 29GB

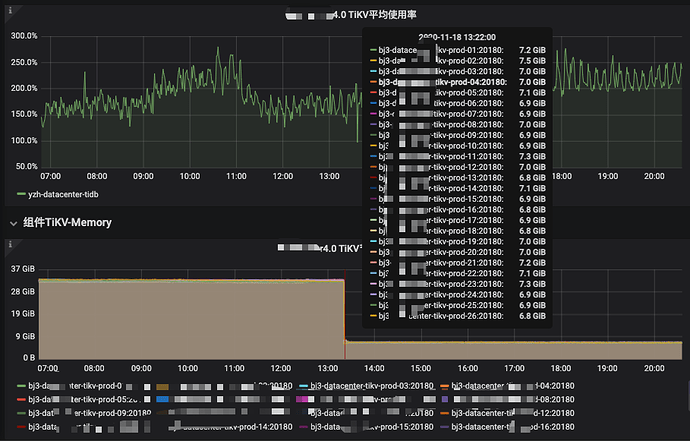

内存使用监控如下图:

可以从上图看到在2020-11-18 13:22分左右,所有TiKV节点的内存突然下降,通过翻看相关文档发现

参数:storage.block-cache.capacity 貌似被更新为了4GB。

在此期间,未人工修改过参数或重启过tidb集群

期间做个什么?

有用tidb-lightning导入过数据,使用的是TiDB-backend模式

请问这是什么原因导致的,感觉像是触发了什么机制,使用了默认的capacity配置

lazzyfu

(Lazzyfu)

2

这是异常期间的tikv日志

tikv.log (1.7 MB)

lazzyfu

(Lazzyfu)

4

已经定位到问题了,导入时,tikv会修改内存,代码位置:

https://github.com/tikv/tikv/blob/bc0a9b3974f32cc2e08244a6eaf5284e5e5f4d76/components/sst_importer/src/import_mode.rs#L105

impl ImportModeCFOptions {

fn new() -> ImportModeCFOptions {

ImportModeCFOptions {

block_cache_size: 4 << 30,

level0_stop_writes_trigger: 1 << 30,

level0_slowdown_writes_trigger: 1 << 30,

soft_pending_compaction_bytes_limit: 0,

hard_pending_compaction_bytes_limit: 0,

}

}

貌似贵公司还没merge